人工智能爱好者必须在群辉NAS上建立Llama 2大语言模型私人聊天机器人策略

文章目录。

- 前言。

- 1. 拉相关Docker镜像。

- 2. 操作Olllama 镜像。

- 3. 操作Chatbot Ollama镜像。

- 4. 本地访问。

- 5. Cpolar安装在群晖中。

- 6. 配置公网地址。

- 7. 公网访问。

- 8. 固定公网地址。

前言。

本文将分享如何在群辉NAS上本地部署和运行基于大语言模型的Llamama 2个人聊天机器人,并结合内网穿透工具实现公网远程访问。由于当地部署对设备配置有一定的要求,为了获得更好的体验,建议使用高性能服务器。

目前,大多数基于在线服务的大型语言模型产品。如果你想在当地部署一个大语言模型应该怎样操作?f;接下来,我们将介绍一个可以在当地运行的大语言模型——Llama 2。

Llama 2是开源大语言模型,训练数据已达到7B级在单轮和多轮对话中表现出色,长度为4K。成功部署和运行Llama 2,有必要使用一个名为Ollama的框架。

Ollama是一个强大的框架,在Docker容器中部署大型语言模型(LLM)的过程。通过提供简单的安装指令,使用户能够轻松地在本地运行大型开源语言模型。

使用Ollama框架Llama可以很容易地运行 两大语言模型。同时,为了与模型交互,Web交互界面也需要部署——Chatbot-Ollama。

Chatbot-基于Ollama框架的聊天机器人前端应用Ollama。Olllama提供的接口和功能,将大型语言模型集成到聊天机器人中,能够与用户互动,并提供多种聊天服务。

Llama通过将Chatbot-ollama连接到本地ollama框架进行操作 2大语言模型,本地聊天机器人很容易创建。但是,Chatbot-Olllama的本地部署仅限于本地访问,无法提供远程访问。所以,我们还需要安装内网穿透工具cpolar#xff0c;本地聊天机器人可以远程访问。

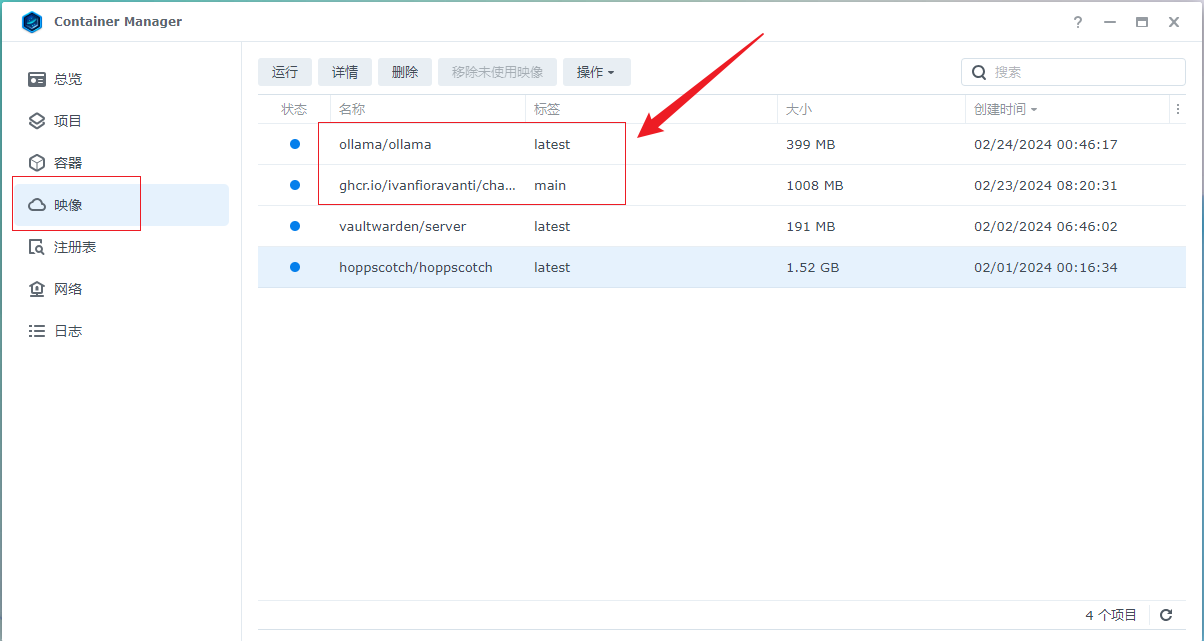

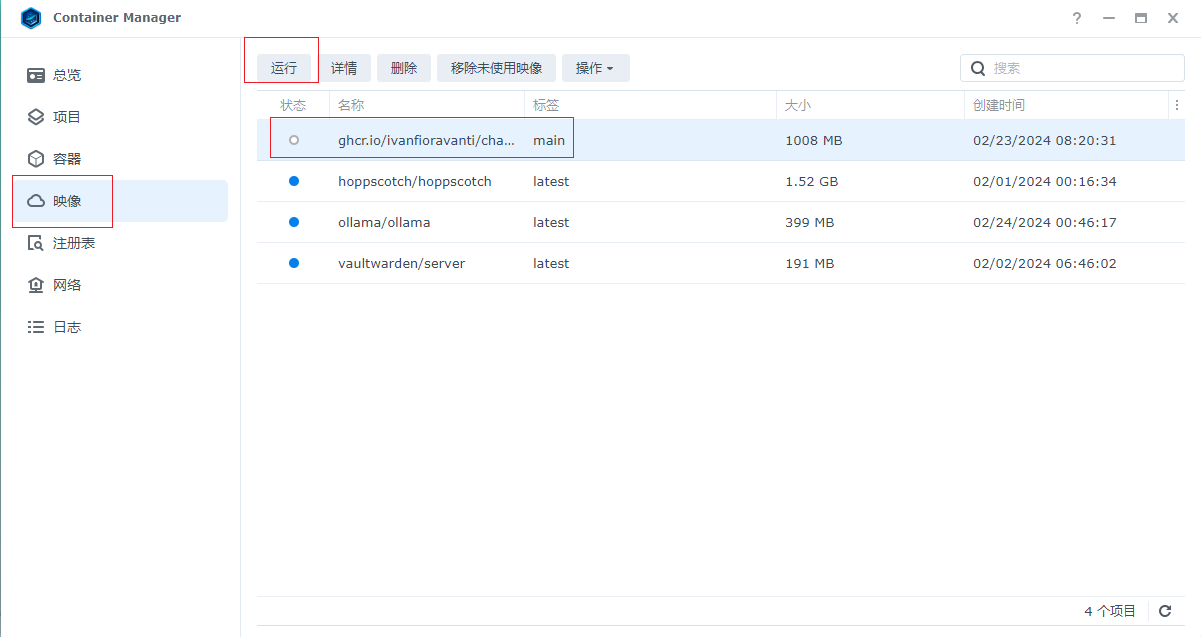

1. 拉相关Docker镜像。

运行Llama 2需要使用Ollama镜像来交互语言模型需要使用Chatbot-Ollama前端界面,所以我们需要拉这两个docker镜像,这个群辉版本因为不能直接在群辉控制面板docker界面搜索下载镜像,所以使用命令行下载镜像,首先打开群辉ssh连接,然后使用工具通过ssh连接群辉,分别执行以下docker命令 拉取。

*拉Olllama镜像命令。

sudo。docker。pull ollama/ollama:latest。*拉取Chatbot-ollama镜像命令。

sudo。docker。pull ghcr.io/ivanfioravanti/chatbot-ollama:main。拉取成功后,我们可以在docker界面上看到拉取的两个镜像,下面开始运行两个镜像,首先运行ollama。

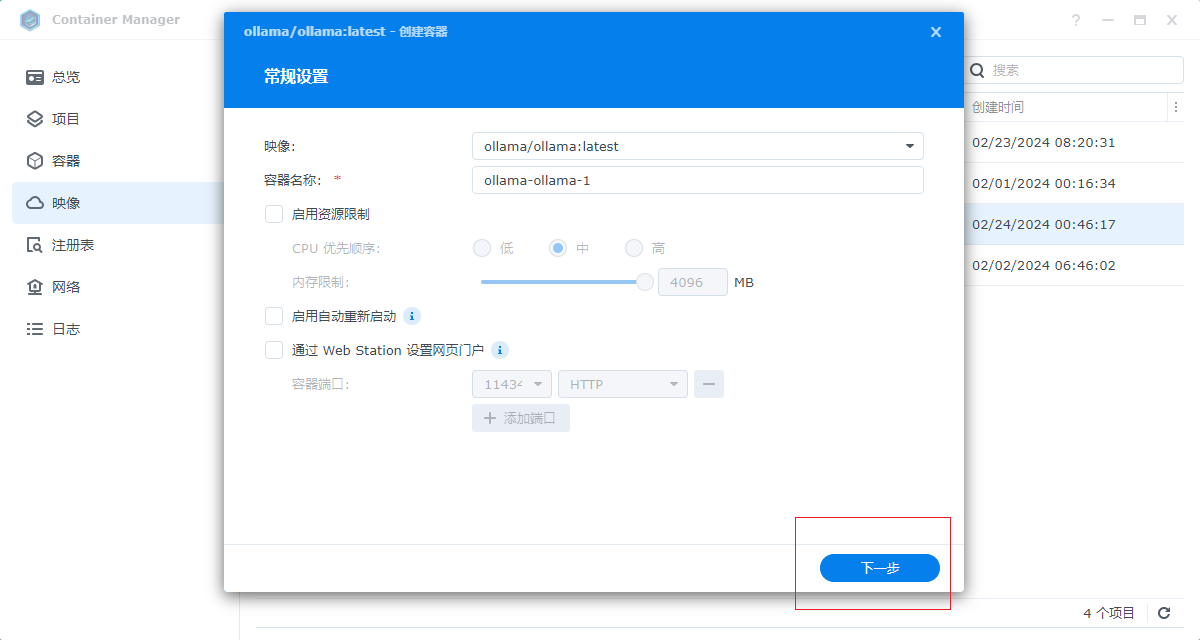

2. 操作Olllama 镜像。

选择镜像,点击操作进入配置界面,无需设置名称,默认,然后点击下一步。

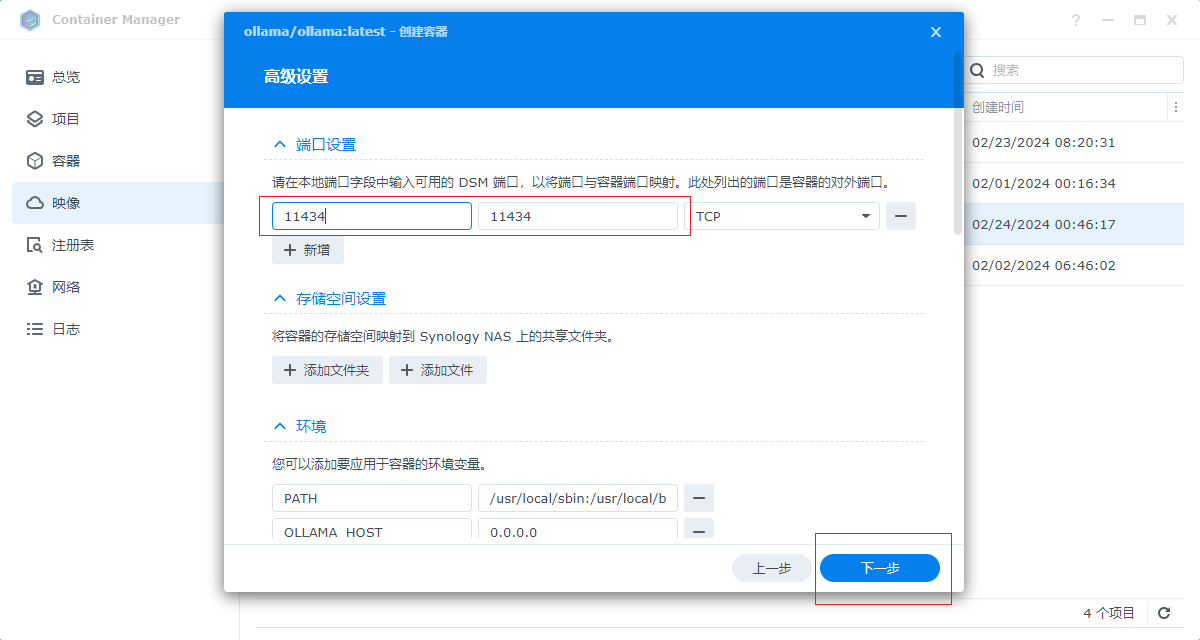

输入与容器内部端口一致的外部访问端口,填写11434,然后单击下一步。

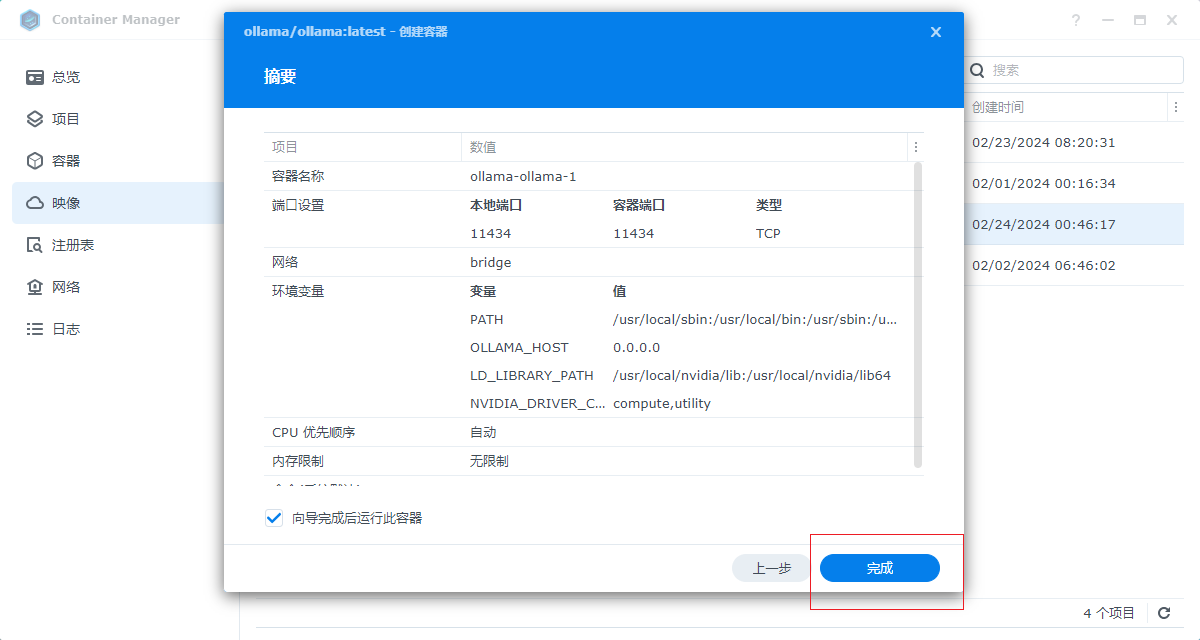

然后点击完成操作ollama。

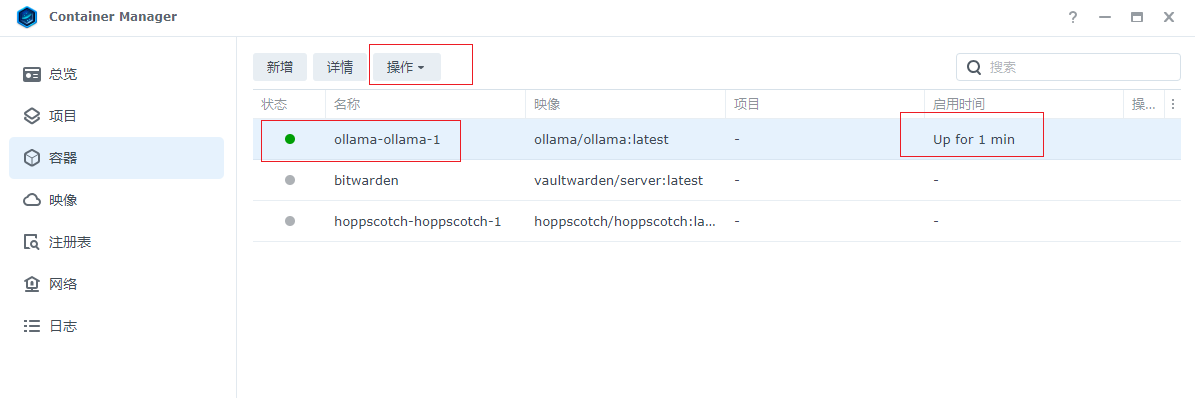

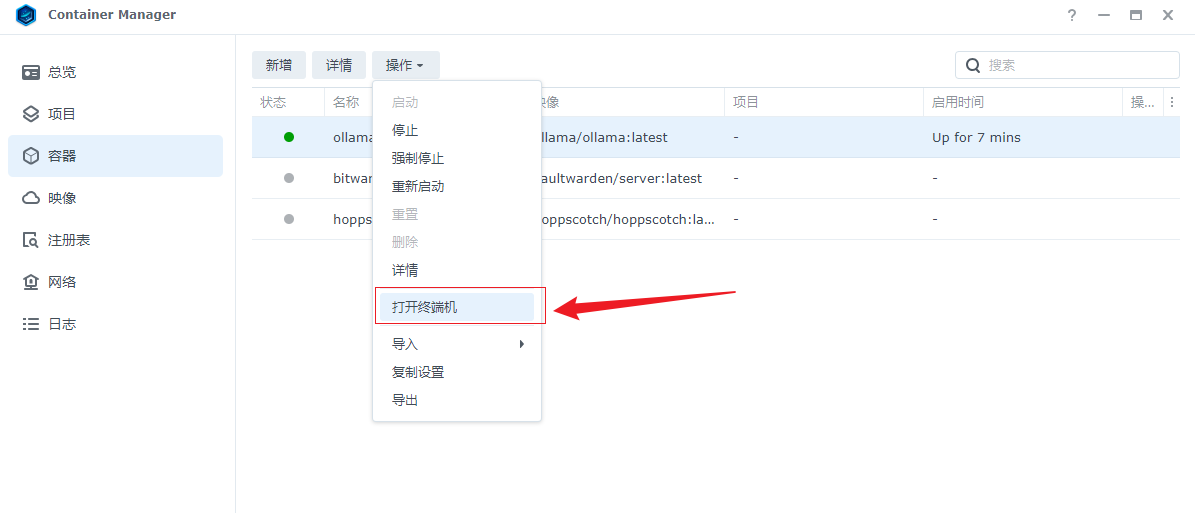

运行后,打开容器界面,可以看到运行服务,下面开始下载运行Llama 2模型,点击选择ollama容器,点击操作。

然后打开终端,进入终端命令界面。

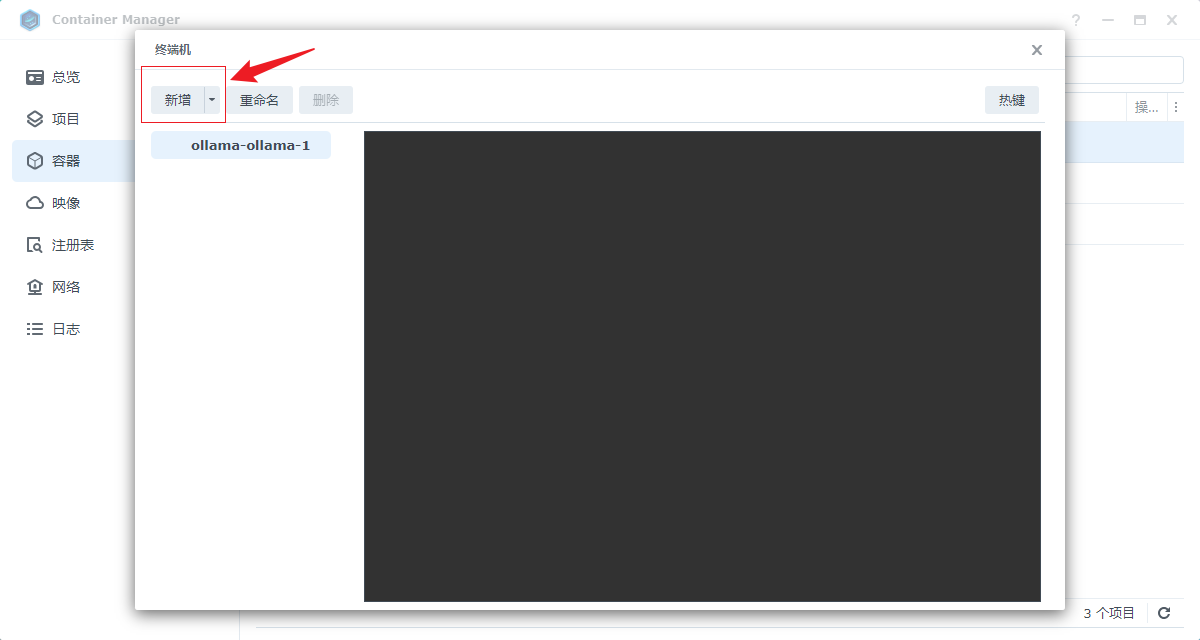

然后选择在左边添加一个新的bash命令界面。

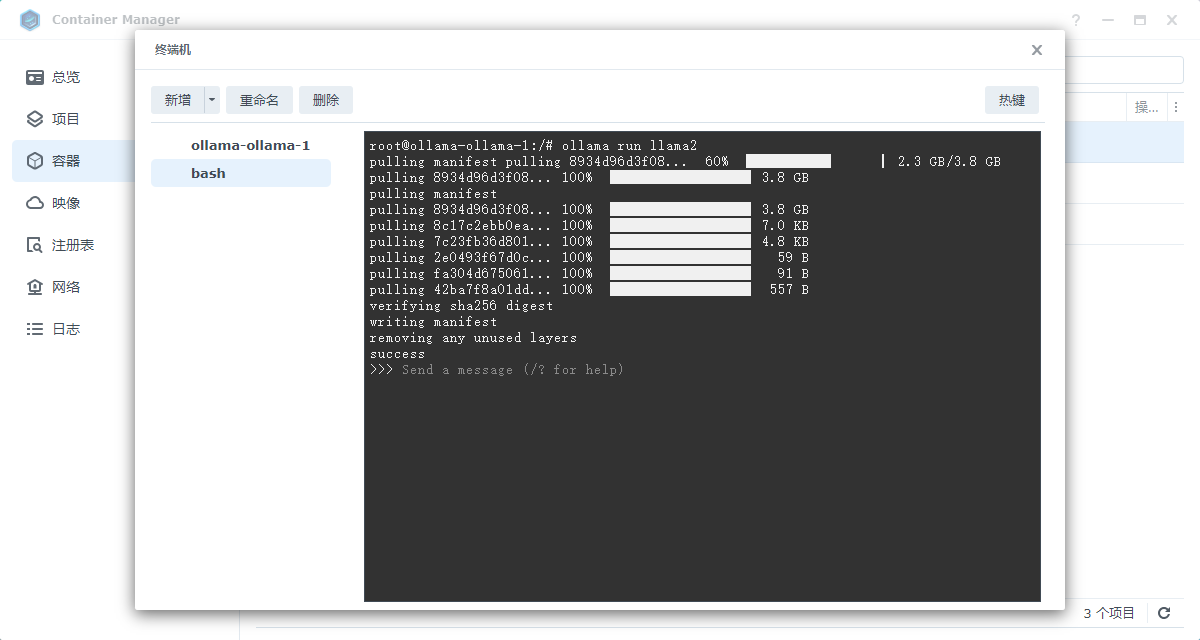

然后在bash命令界面执行。ollama run llama2。命令,然后等待下载,最后出现success,表示下载操作Llama 2模型成功,下载后可关闭窗口。这样ollama就可以了。 启动容器并运行Llama 2模型成功,以下是配置前端交互界面的chatbot-ollama镜像。

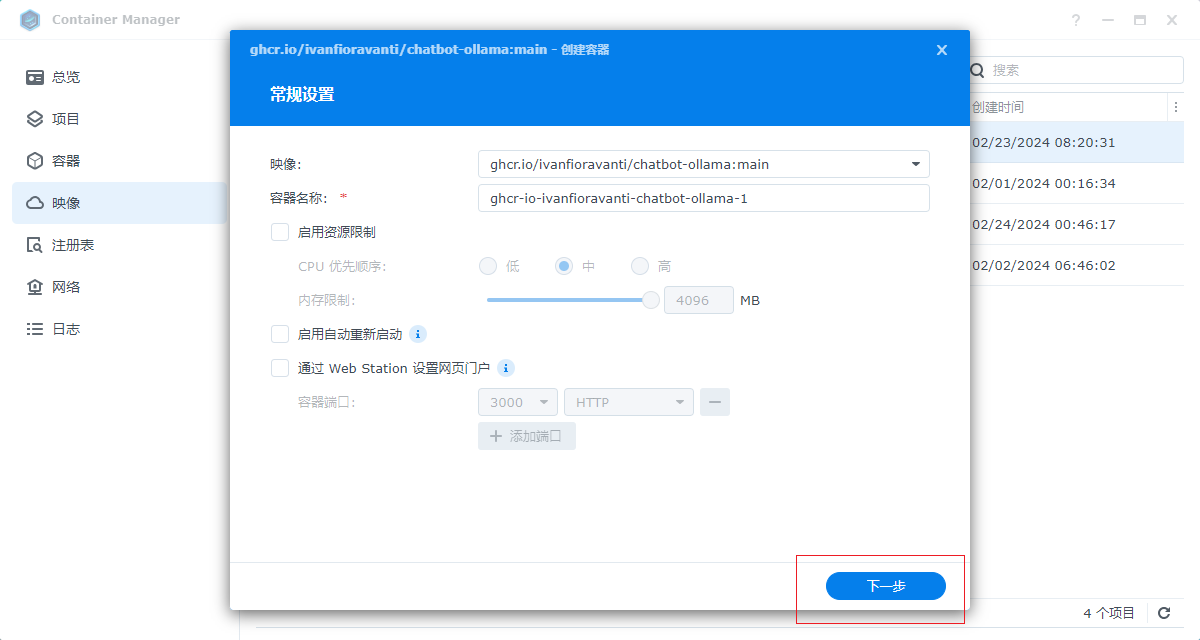

3. 操作Chatbot Ollama镜像。

选择我们下载的镜像,点击操作,开始设置。

默认名称,直接点击下一步。

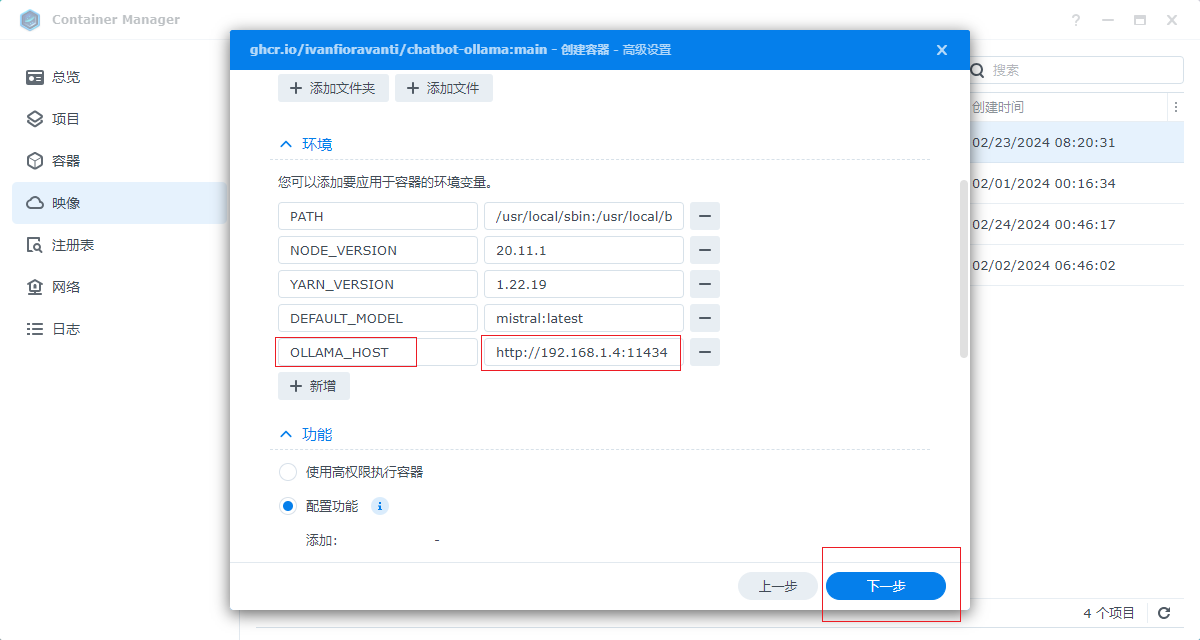

设置对外端口,本例设置3001,可自定义。这个端口也是我们浏览器上web访问的端口。

然后设置环境变量,即连接Ollama框架服务的地址,我们设置本地地址:。http:///群辉局域网IP:11434。设置完成点击下一步,然后直接点击完成,chatbot Ollama镜像运行成功,然后我们进行本地访问.。

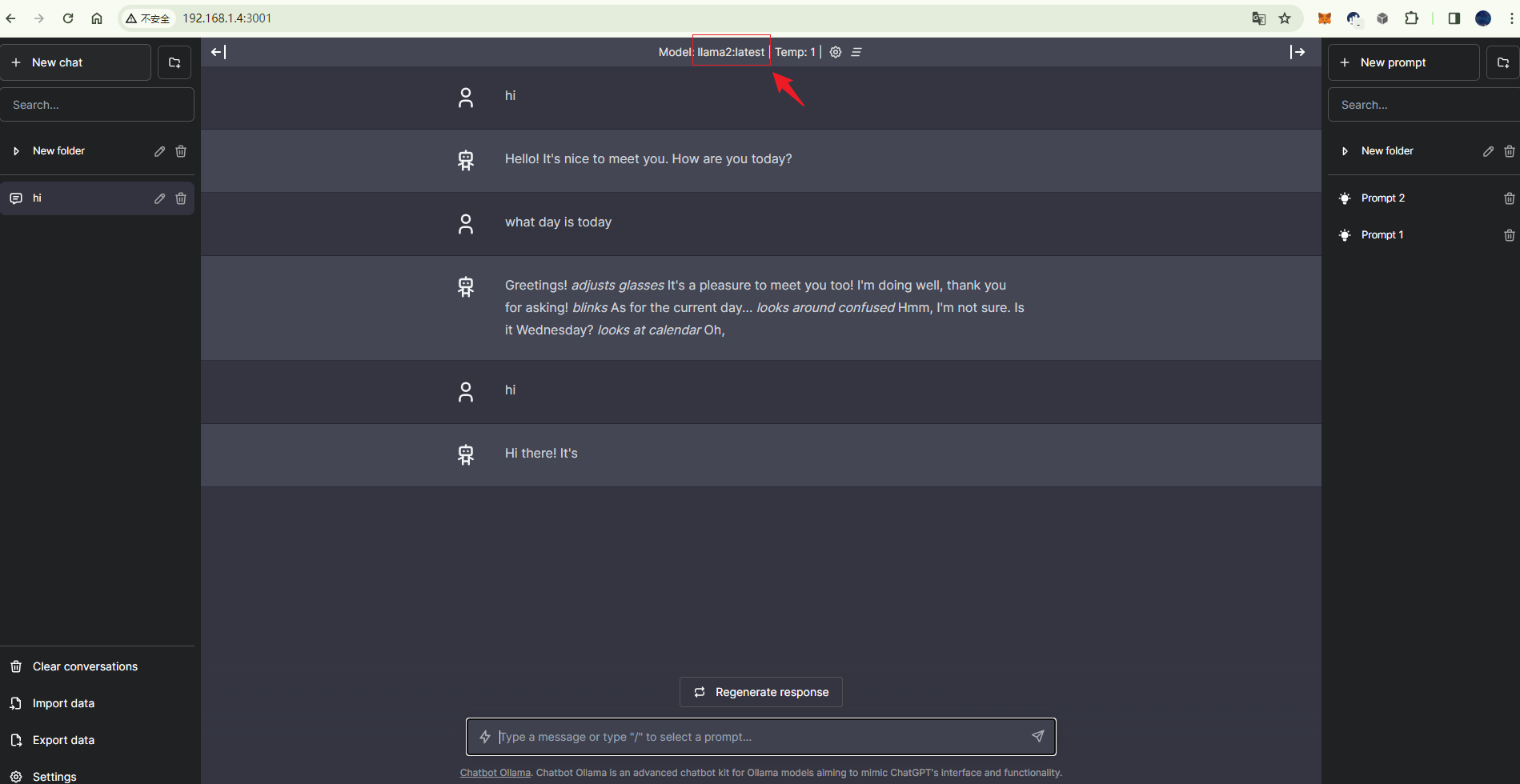

4. 本地访问。

上面我们的操作设置chatbott ollama 对外端口为3001(以自己设置为准)。让我们在浏览器中访问群辉3001端口,这样我们就可以看到我们的网络交互 界面,同时,上面显示llama2模型,输入文本对话,本地部署机器人完成,对话响应速度取决于设备配置,尝试使用高配置服务器运行部署哦,本地完成后,我们设置远程访问,安装cpolar工具,实现无公共网络IP也可以远程访问我们的聊天机器人界面!。

5. Cpolar安装在群晖中。

点击下面的Cpolar群辉套件下载地址,下载相应版本的群辉cpolar套件。

https://www.cpolar.com/synology-cpolar-suite,

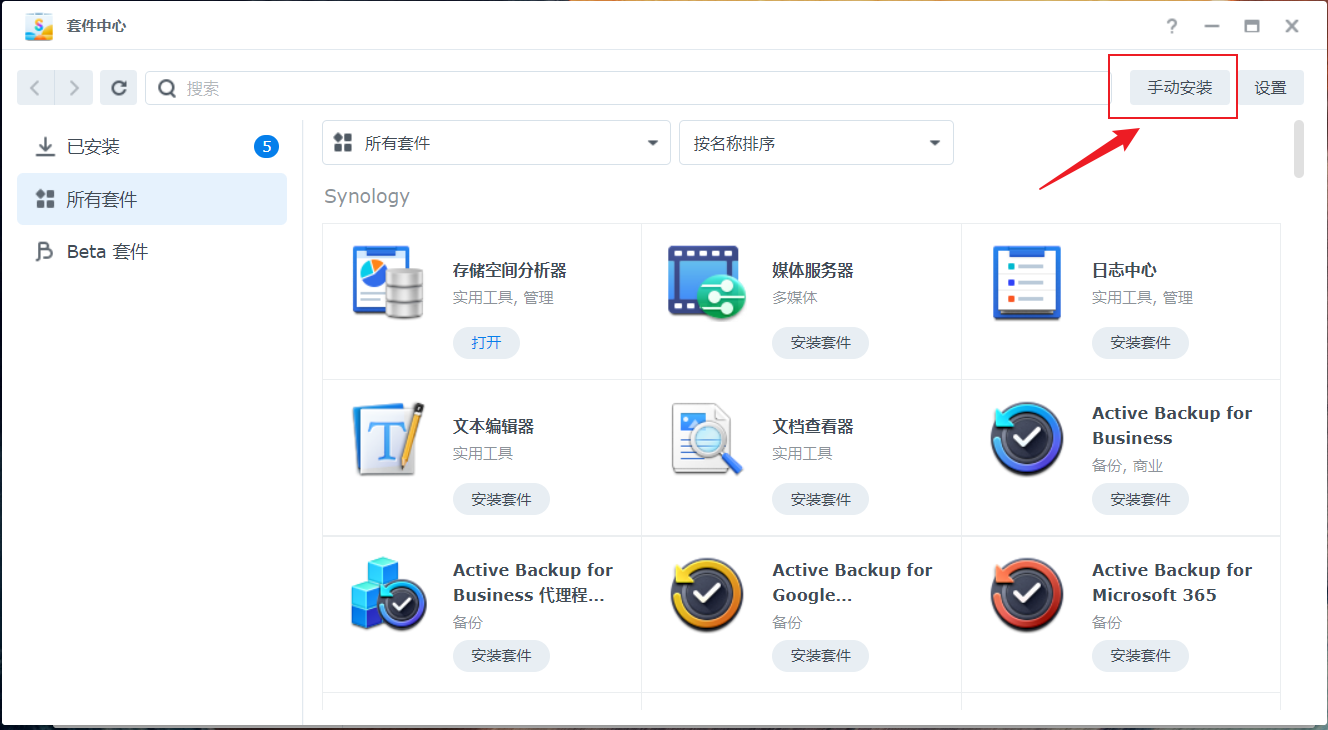

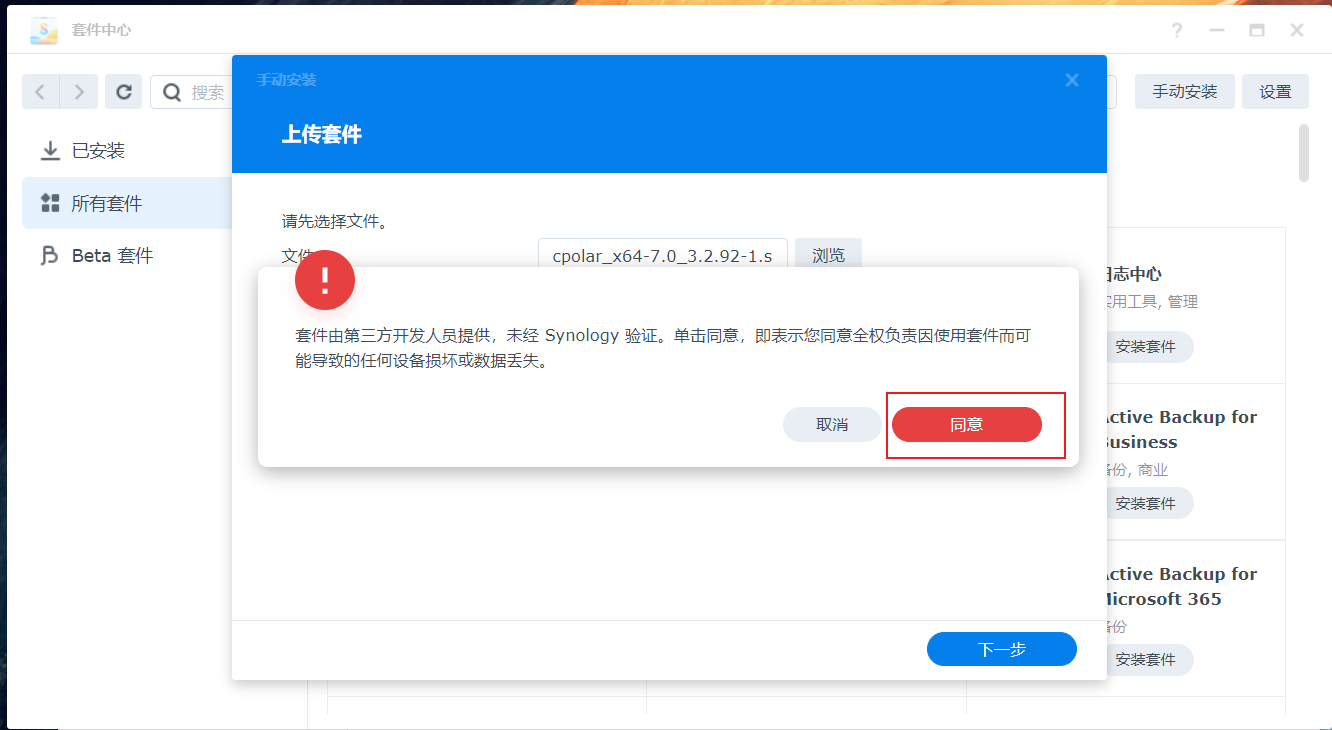

打开群晖。套件中心。,点击右上角。手动安装。按钮。

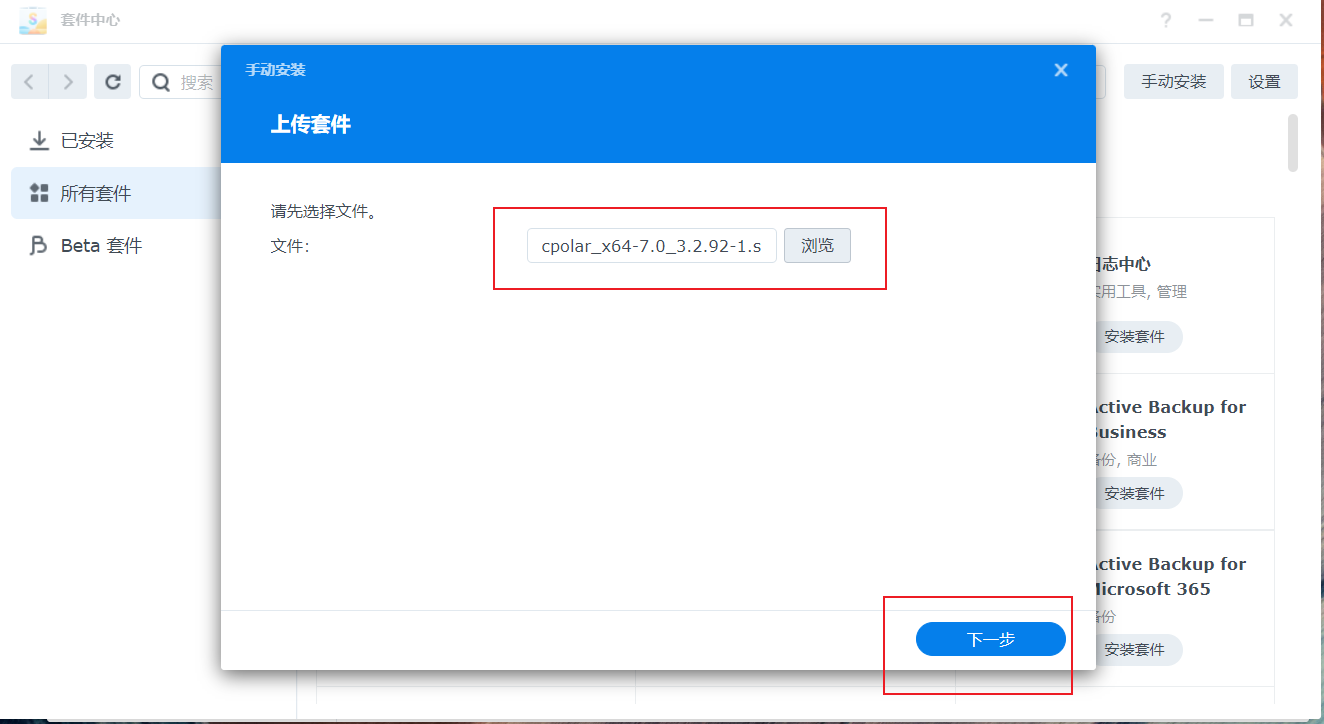

选择本地下载的cpolar套件安装包,然后点击下一步。

点击。同意。按钮,然后点击下一步。

最后点击完成即可。

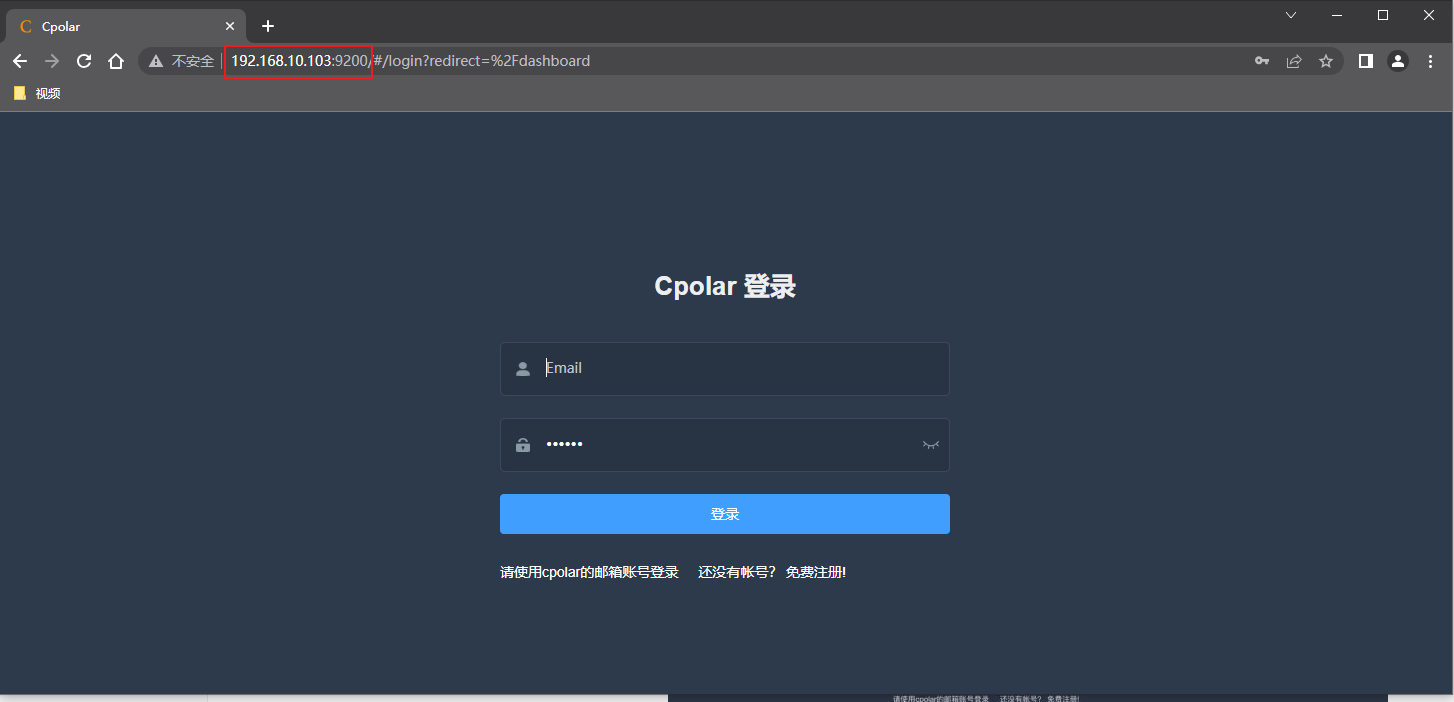

安装完成后,我们通过外部浏览器。群辉局域网ip地址。加。9200。访问Cpolar的Web管理界面,然后输入Cpolar邮箱账号和密码登录,如果没有账号,可以在官网注册:

cpolar官网地址:https://www.cpolar.com/。

6. 配置公网地址。

点击左侧仪表板的隧道管理-创建隧道,创建chatbot公网地址隧道!。

- 隧道名称:可自定义命名注意不要与现有的隧道名称重复。

- 协议:选择http。

- 地址:3001 (本地访问端口)。

- 域名类型:免费选择随机域名。

- 区域:选择China。

点击。创建。

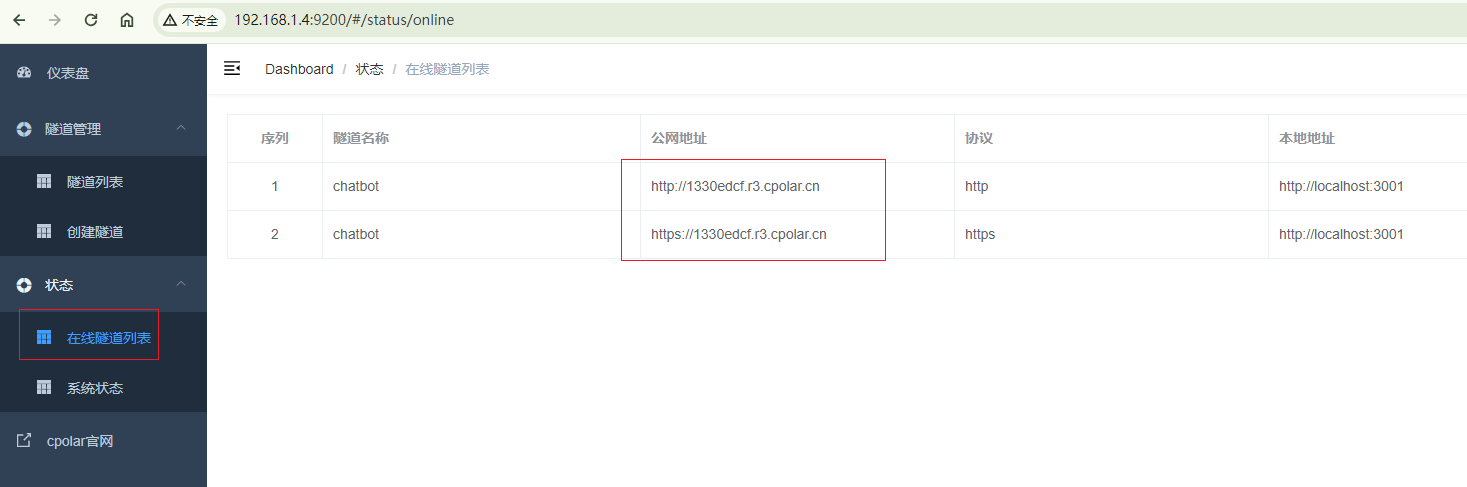

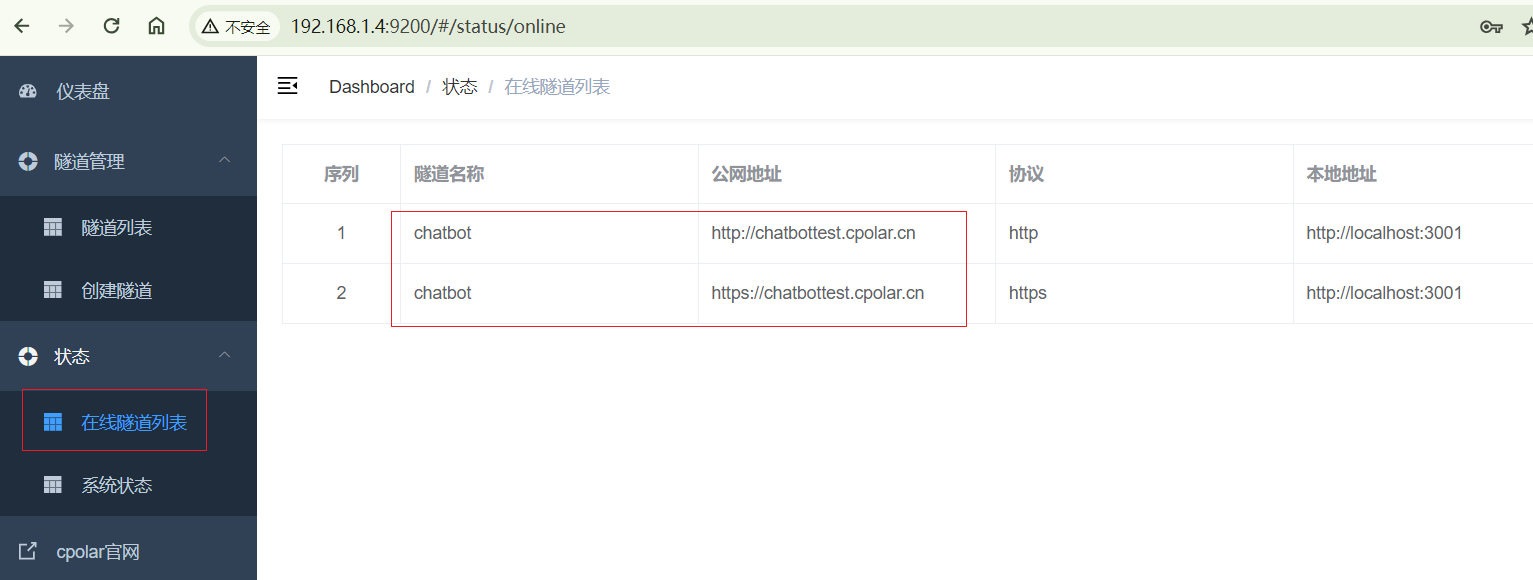

隧道建成后,点击左侧状态-在线隧道列表,查看生成的公共网络访问地址,有两种访问方式,一种是http 以下是https,我们使用生成的http地址进行访问。

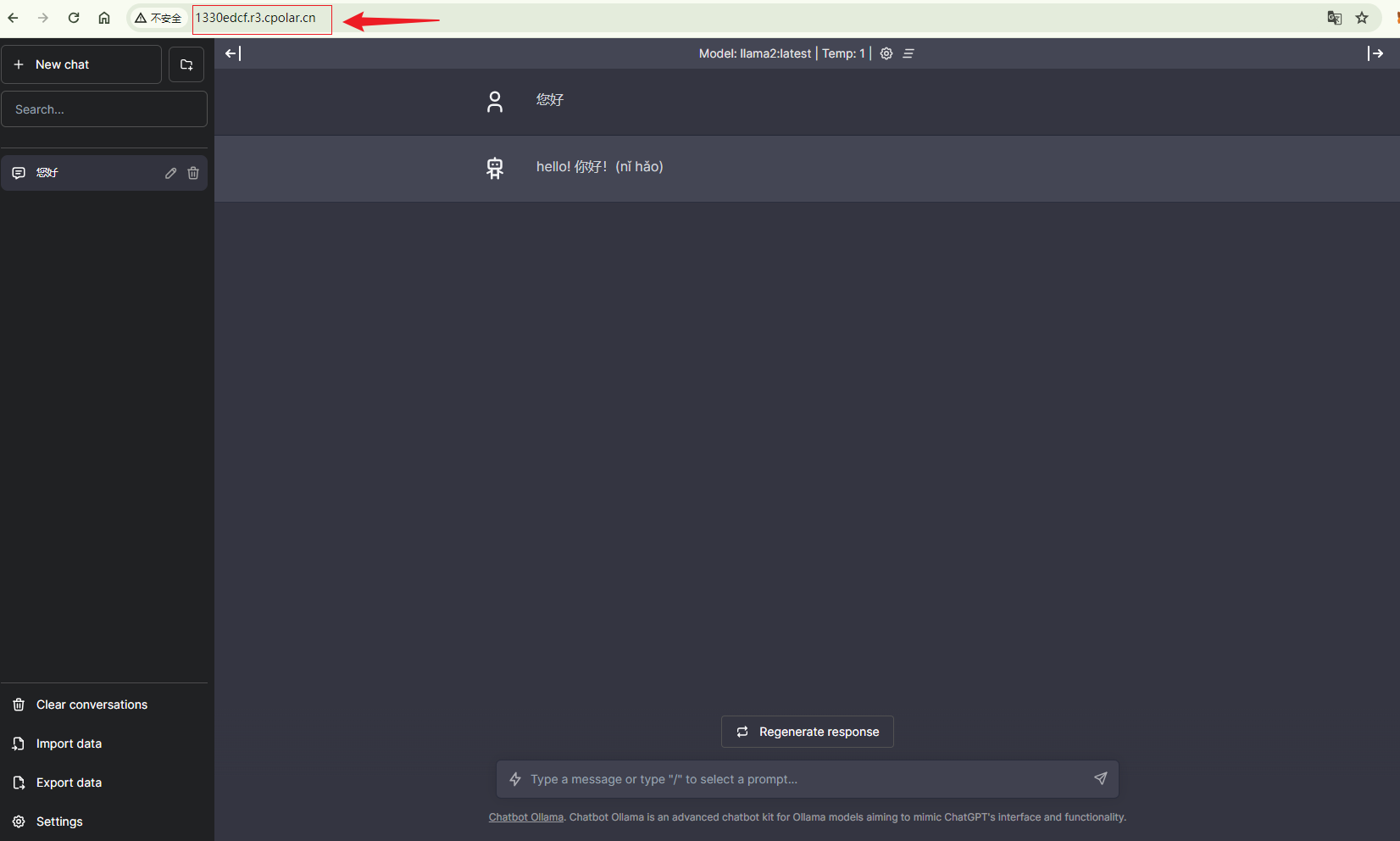

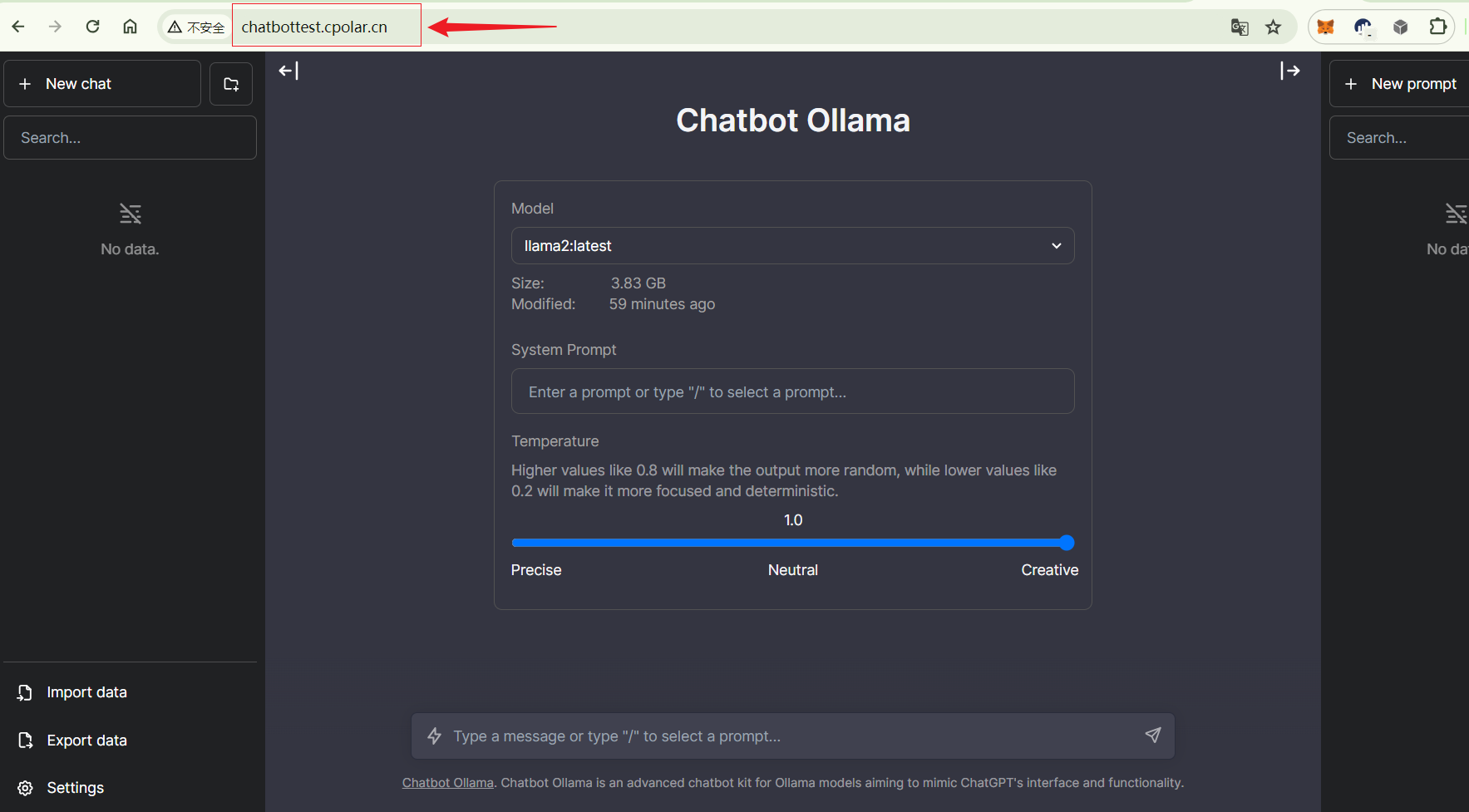

7. 公网访问。

使用上述cpolar生成的http地址,您还可以在浏览器访问中看到聊天机器人的主界面。公共网络地址访问成功。我们可以在没有公共网络IP和云服务器的情况下将本地聊天机器人发布到公共网络进行访问!。

小结。

为了更好地演示,在上述过程中,我们使用了cpolar生成的隧道,其公网地址是随机生成的。

这种随机地址的优点是建立速度快,可立即使用。但是,其缺点是网站由随机字符生成,#xff08不容易记住;例如:3ad5da5.r10.cpolar.top)。此外,该地址将在24小时内随机更改,更适合临时使用。

我通常使用固定的二级子域名,原因是我想把网站发给同事或客户时,它是一个固定易记的公共网站地址(例如:chatbot.cpolar.cn),这样更加正式便于流交合作。

8. 固定公网地址。

由于上述使用Cpolar创建的隧道使用随机公共网络地址,24小时内随机变化,不利于长期远程访问。因此,我们可以配置二级子域名,该地址为固定地址,不会随机变化。

登录cpolar官网,点击左侧预留,选择保留二级子域名设置二级子域名,点击保留,保留成功后保留的二次子域名。

保留成功后,复制保留成功的二级子域名的名称。

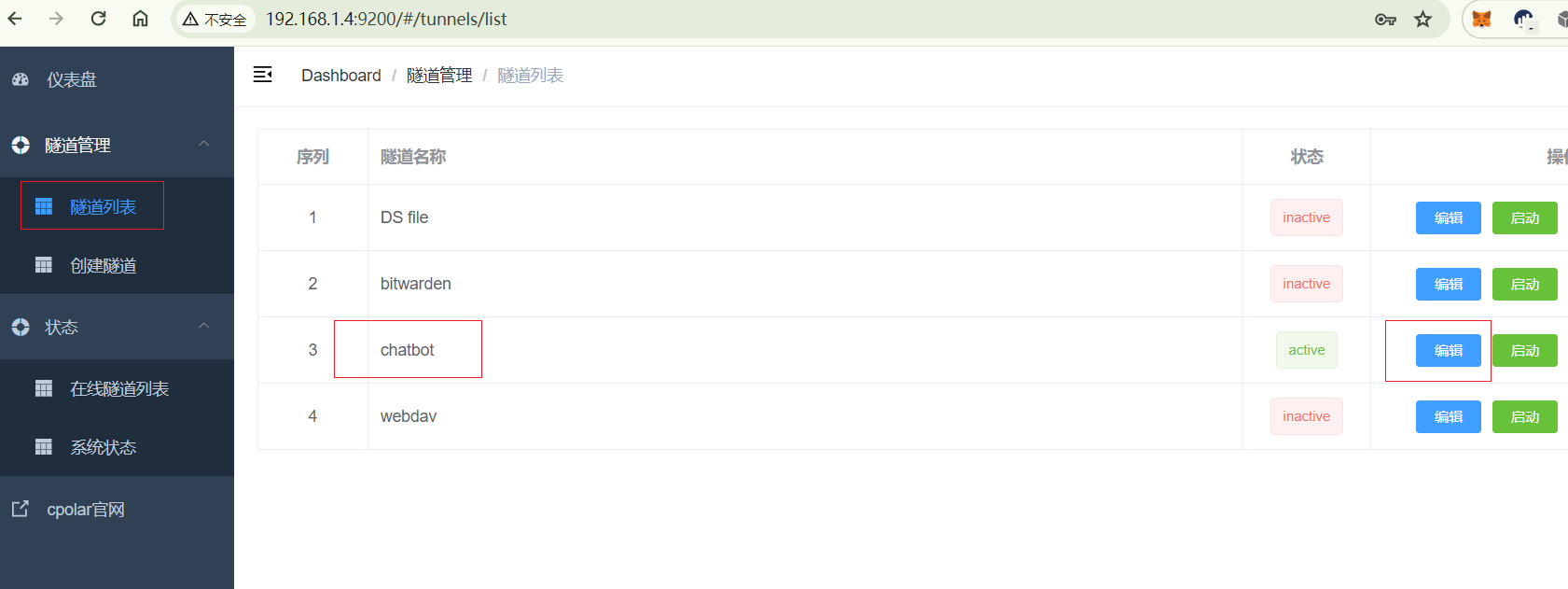

回到Cpolarar登录 web UI管理界面,点击左侧仪表板的隧道管理-隧道列表,找到要配置的隧道,点击右侧的编辑器。

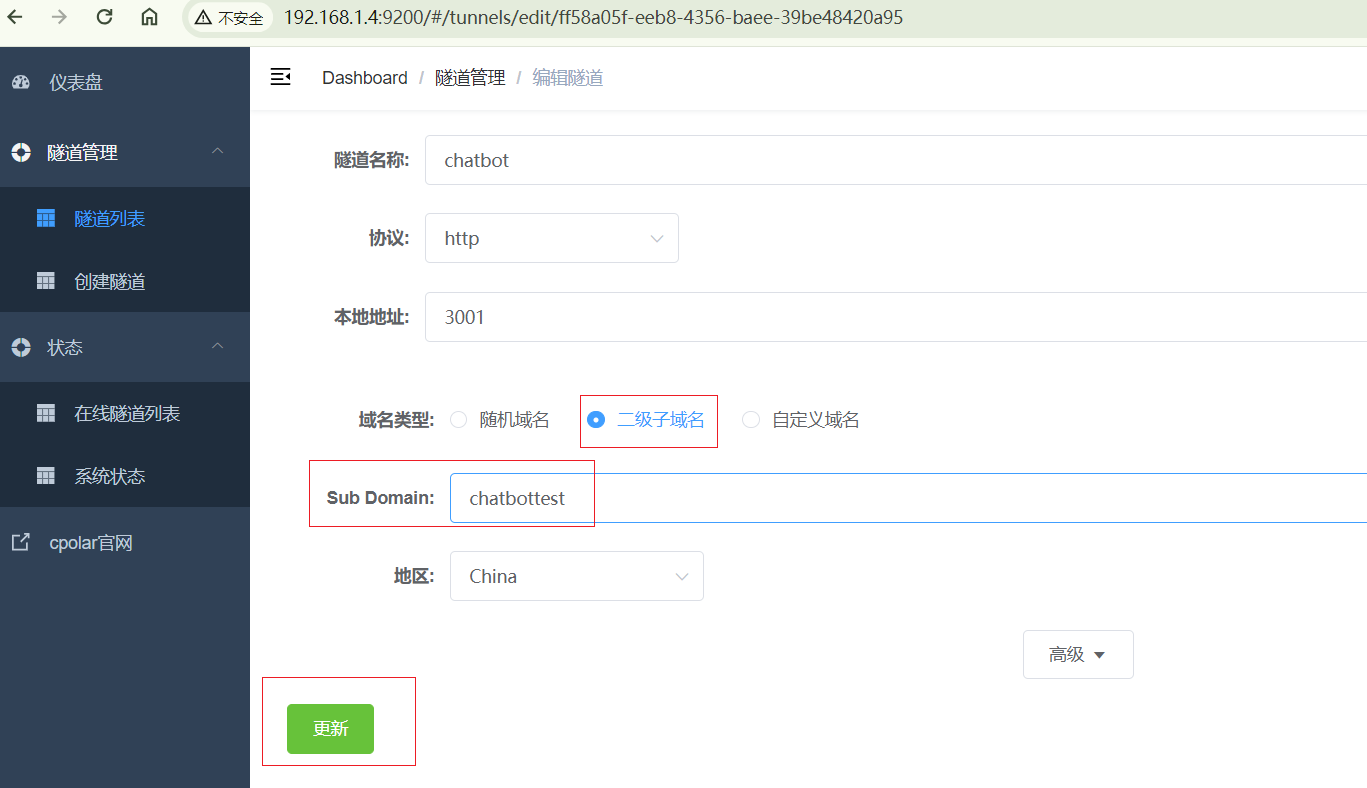

修改隧道信息在隧道中配置成功的二级子域名。

- 域名类型:选择二级子域名。

- Sub Domain:填写保留成功的二级子域名。

点击。更新。(注意,点击一次更新,无需重复提交)。

更新完成后,打开在线隧道列表,可以看到公共网络地址发生了变化,地址名称也变成了固定的二级子域名域名。

最后,当我们使用固定的公网http地址访问时,我们可以看到同样的访问是成功的,这样一个固定和永久的公网地址就设置好了!。

分享让更多人看到