使用Ollama和Open的Win电脑 Web UI构建本地大语言模型运行工具

文章目录。

- 前言。

- 1. 操作Olllama。

- 2. 安装Open WebUI。

- 2.1 Docker安装在Windows系统中。

- 2.2 使用Docker部署Open WebUI。

- 3. 安装内网穿透工具。

- 4. 创建固定公网地址。

前言。

本文主要介绍如何在Windows系统中快速部署Ollama开源大语言模型运行工具,并安装Open WebUI结合cpolar内网穿透软件在公网环境中也可以访问您在本地内网上建造的llama2、大语言模型的运行环境,如千文qwen。

近年来,随着ChatGPT的兴起,大语言模型 LLM(Large Language Model)也成为人工智能AI领域的热门话题,很多大厂也推出了自己的大语言模型,并或多或少地开源了自己的大语言模型,今天就来分享一下最近的火而且对于小白来说,本地LLM工具Ollama的运行比较好。

在本地运行大语言模型有很多优点:

比如。在本地运行大语言模型有很多优点:例如。可以保护隐私。、。不会产生费用。、。可以忽略网络问题。、。

可品尝各种开源模型。

等等。

Ollama支持当前主要的开源模型, 比如llama2、千文qwen、mistral等。c;Windows可以在Windows中、Linux、部署MacOS系统。稳定性和便利性都很好c;让我们分享一下它在Windows系统上的安装和应用。

【视频教程】。

Windows系统电脑使用Ollama#43;OpenWebUI快速构建本地大语言模型体验智能AI聊天。

1. 操作Ollama。本文的安装环境为:Windows10专业版。

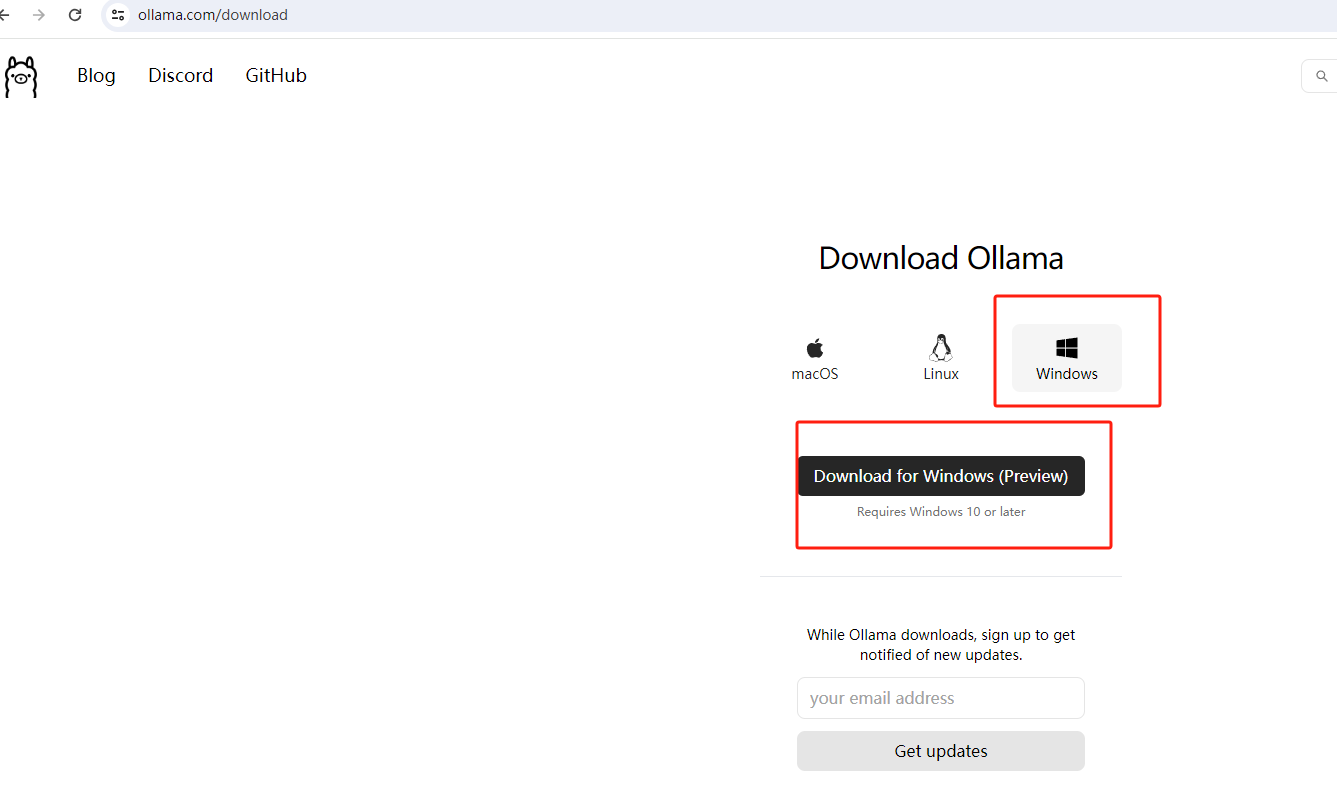

下载:

ollama下载地址:https://ollama.com/download。点击Windows下载页面c;然后单击下载按钮。

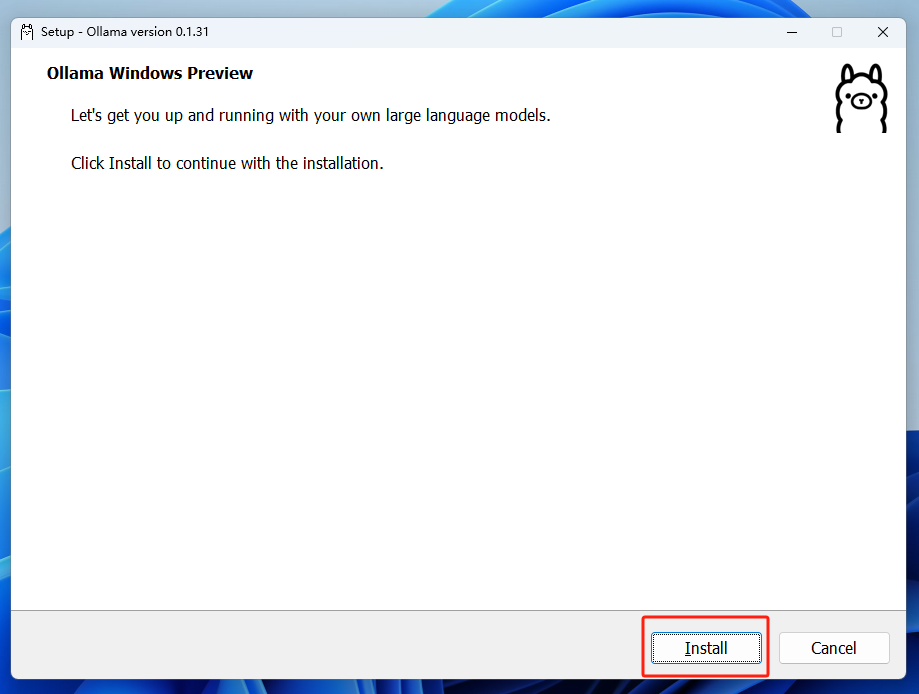

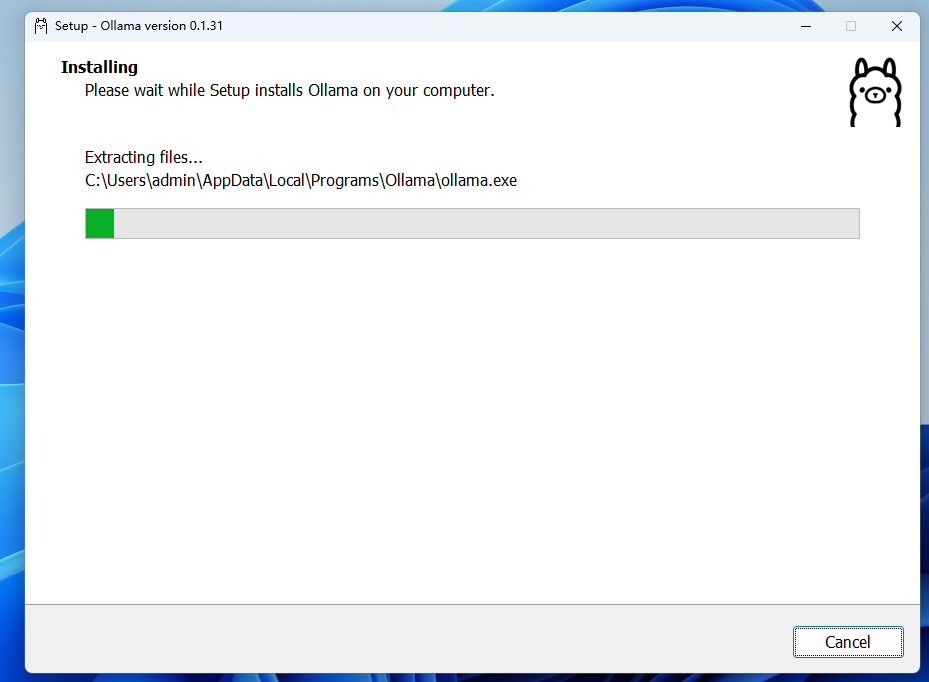

安装:

下载后,双击下载安装程序。

点击Install安装。

安装完成后没有提示我们打开终端,本文以Windows为基础 以Powershell为例c;您还可以使用其他:

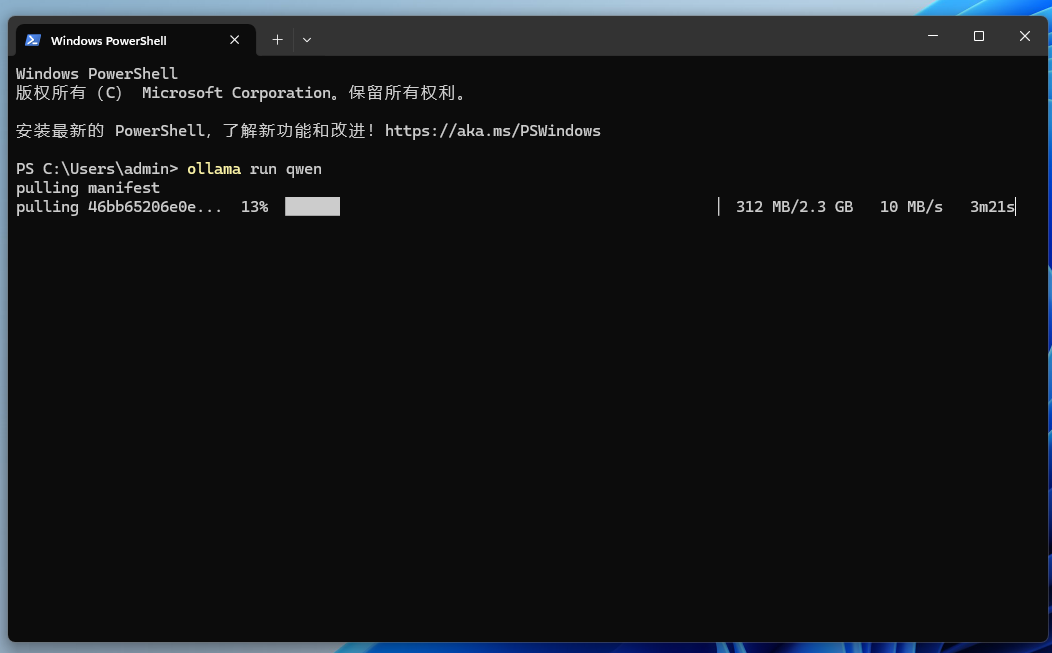

现在Ollama已经安装了,我们需要在终端中输入下面的命令来运行一个大语言模型进行测试c;以中文表现相对较好的千问为例,你也可以使用其他模型。ollama run qwen。ollama run qwen。

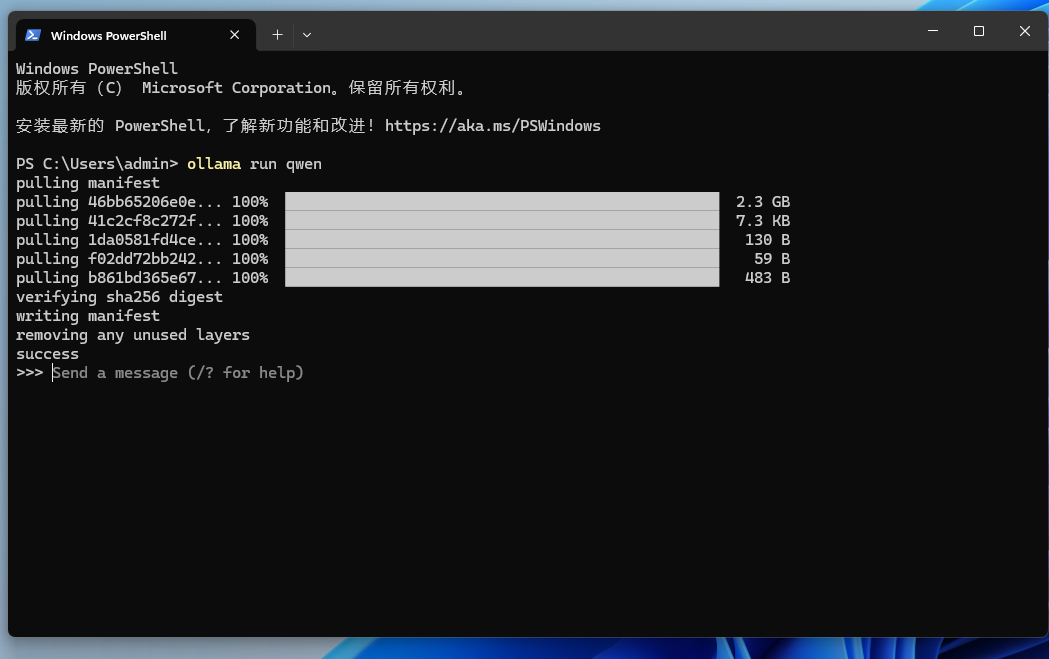

你可以看到�该系统正在下载qwen模型(并保存C盘,C:\Users<username>.ollama\models 如果你想改变默认路径设置可以通过。

OLLAMA_MODELS。

修改,然后重启终端重启ollama服务。)

setx OLLAMA_MODELS "D:\ollama_model"

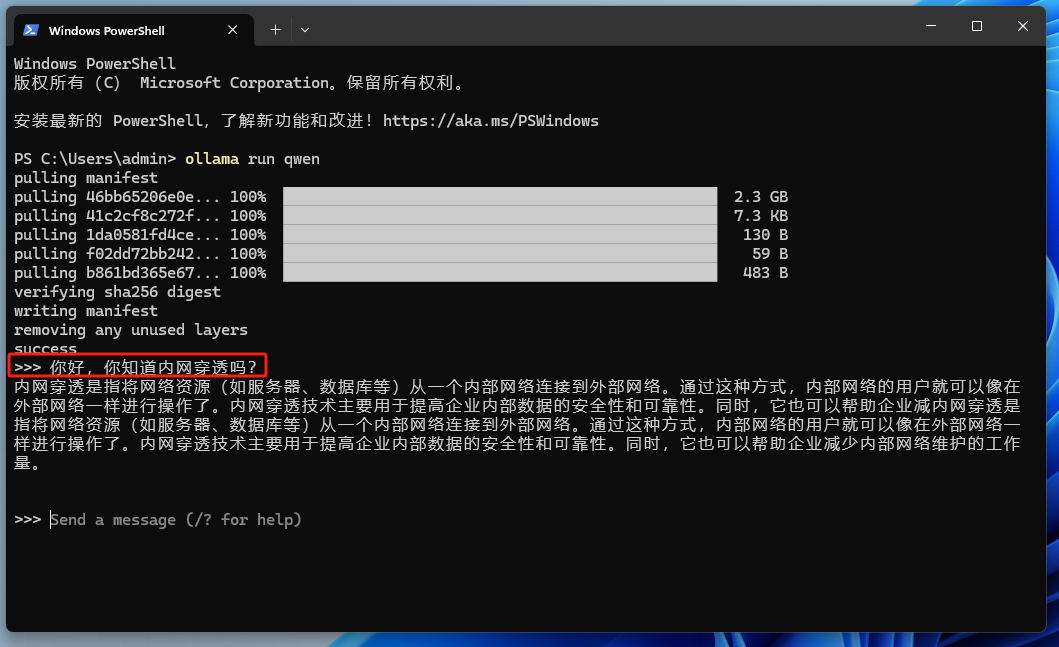

模型下载后,我们可以使用在终端中输入问题a;

到目前为止,在Windows本地部署ollama并运行qwen大语言模型已经完成。一键完成对新手体验大语言模型真的很友好。

2. 安装Open WebUI。

但是,我们现在只能在终端上使用,操作界面可能不像ChatGPT那么漂亮�如果可以使用web页面进行交互,更好的使用体验之前的聊天记录也可以保留c;翻遍我们的查询。

针对这种情况,我们可以在Windows上部署Openn 为了实现像chatgpt这样的交互界面,WebUI项目。

本教程以Open为基础 以WebUI为例,它以前的名字叫 Formerly Ollama WebUI。可以理解为Webui,一开始是专门适合Ollama的c;对于习惯了chatgpt的小伙伴来说,它的界面也更加相似。当然,您也可以选择其他WebUI,之后有机会也可以和大家分享。

如何在Windows系统中安装Open? WebUI:

2.1 Docker安装在Windows系统中。

首先,如果您以前没有安装过Docker,如果您以前没有安装过c;安装以下三个步骤需要执行#xff1a;

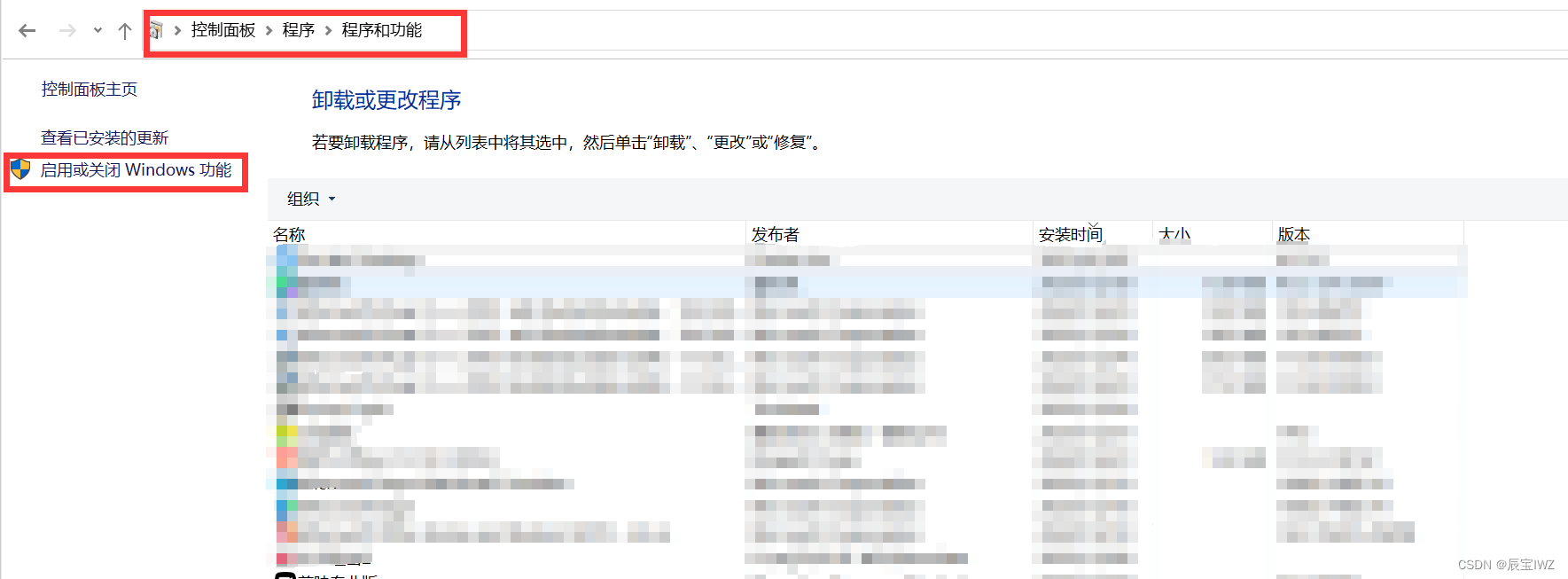

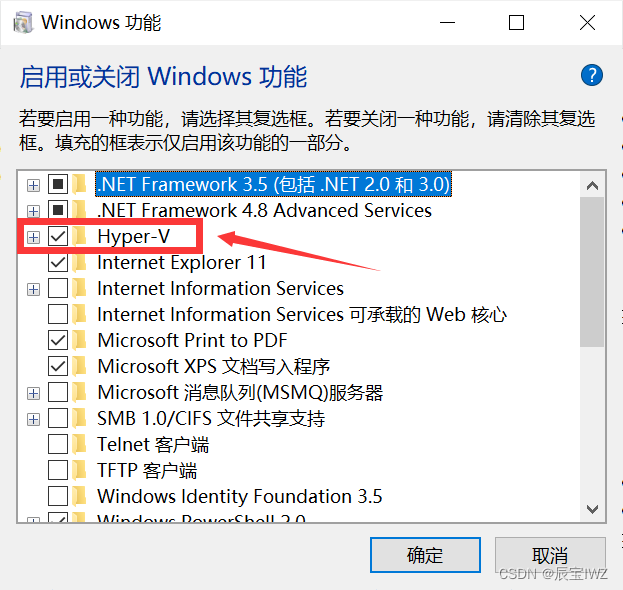

第一步:启动Hyper-v。

打开控制面板༌选择启用程序和功能页面或Windows功能。

勾选Hyper-V、点击确认虚拟机平台、Linux子系统。

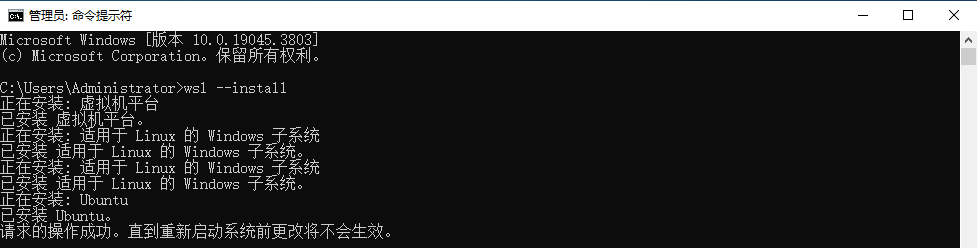

然后,重启计算机。第二步:安装WSL。

打开 powershell,启动命令窗口作为管理员c;输入。

wsl --update。

安装。

wsl --install。

然后重新启动计算机。

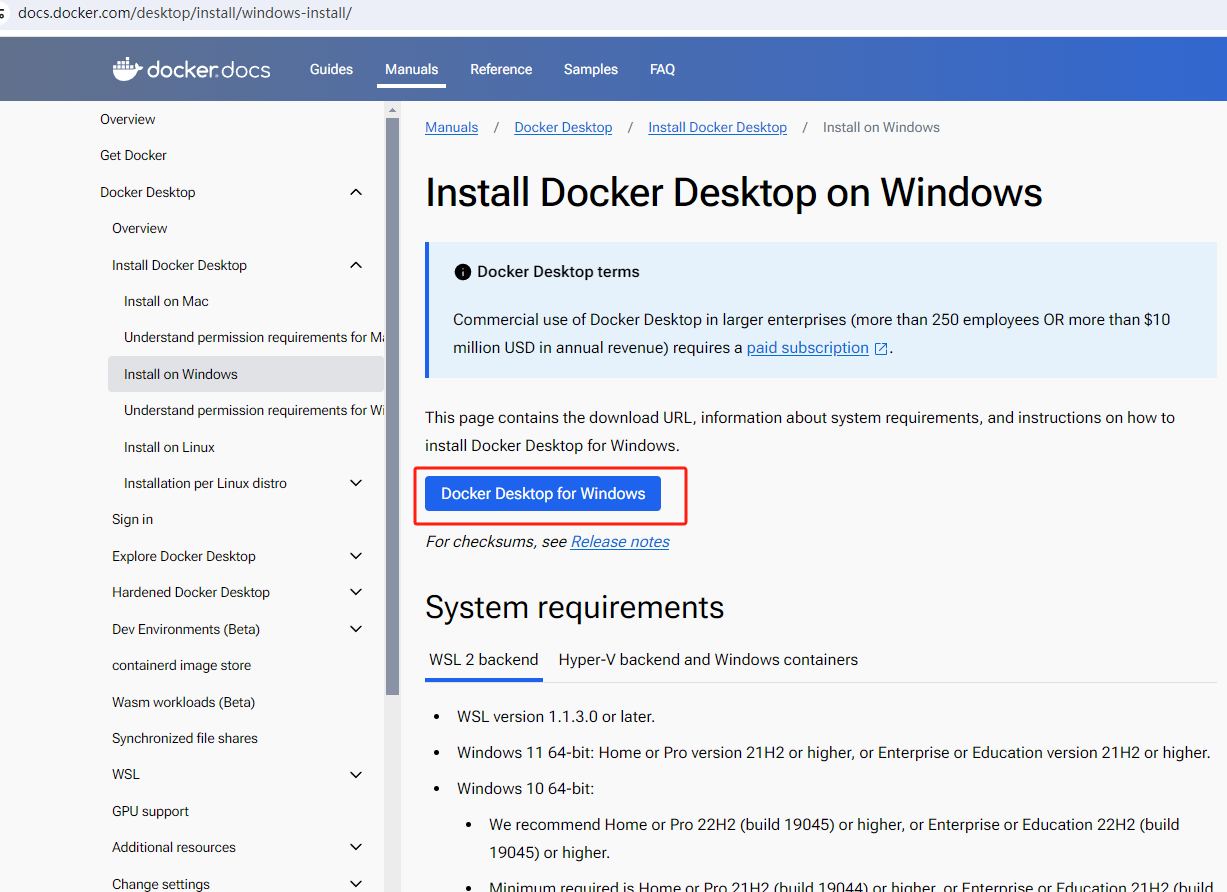

第三步:访问Docker官网下载。

点击下载链接:https://docs.docker.com/desktop/install/windows-install/。

选择Windows最新版本:

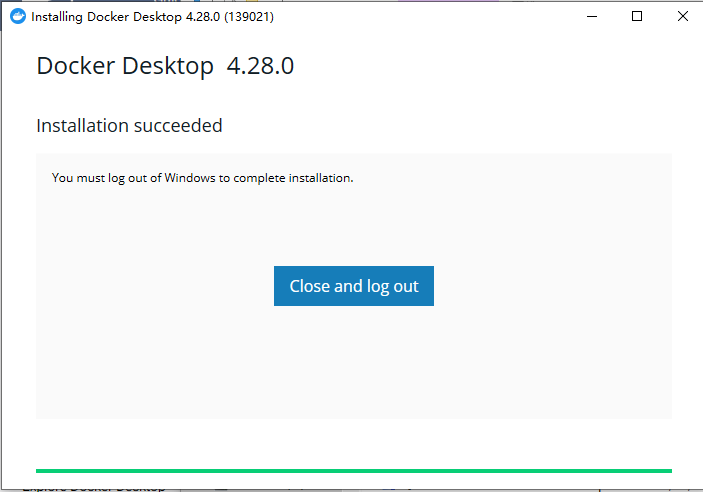

下载后,安装双击安装程序,如果是第一次安装,安装后,提示重启计算机,重启后,单击桌面上的Docker desktop图标#xff1a;选择不先注册直接登录即可。

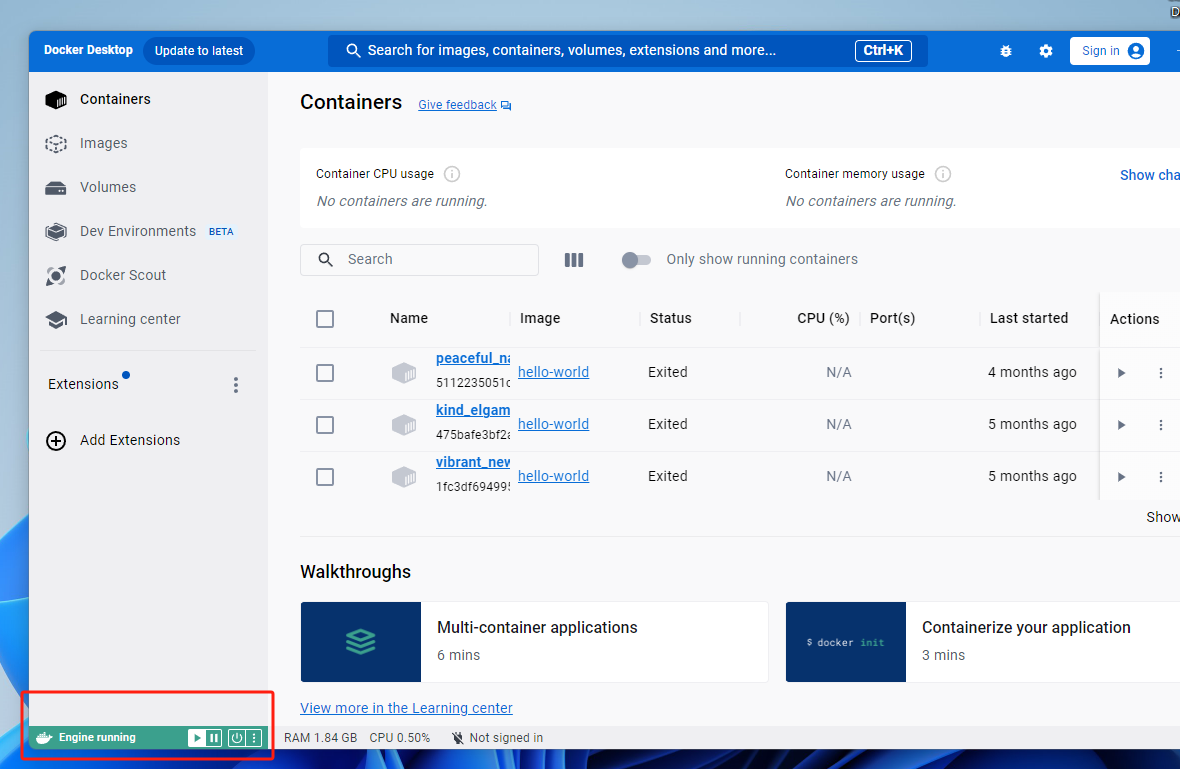

打开Docker desktop后,左下角的绿色running代表我们的成功:2.2 使用Docker部署Open WebUI。

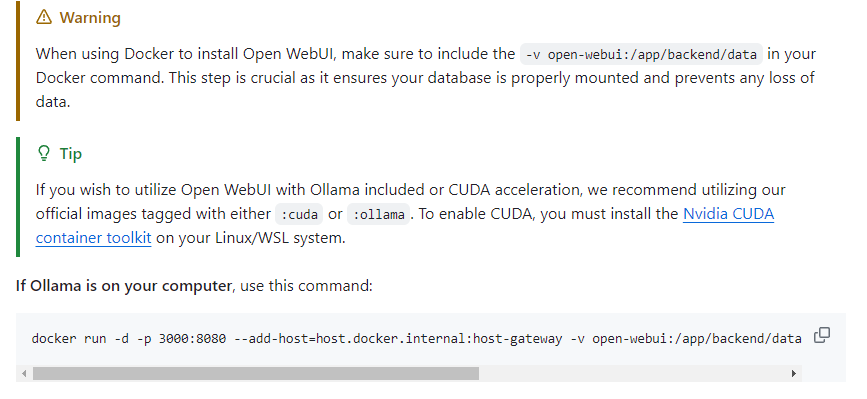

在Open WebUIgithub页面 https://github.com/open-webui/open-webui 你可以看到�假设Ollama和Open WebUI在同一主机,使用下面显示的行命令可以在本地快速部署:

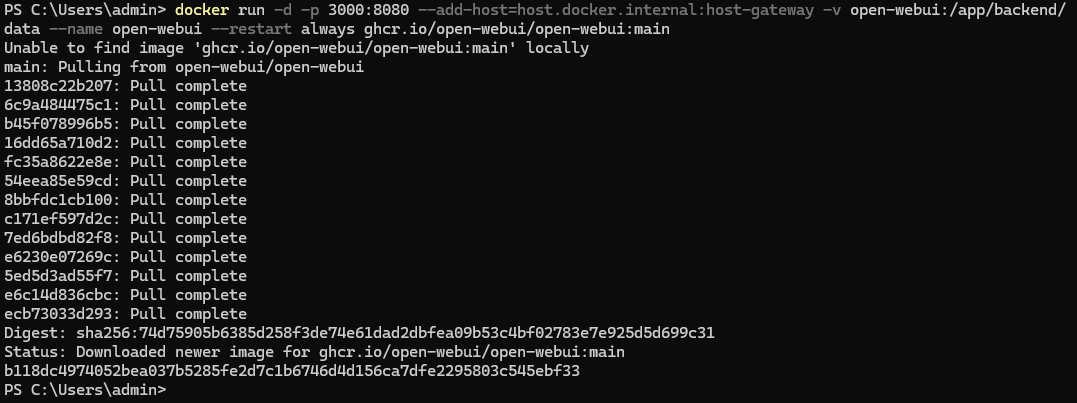

docker run -d -p 3000:8080 --add-host=host.docker.internal:host-gateway -v open-webui:/app/backend/data --name open-webui --restart always ghcr.io/open-webui/open-webui:main。

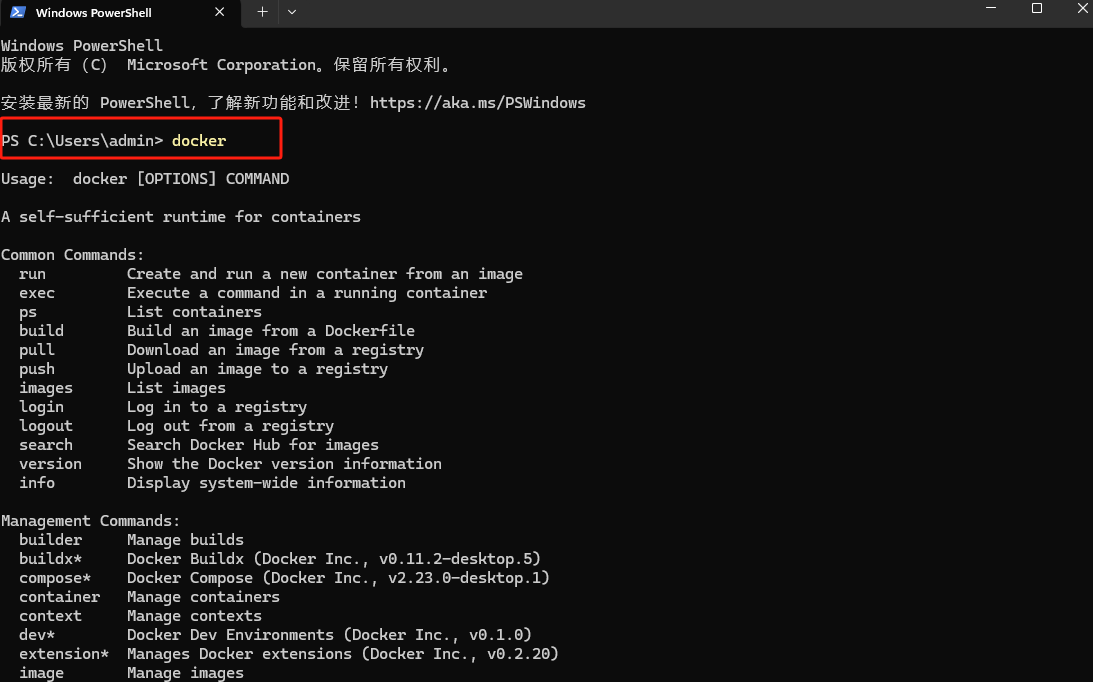

现在我们打开终端例如,powershell,然后输入docker回车。

现在我们打开终端例如,powershell,然后输入docker回车。

可以看到这个命令成功运行,说明docker安装成功。

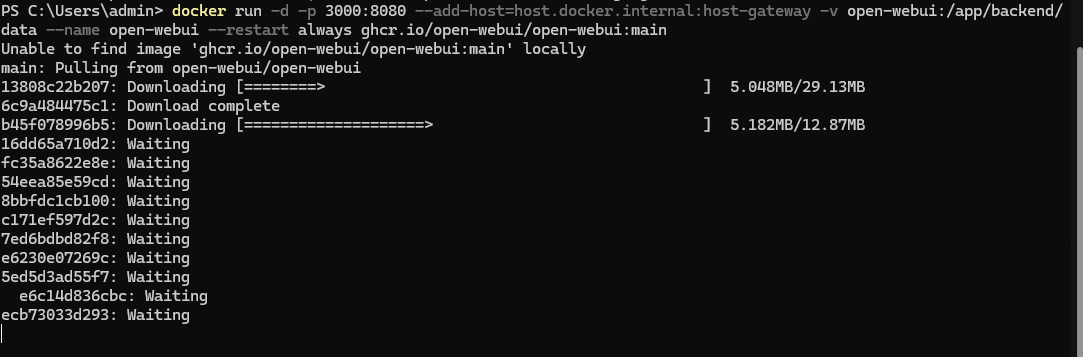

然后在docker中部署Open 复制WebUI命令后,粘贴到终端,回车。

然后等待安装完成:如下图所示。

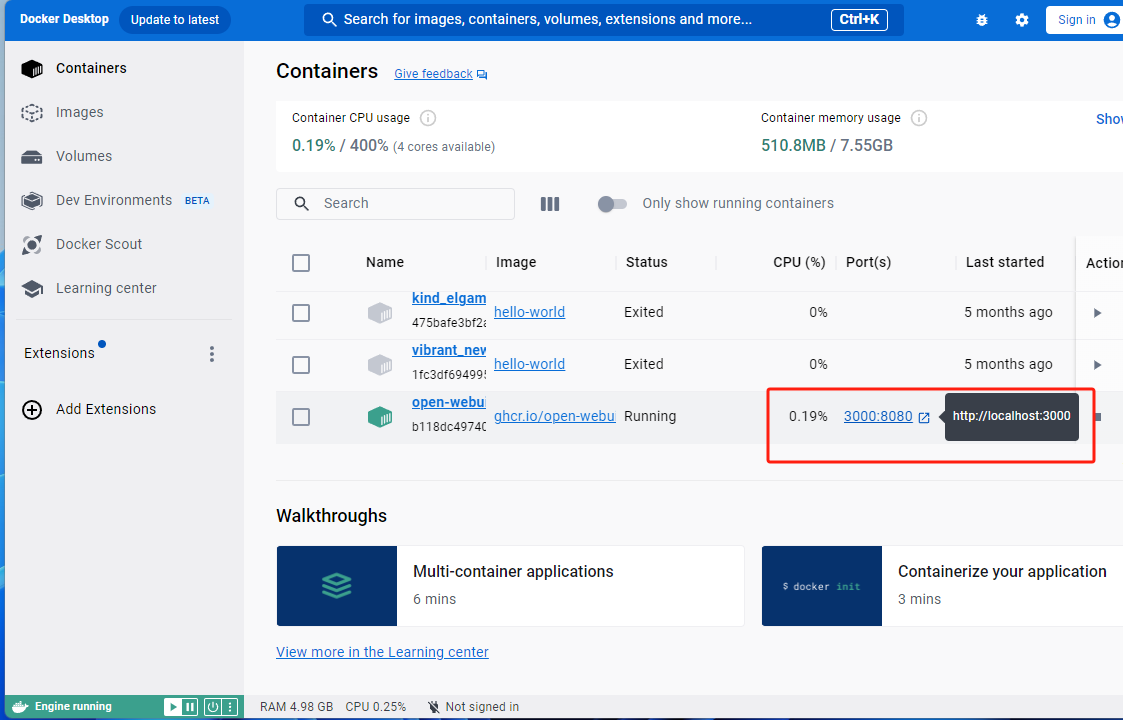

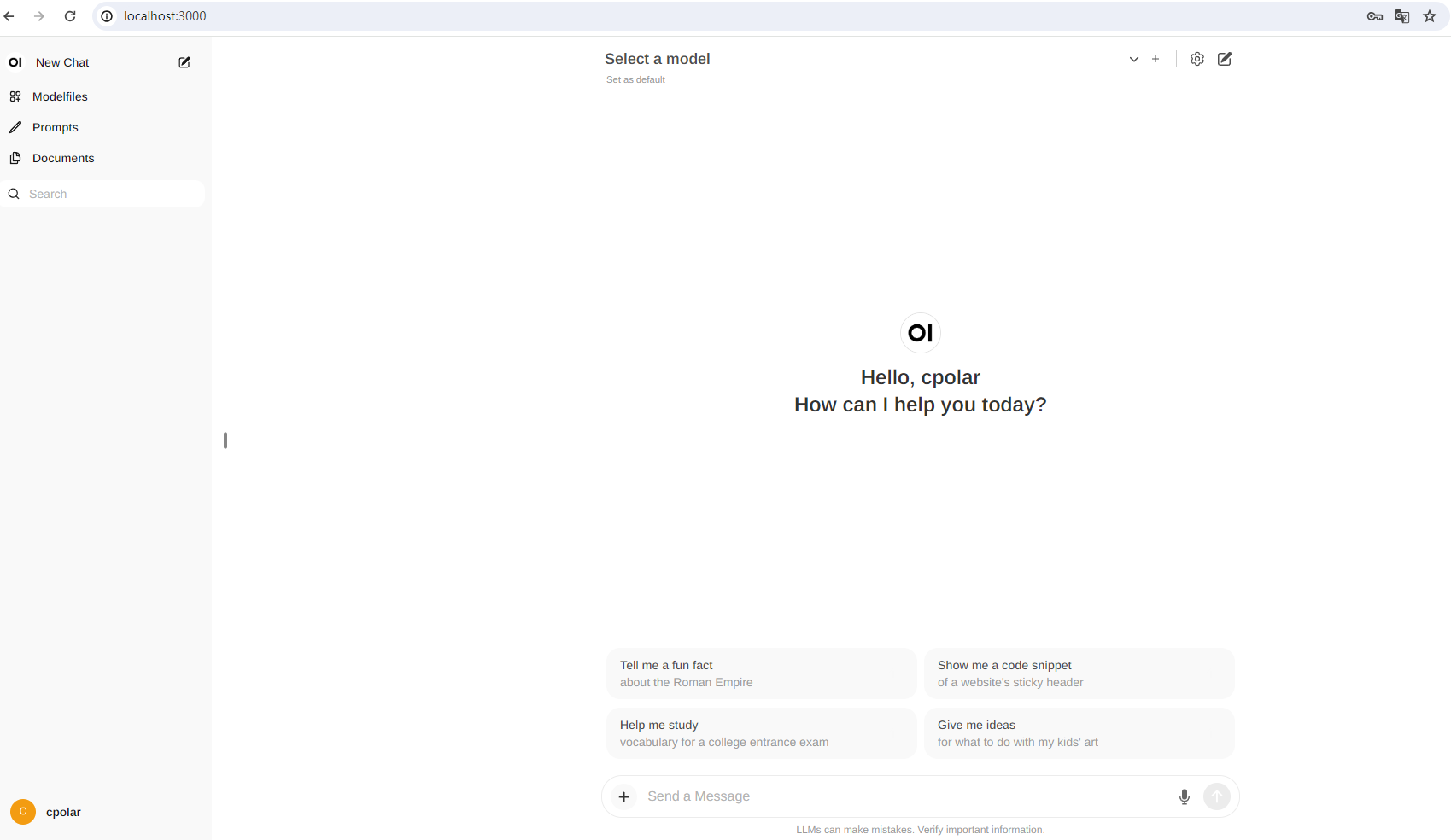

安装完成后,在Docker Open可以在Desktop中看到 WebUI的web界面地址为:https://localhost:3000。

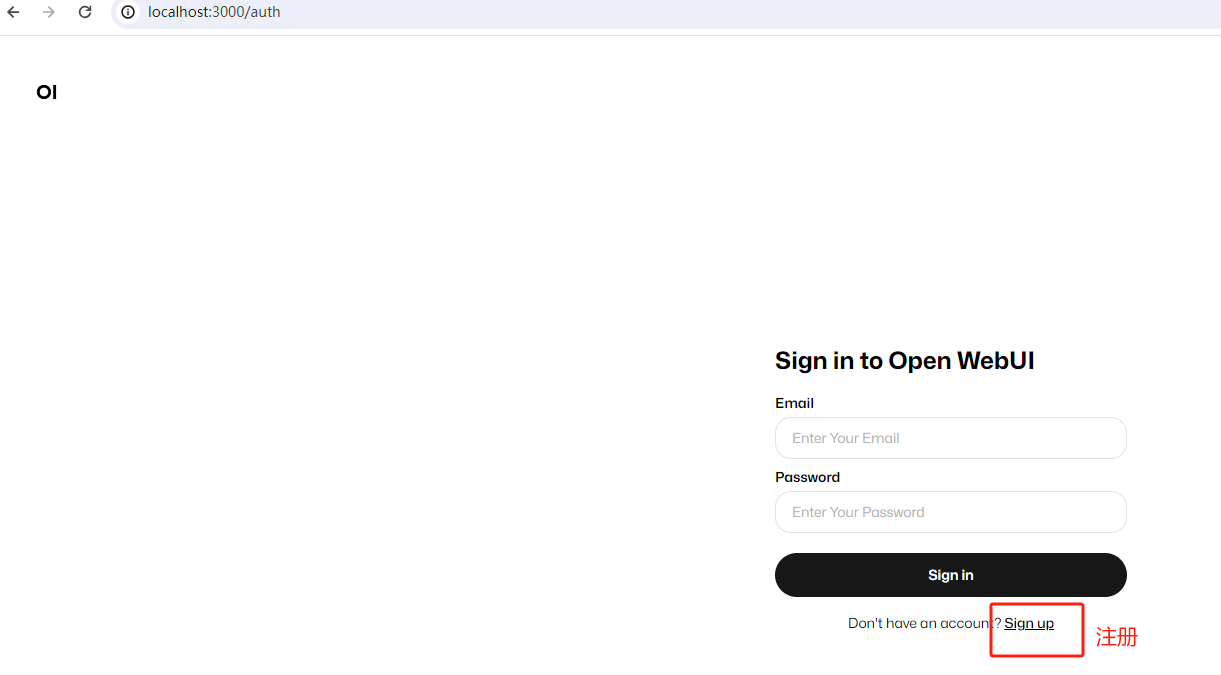

点击后,打开浏览器登录界面:

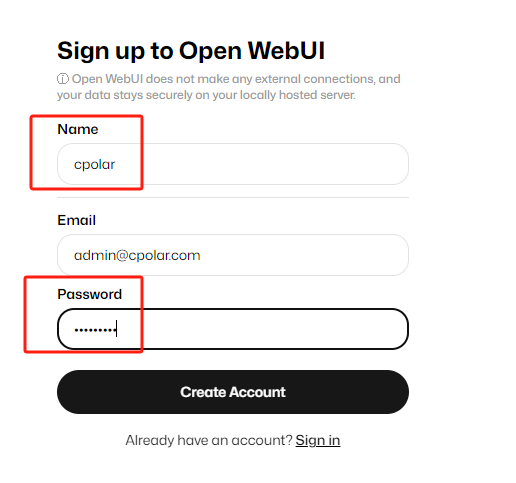

点击sign up注册帐号,邮箱,记住密码,下次登录时,需要使用电子邮件和密码登录#xff1a;

然后点击createeater account可以创建帐户:然后在浏览器中使用类似chatgpt界面的Open WebUI!

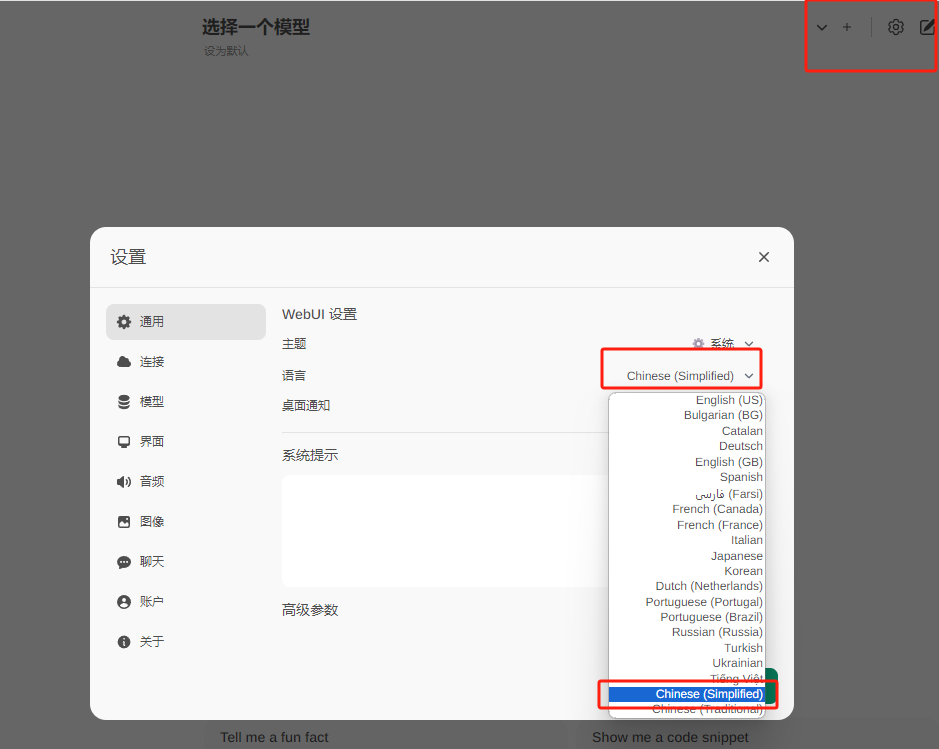

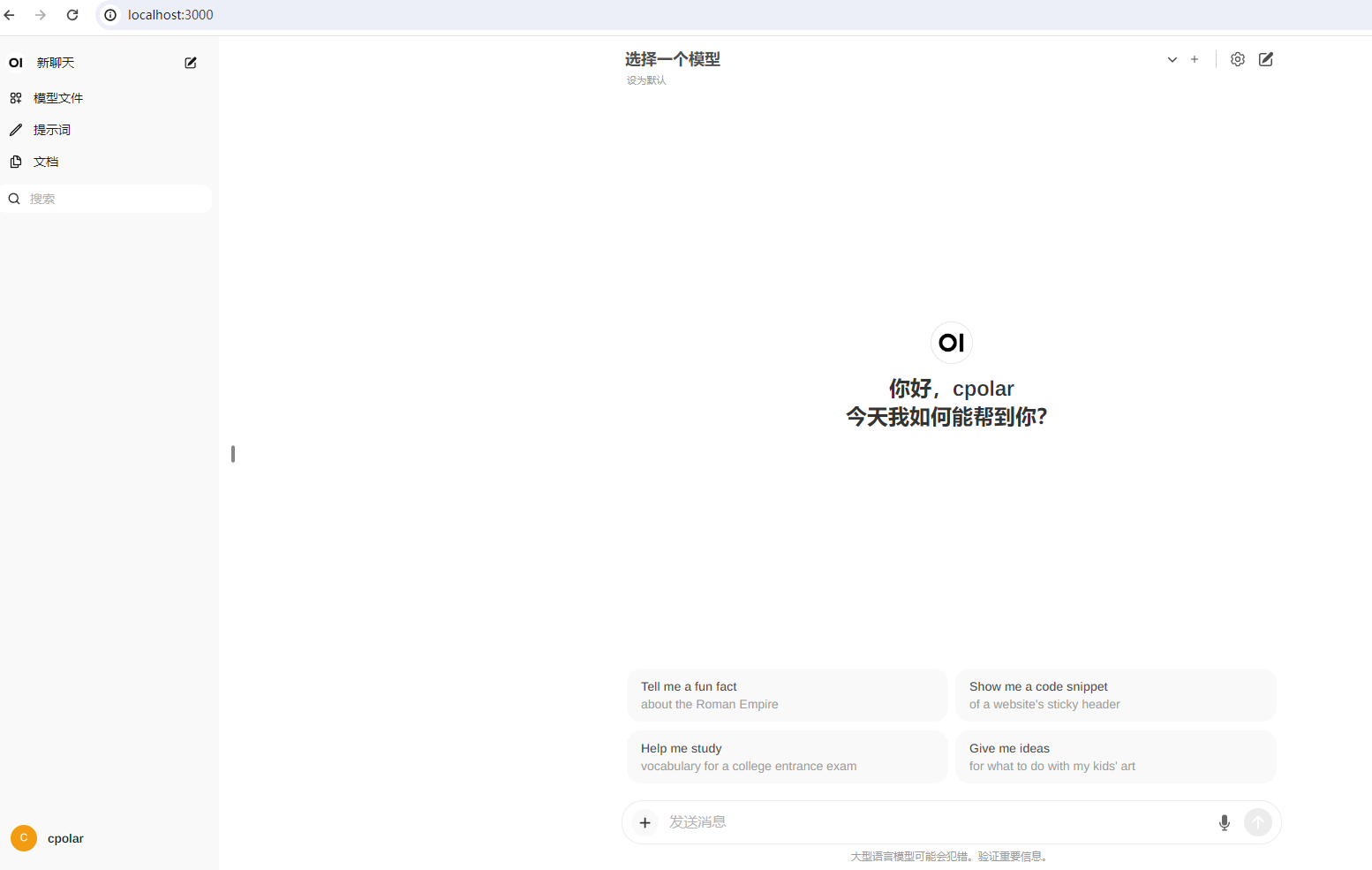

点击右上角的设置,当前界面的语言可以修改为简体中文:然后点击保存即可。

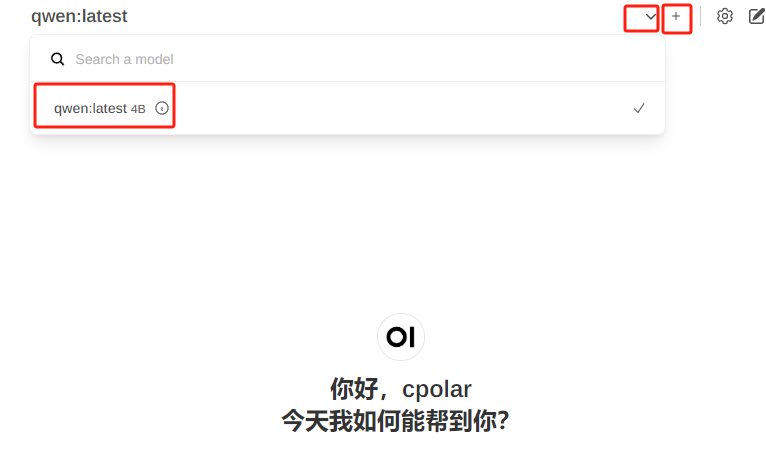

点击上面选择模型旁边的加号+可以增加大模型,点击下拉按钮选择已安装的模型,接下来,你可以愉快地与ai聊天!

3. 安装内网穿透工具。到目前为止,本地Windows系统使用Docker部署Open,我们已经成功完成 WebUI与Ollama大模型工具交互!但是,如果你想出去,c;Olllama也可以随时随地使用 Open WebUI,需要使用cpolar内网穿透工具实现公网访问!接下来,我们来介绍一下如何安装cpolar内网穿透,实现公网访问!以下是安装cpolar步骤:

cpolar官网地址: https://www.cpolar.com。

点击进入cpolar官网,点击。

点击进入cpolar官网,点击。

免费使用。

注册一个帐户并下载最新版本的cpolar。

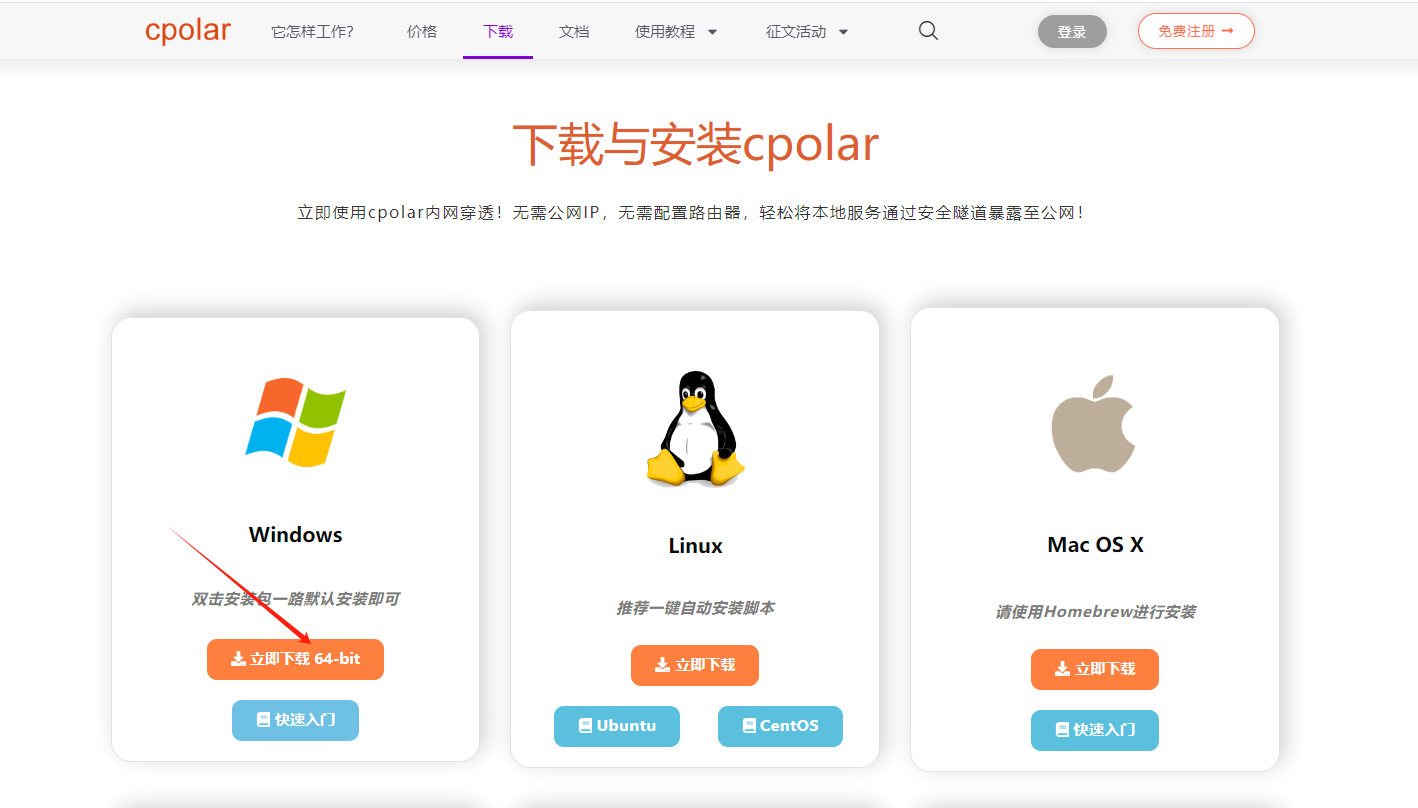

- 登录成功后点击下载cpolar到本地安装(一路默认安装)本教程选择下载Windows版本。

- 成功安装cpolar后访问浏览器上的http://localhost:9200,使用cpolar帐户登录,登录后即可看到cpolarar web 配置界面,在web结束 可以配置管理界面。

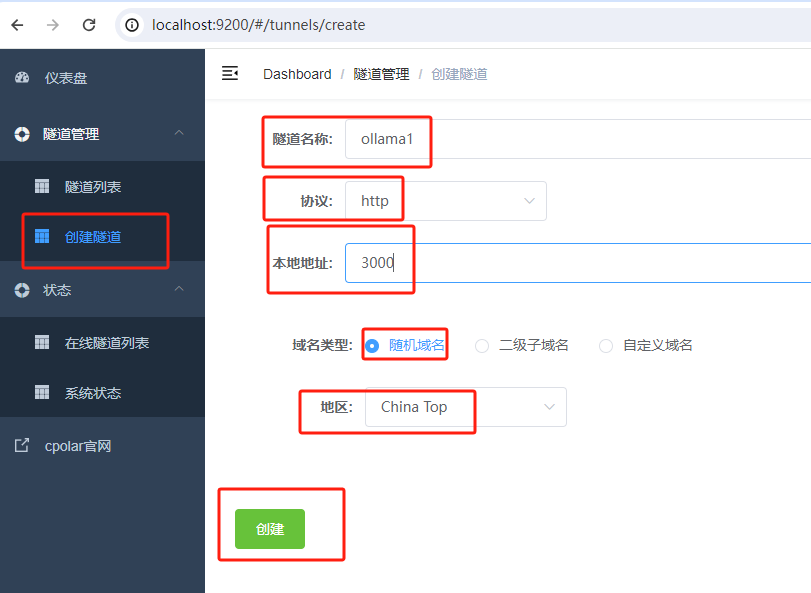

- 下一步是配置 Open WebUI 公网地址,

- 登录后,点击左侧仪表板的隧道管理-创建隧道,

- 创建一个 ollama1 公网http地址隧道:

隧道名称:olllama1(可自定义命名注意不要与现有隧道名称重复)

协议:选http。

地址:3000 (本地访问地址)。

地址:3000 (本地访问地址)。

域名类型:免费选择随机域名。

区域:选择China Top。

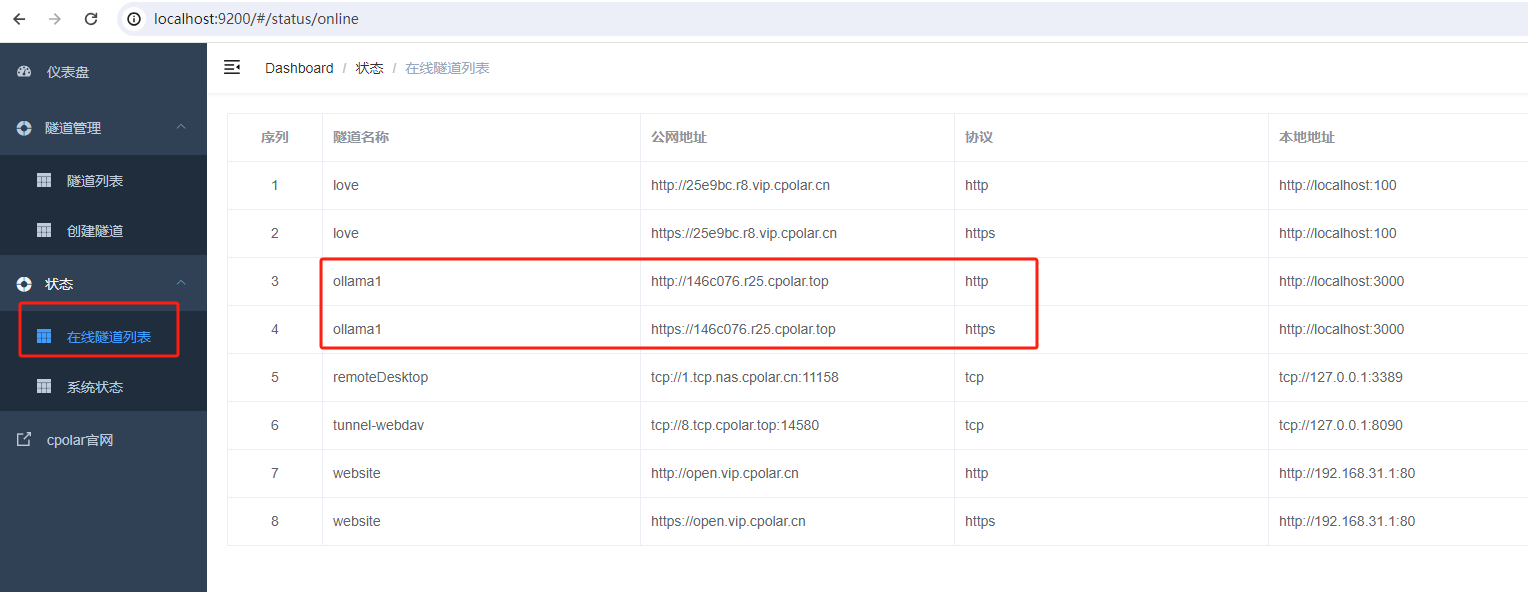

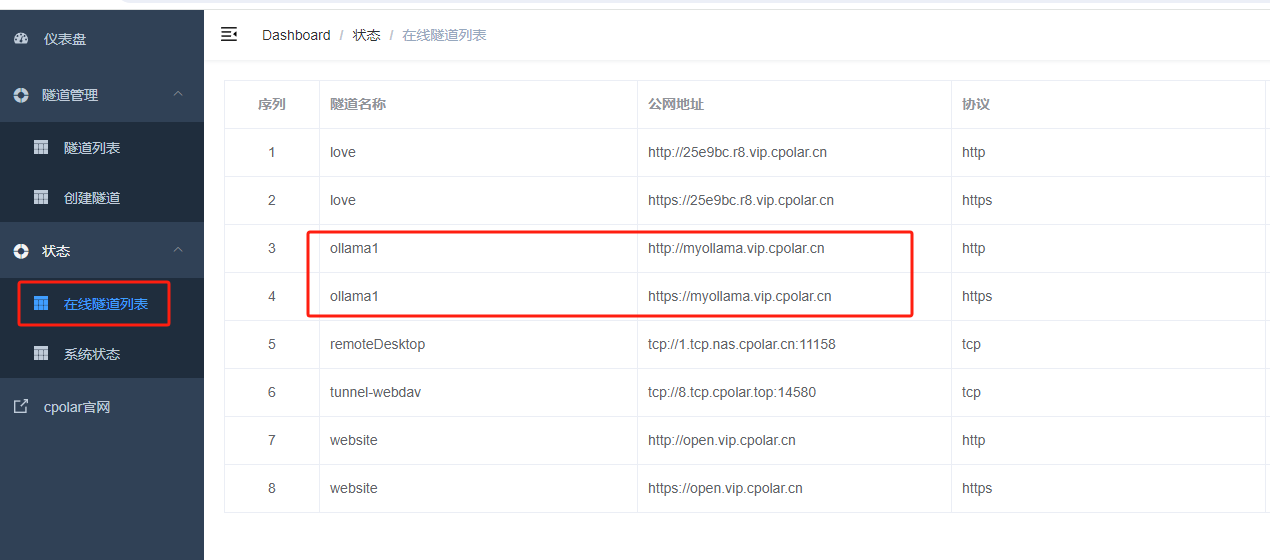

隧道建成后,点击左侧状态-在线隧道列表,查看生成的公共网络访问地址,有两种访问方式,一种是http https:

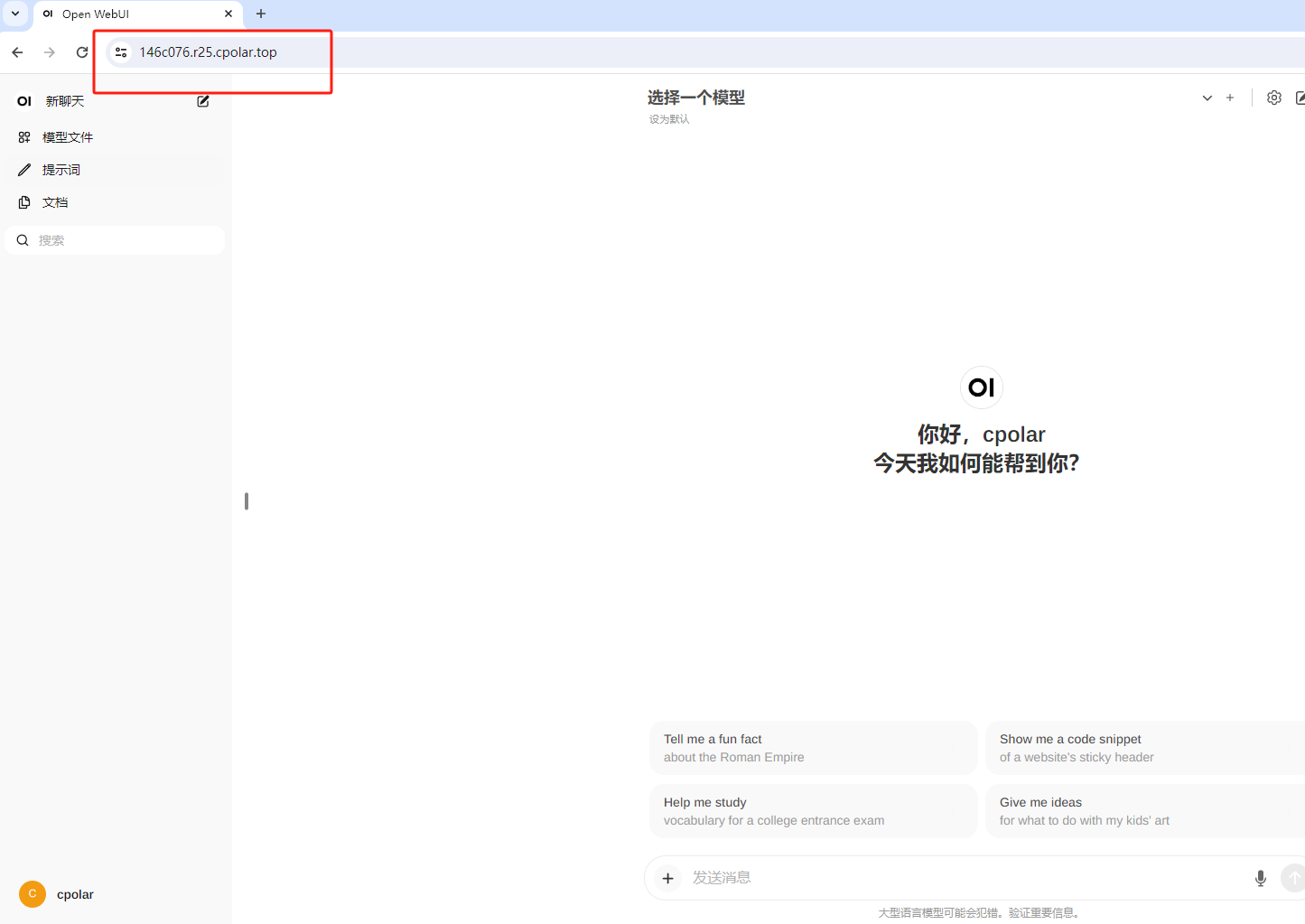

使用上述任何公共网站地址,登录并访问手机或任何设备的浏览器,即可成功查看 Open WebUI 界面,这样一个可以远程访问的公共网站地址已经创建。使用cpolar的公共网络域名,您可以访问公共网络,而无需购买云服务器 Open WebUI !

小结。

如果我们需要长期远程访问Open WebUI,因为只是随机地址创建了c;24小时内会发生变化。

如果我们需要长期远程访问Open, WebUI,因为只是随机地址创建了c;它将在24小时内发生变化。此外,其网站由随机字符生成,不易记住。如果你想把域名变成固定的二级子域名,我不想每次都重建隧道来访问Open WebUI,我们可以选择创建一个固定的公共网站地址来解决这个问题。

- 4. 创建固定公网地址。

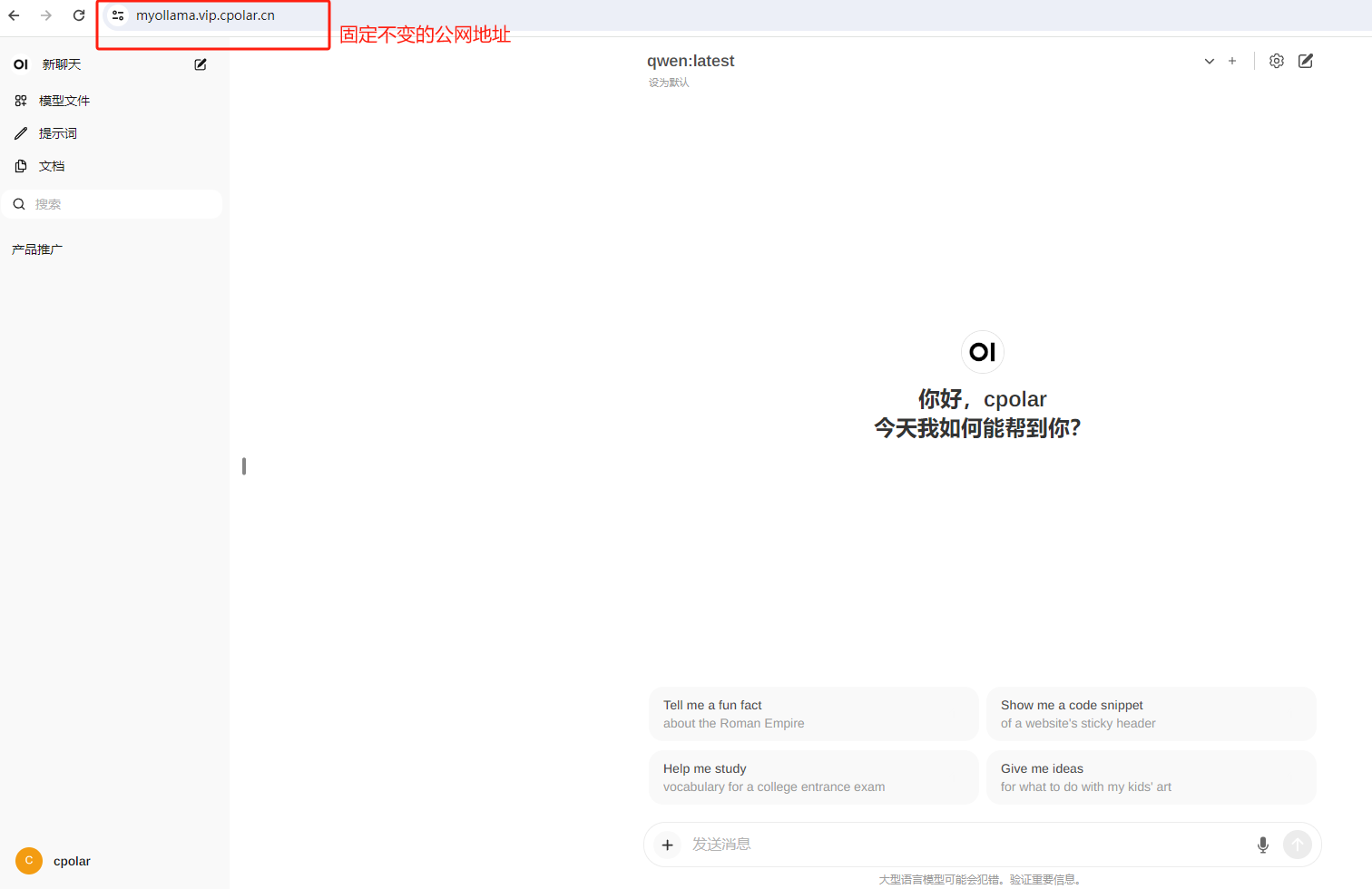

- 接下来,我们将配置固定的HTTP端口地址,地址不会改变与他人分享方便,长期查看您部署的项目,服务器地址不需要每天重复修改。

配置固定http端口地址需要将cpolar升级到专业套餐或以上。登录cpolar官网,点击左侧预留,选择保留二级子域名设置二级子域名,点击保留,保留成功后保留的二次子域名。保留成功后,复制保留成功的二级子域名的名称:myollama,你也可以设置你喜欢的名字。

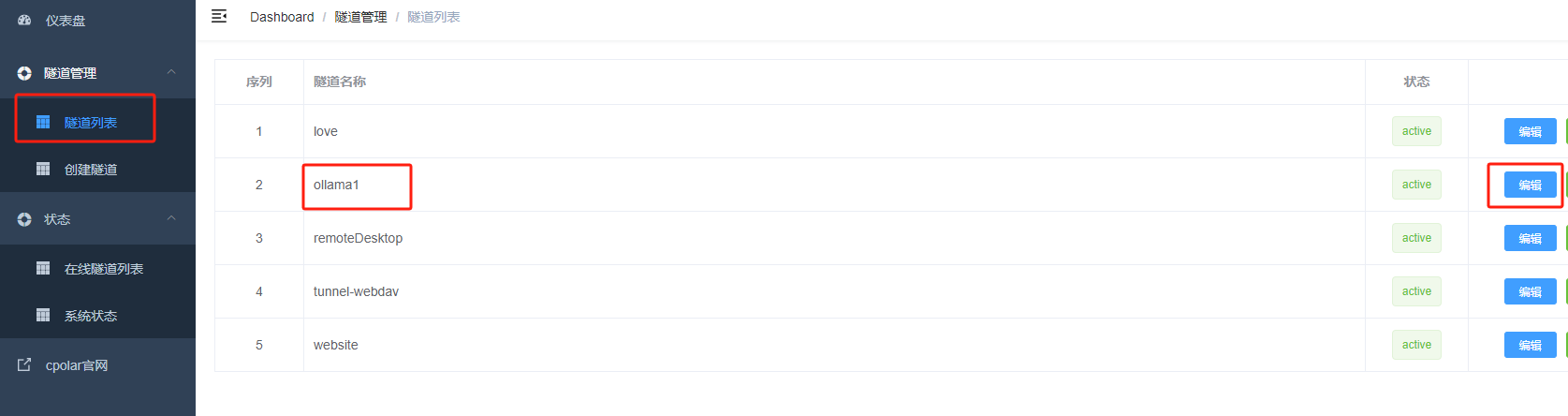

回到Cpolarar登录 web UI管理界面,点击左侧仪表板的隧道管理-隧道列表,找到要配置的隧道:olllama1,单击右侧的编辑:

隧道信息修改#xff0c;在隧道中配置成功的二级子域名。

域名类型:选择二级子域名。