AI高级篇:FLUX

发布时间:2025-06-24 17:38:03 作者:北方职教升学中心 阅读量:334

(controlnet和IPA部分下载和使用FLUX;

大多数有一定AI绘画基础的小伙伴,在AI创作过程中应该离不开一件事,那就是ControlNet。

Controlnet曾被视为AI绘图模型可控性的终极解决方案,人工智能绘画在早期最受批评的地方是它的随机性,就像现在随处可以刷的AI视频一样c;你永远不知道他下一步要做什么。

最早的官方Controlnet模型是在SD1.5模型上炼制的,因此,后续推出的XL甚至现在的FLUX模型都无法兼容。然而,已经有两个开发团队训练了与FLUX相匹配的Controlnet模型。

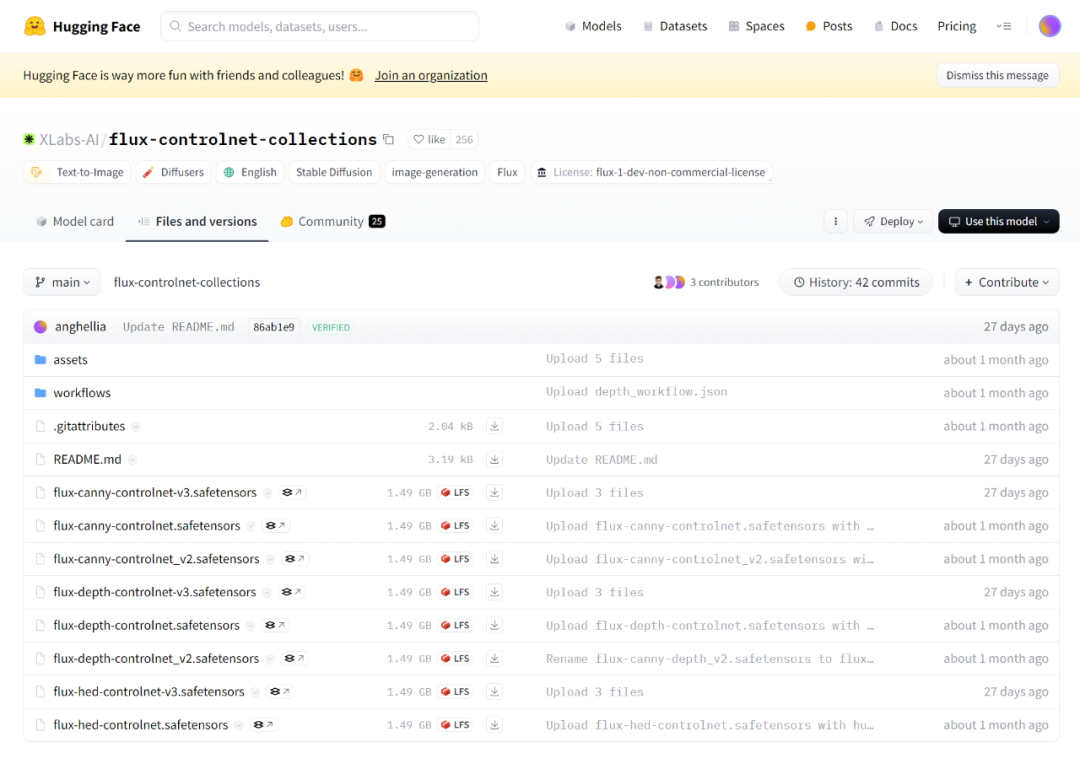

一个叫XLabsAI的团队训练了三个单体的Controlnet。

https://huggingface.co/XLabs-AI/flux-controlnet-collections/tree/main。

https://huggingface.co/XLabs-AI/flux-controlnet-collections/tree/main。

这三个Controlnet分别是canny、HED(SoftEdge)和Depth在这里,我推荐下载最新的v3版。

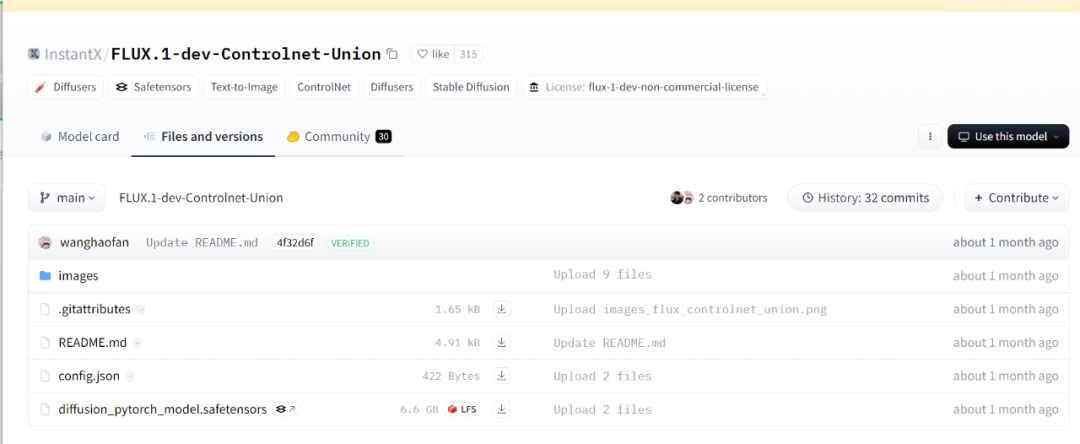

另一个叫Instantx的团队是之前开发InstantID的,他们训练Canny和Controlnet集合模型,这个Union包含Canyy、Depth、Tile、Openpose等控制模式。

https://huggingface.co/InstantX/FLUX.1-dev-Controlnet-Union/tree/main。

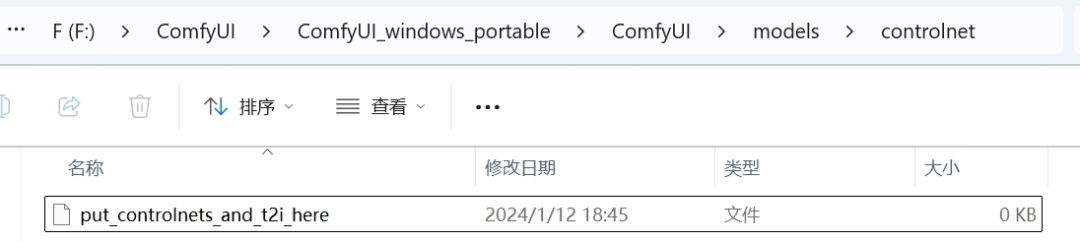

如果ComfyUI在下载后放在这个位置。

ComfyUI(#xff09根目录;/models/controlnet。

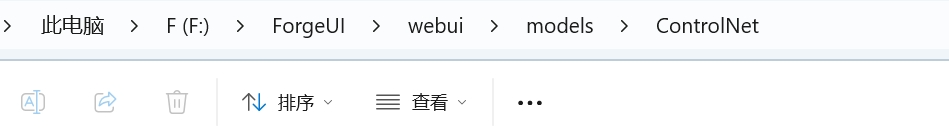

如果是ForgeUI,放在这个位置:

WebUI(#xff09根目录;/models/controlnet。

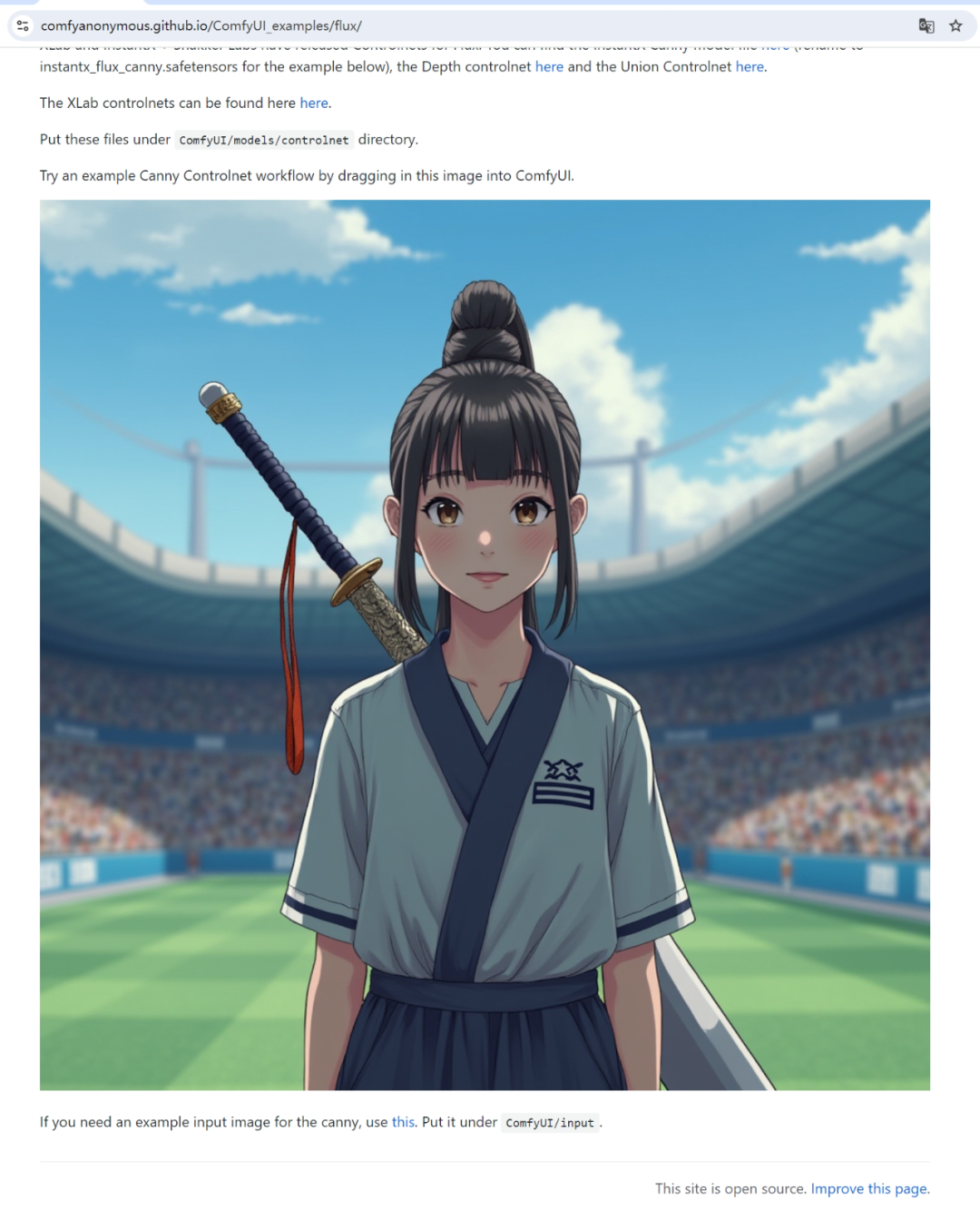

ComfyUI官方提供的工作流可在下载后使用c;将图片直接拖入界面。

https://comfyanonymous.github.io/ComfyUI_examples/flux/。

官方提供的工作流可以与上次笔记中提到的FP8优化模型相匹配(SD3) 在ControlNet加载器中使用。

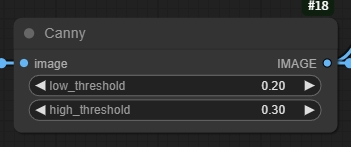

但最初的工作流只提供Canny预处理器。

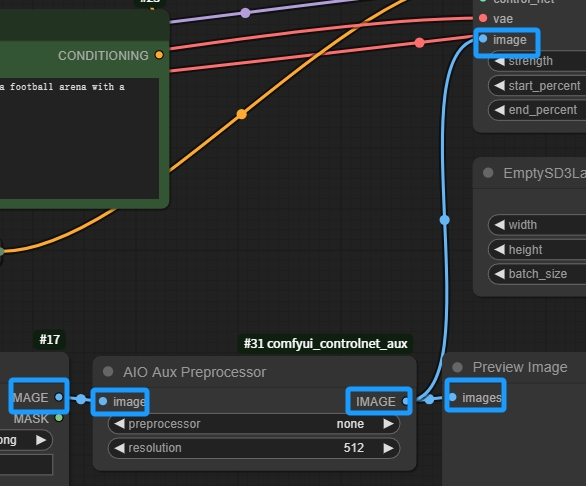

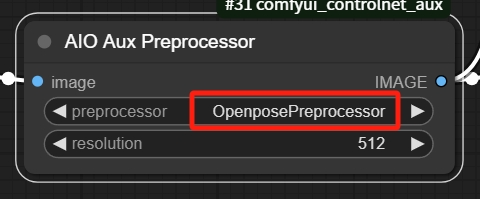

但是,它可以改为另一个节点,双击界面搜索AIO Preprocessor(Aux集成预处理器)然后将原始链接到Cany节点的线连接到集合预处理器上。

使用Controlnet的操作流程:

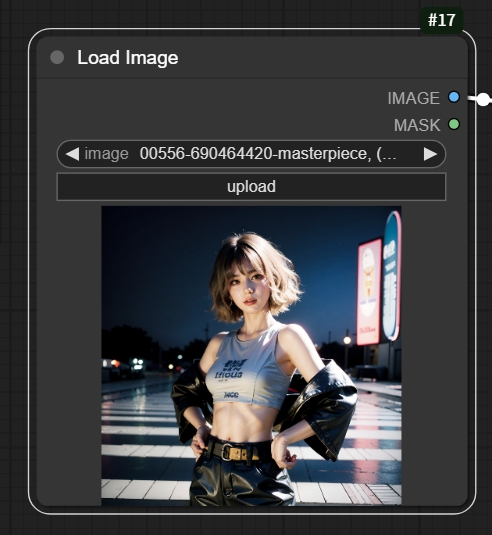

在Load Image(加载图像)上传一个节点。姿势。的参考图。

以后的AIO Aux Preprocesor中的预处理类型改为Openpose。

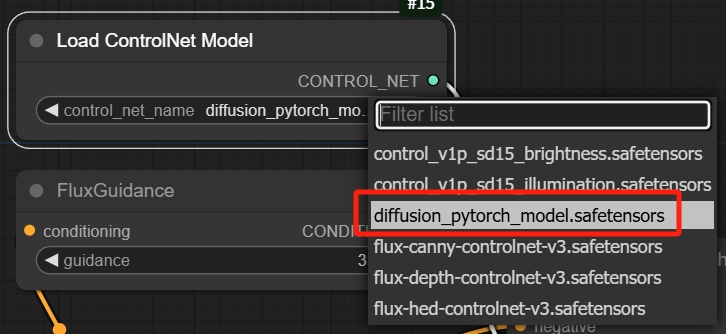

Controlnet加载器节点选择需要调用的Controlnet模型,包含姿势控制的Union模型被选中。

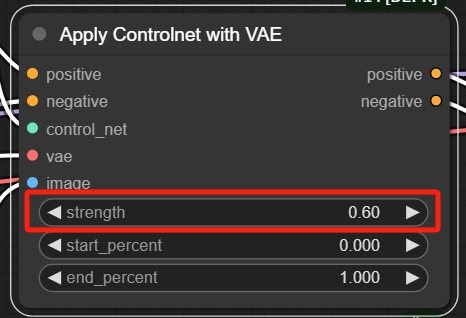

通过Apply控制姿势的强度 Controlnet with VAE控制节点中的权重值。如果使用XLAB的三个Controlnet,建议在0.6-0.8之间,若为Union模型,则推荐为0.5-0.6。

输入提示词(,就像CLIP文本编辑器中的正常生图;根据自己上传的图片和想要的姿势写)

然后点击Queue Prompt可以等待生成图片!

在这个过程中,小伙伴可能会遇到一些问题,但是目前还没有找到解决一些生成问题的办法。如果遇到可以私信给我,我可以帮忙看看怎么解决。

除Controlnet外,IP-Adapter这个东西可以用一张图片来实现风格参考和图像固定它甚至可以部分取代LoRA的功能。

如果要在ComfyUI中使用,需要下载两个模型,第一个是FLUX UP-Adapter模型。

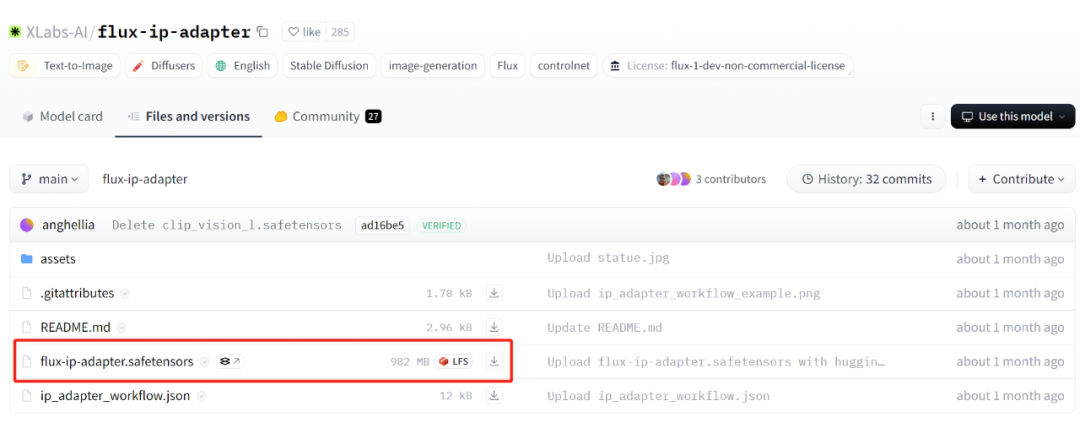

https://huggingface.co/XLabs-AI/flux-ip-adapter/tree/main。

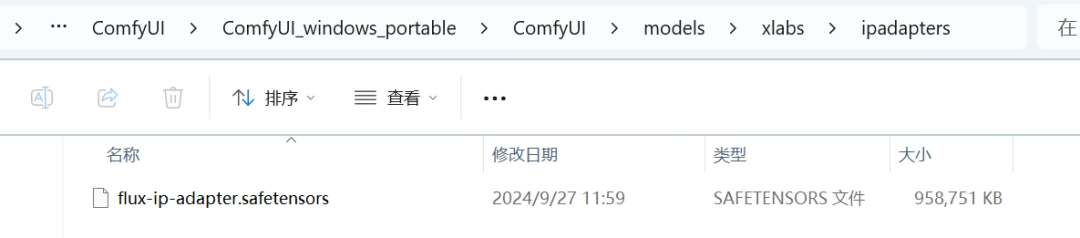

下载后放置。ComfyUI(#xff09根目录;models/xlabs/ipadapters。

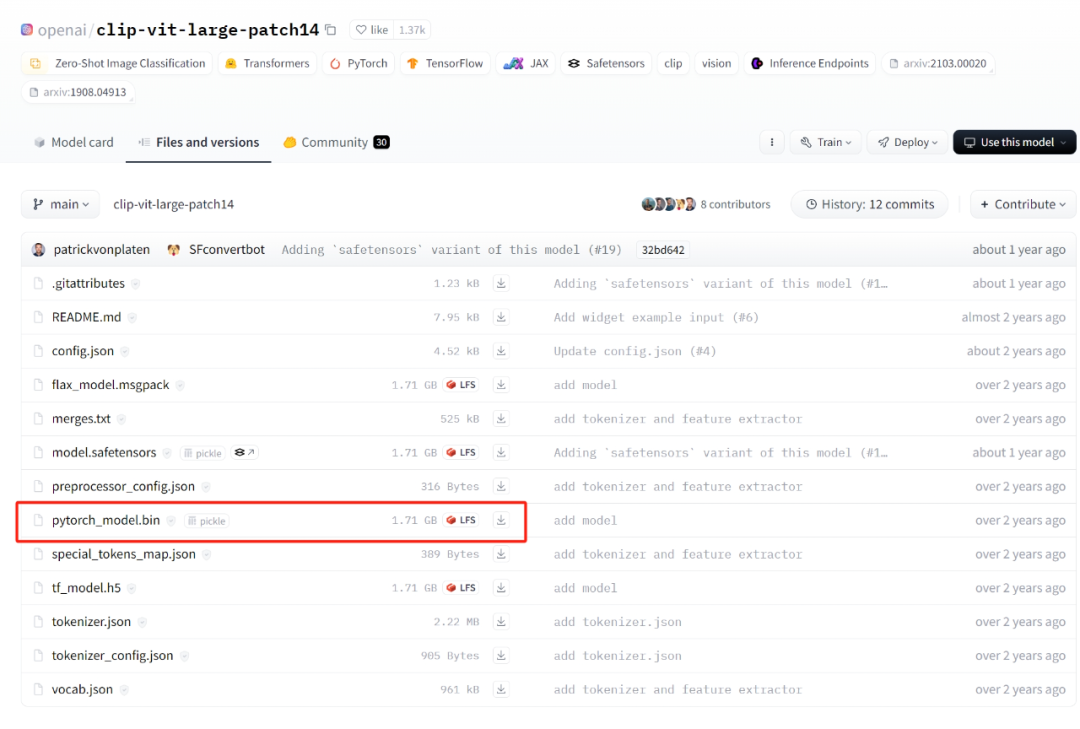

另一种是Clip_vision模型。

https://huggingface.co/openai/clip-vit-large-patch14/tree/main。

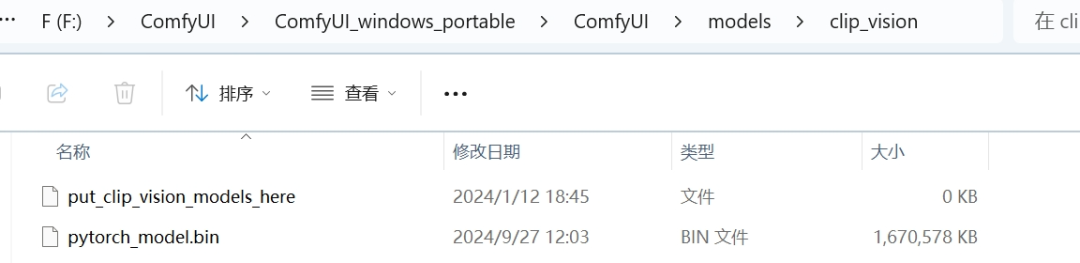

下载后放在路径上a;ComfyUI(#xff09根目录;/models/clip_vision。

另外,还需要在ComfyUI中安装一套XLAB开发节点,以支持FLUX模型的使用a;

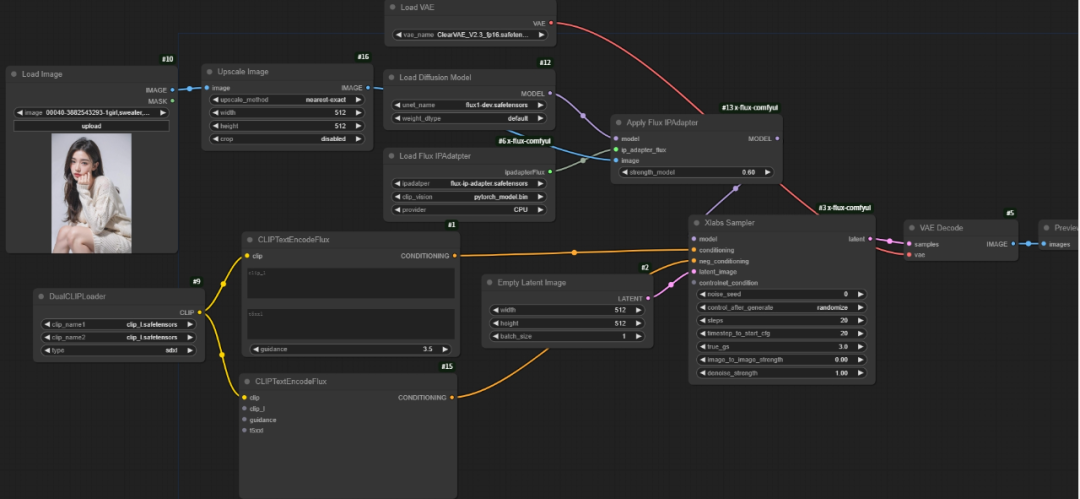

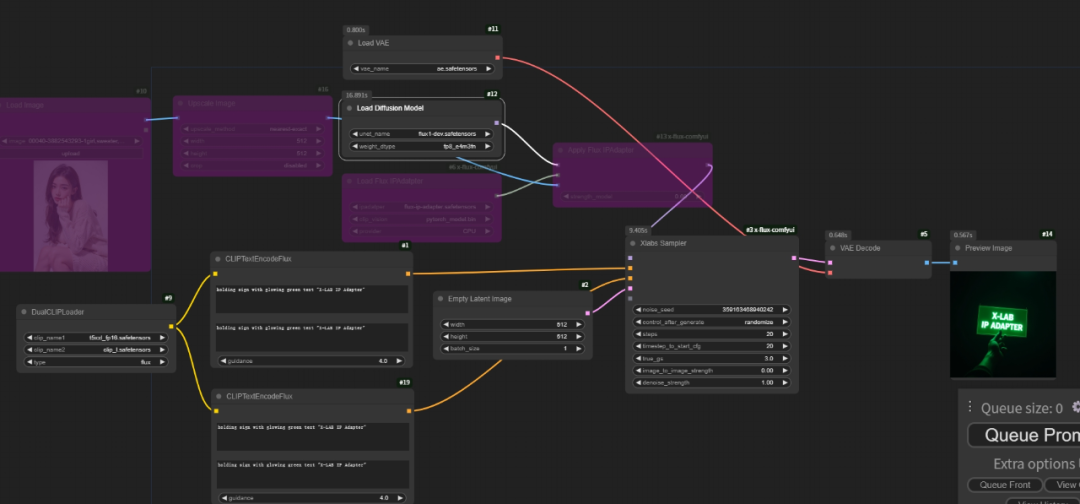

然后在ComfyUI中链接节点,在文章的最后,我将上传与原教材视频相同的工作流(原教程17:31处):

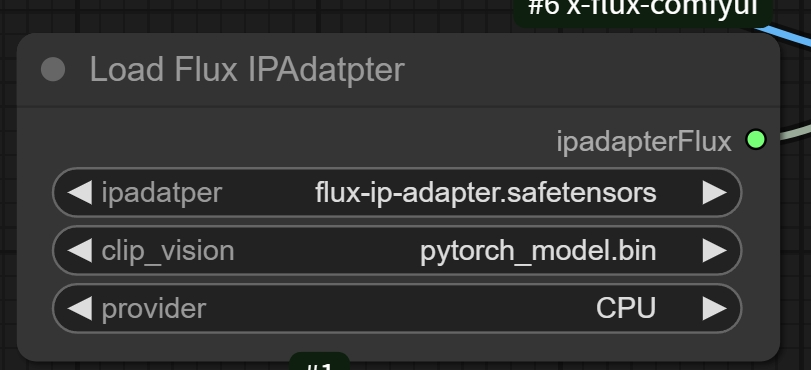

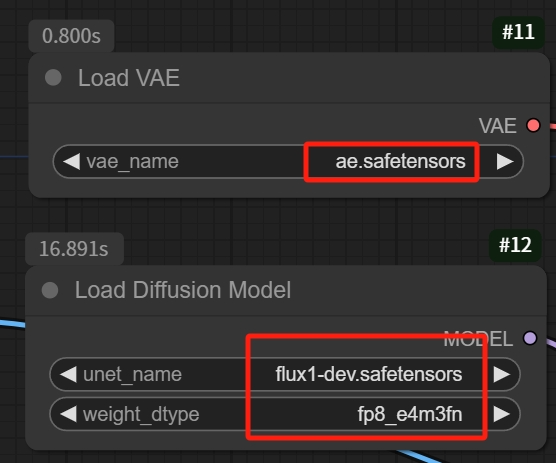

加载完成后,Load需要加载 Flux IPAdapter节点设置选项如下图所示:

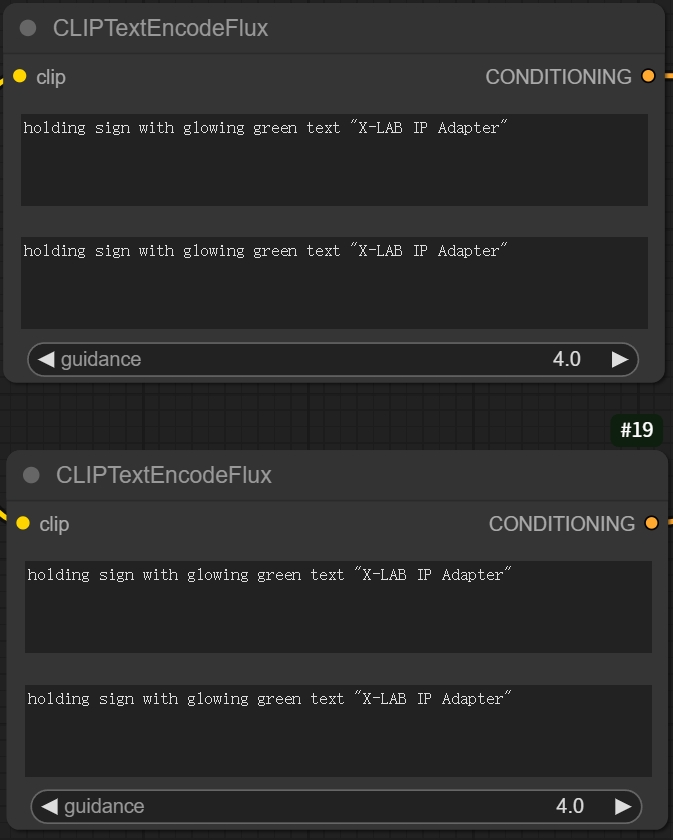

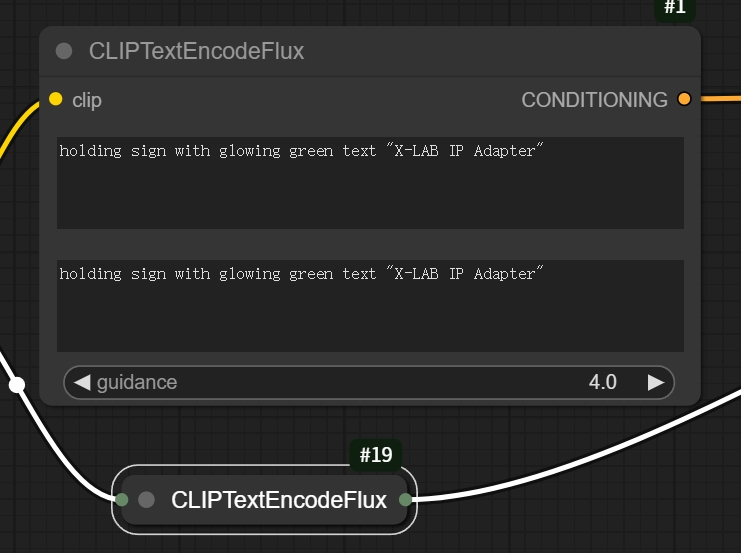

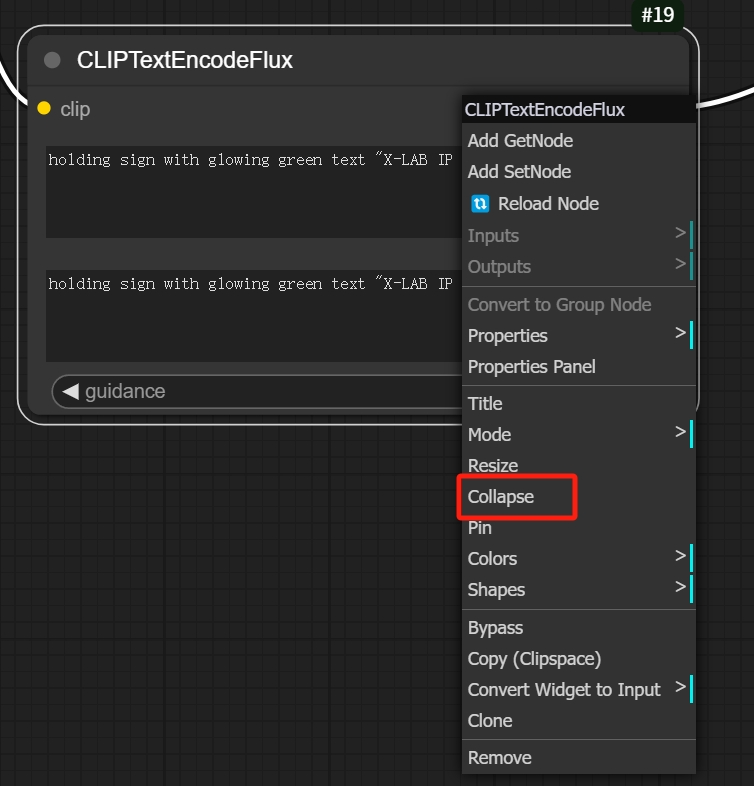

因为FLUX有两个文本编码器,所以需要两个提示输入,但是在这里写完复制到下面就可以了。

有些朋友可能见过这样的节点:

这实际上是一个压缩节点,内容没有变化:

注意模型节点的选项,有些默认情况下需要自己改变:

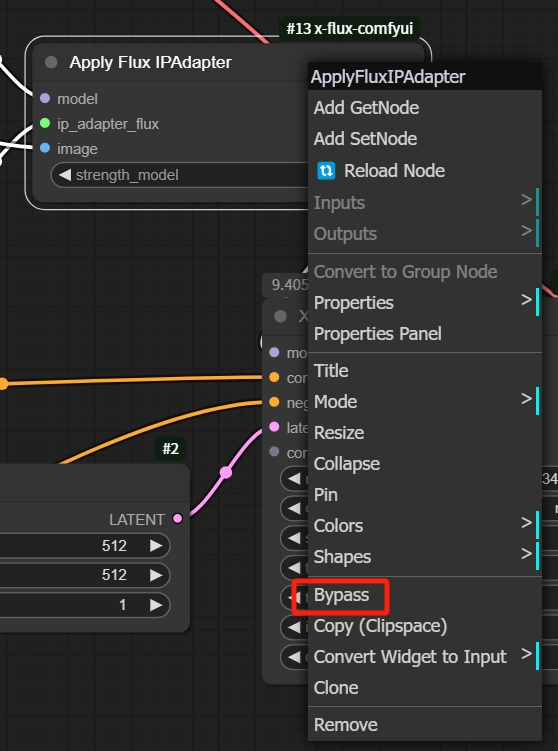

先做一个有趣的实验,当我的所有节点都没有更改时c;如果关闭IP-Adapter,将直接生成随机人物形象的“举牌”图片。

顺便说一句,如果关闭节点,则在节点右键单击以选择Bypass。

接下来,让所有节点正常运行,在图片上传处随机上传图片,然后点击生成。

IP-Adapter可以读取创作者的意图,并将参考图转换为生成图的一部分。

但风格参考只是IPA的基本用途之一,还可用于塑造人物形象,甚至为人物换衣服、换脸等,感兴趣的朋友可以自己试试。

这就是今天的内容!

在写了这五个笔记之后,我觉得FLUX更像是一个未来可以期待的东西,虽然有很多大团队致力于开发FLUX的潜力,但目前FLUX并不是首选。

更何况很多感兴趣的小伙伴,对硬件要求比较高,都被劝退了。c;如果不是4070(非移动端)以上显卡运行起来会有点困难,只能求助于在线平台或云服务器。

对于目前的AI生图领域,FLUX,现在看起来不太好用的东西,就像一个很高的成本。但相信等到后续更强大的显卡和更多的优化手段出现,FLUX终有一天会登上舞台。

下一篇文章我会更新最新的模型素材,包括FLUX学习过程中使用的东西上传到百度云供大家下载。

下一篇笔记大家都会看到#xff0c;崇拜!

写在最后。

FLUX相关模型、工作流和全套人工智能绘画学习资料已为您打包,如果需要,可以扫码自取,无偿分享。

感兴趣的朋友,赠送全套AIGC学习资料前沿科技教程和软件工具包括AI绘画、AI人工智能等c;具体看这里。

AIGC技术的未来发展前景广阔,随着人工智能技术的不断发展,AIGC技术也将不断提高。未来,AIGC技术将在游戏和计算领域得到更广泛的应用c;使游戏和计算系统具有更高效、更智能、更灵活的特点。同时,AIGC技术也将与人工智能技术紧密结合c;广泛应用于更多领域,对程序员的影响至关重要。未来,AIGC技术将继续改进,同时也将与人工智能技术紧密结合,广泛应用于更多领域。

。

AIGC各方向的学习路线。

整理AIGC各方向的技术点,形成各领域的知识点总结,它的用途在于,您可以根据以下知识点找到相应的学习资源,确保自己学得更全面。

二、AIGC必备工具。

所有的工具都帮你整理好了,安装可直接启动!

三、最新AIGC学习笔记。

当我学到一定的基础时c;当你有自己的理解能力时,阅读前人整理的一些书籍或手写笔记资料,这些笔记详细记录了他们对某些技术点的理解,这些理解比较独特,你可以学到不同的想法。

四、AIGC视频教程集合。

观看全面零基础学习视频看视频学习是最快最有效的方式,跟随视频中老师的想法,从基础到深度,还是很容易入门的。

五、实战案例。

纸上得到的时候感觉很浅,学会和视频一起敲#xff0c;动手实操,只有这样,我们才能把所学应用到实践中去,这个时候可以搞点实战案例学习。