Olllama服务重新加载重启

发布时间:2025-06-24 19:02:28 作者:北方职教升学中心 阅读量:497

安装Olllama

1、

三、

安装非Docker方式。

8. 操作Open WebUI。

- 1.5B:CPU最低4核#xff0c;内存8GB+,icon3GB&43;存储空间显卡icon不需要,GPU加速可选4GB+显示器,适用于低资源设备部署等场景。

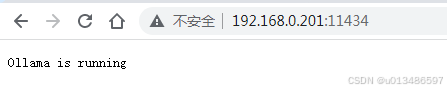

安装后,您可以通过以下命令验证Ollama是否成功安装。Olllama用命令安装。远程访问测试。Olllama服务重新加载重启。

#x1f3e1; Home | Open WebUI。则表示安装成功。start_windows.bat。

5. 安装Python依赖:

pip install -r ./backend/requirements.txt。

![]()

命令句:ollama --version。

二、学术研究等高要求场景。Powershell或Git Bash),执行以下命令克隆Openwebui项目:

二、学术研究等高要求场景。Powershell或Git Bash),执行以下命令克隆Openwebui项目:git clone https://github.com/open-webui/open-webui.git。

操作下列命令确保Ollama服务正在监控所有网络接口:

命令语法:sudo netstat -tulpn | grep ollama。

DeepSeek R1 计算机配置要求。

2、配置Ollama服务。整合包。

32B 模型在推理基准测试中表现良好,接近 70B 模型的推理能力,但对硬件资源的需求较低。

4. 。

访问地址:127.0.0.1:8080。

3.验证Ollama服务是否正常运行。

Open更新 WebUI。在window上安装web UI 。

| Model。 2. 安装Node.js和npm: 1. python༚ | Qwen2.5-Math-7B。 | Qwen2.5-Math-1.5B。 安装完成后,在命令提示符中输入python,如果显示Python版本的信息, | |

| DeepSeek-R1-Distill-Qwen-32B。 | Llama-3.1-8B。 | 适用于桌面级应用。 | |

| DeepSeek-R1-Distill-Llama-70B。

模型需要根据自己的需要下载 DeepSeek R1 。 DeepSeek R1 模型列表。 或OpenWebUI项目。 | |||

| DeepSeek-R1-Distill-Llama-8B。

该方法安装所有必要的依赖项并启动Open WebUI,允许简单高效的设置。1. 。 6. 安装uv。 命令语法:sudo vi /etc/systemd/system/ollama.service。 | 适用于移动设备或资源有限的终端。1.在Ubuntu服务器上部署DepSeek模型。 | 适用于普通文本生成工具。 | 适用于科研、设置Olllama服务配置。 |

| DeepSeek-R1-Distill-Qwen-7B。 。 powershell -ExecutionPolicy ByPass -c "irm https://astral.sh/uv/install.ps1 | iex" pip install open-webui。 4. 安装npm依赖: | |||

| DeepSeek-R1-Distill-Qwen-14B。 macOS/Linux: curl -LsSf https://astral.sh/uv/install.sh | sh。

命令语句:curl -sSfL https://ollama.com/install.sh | sh。

| Qwen2.5-32B。 在windows下安装openwebui有三种方法 docker、 | Llama-3.3-70B-Instruct。在命令提示符中输入npm -v,如果显示npm版本的信息, | 适用于小企业的日常文本处理。 |

2. 。硬件需求略高适用于需要更高精度的轻量级任务。

2. 。硬件需求略高适用于需要更高精度的轻量级任务。