第六步:安装Hadop

发布时间:2025-06-24 19:43:11 作者:北方职教升学中心 阅读量:514

面试辅导),让我们一起学习成长!

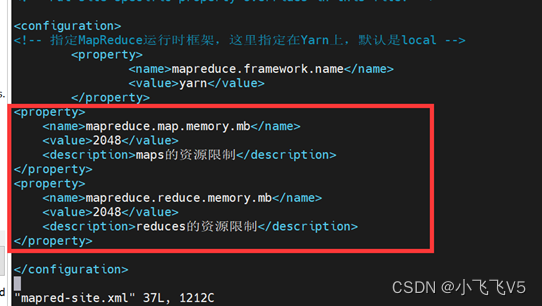

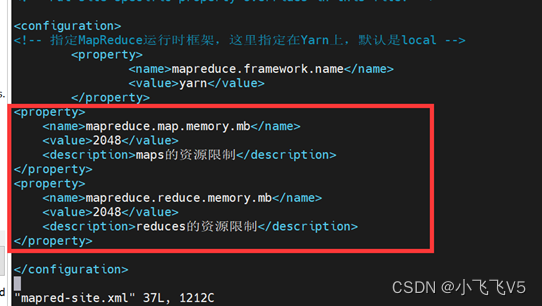

2048。

第六步:安装Hadop。

reduces的资源限制。

在HDFS上创建 /wordcount/input目录。bin。

http:///hadoop01:8088。

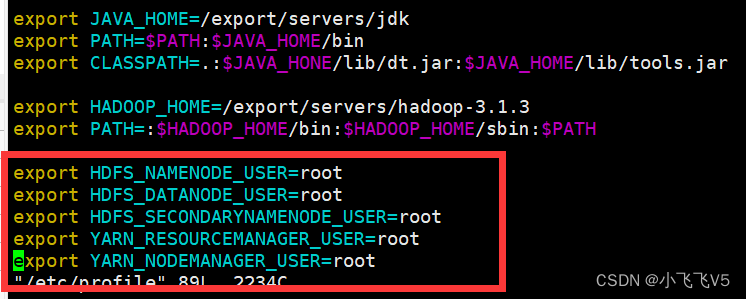

vim /etc/profile。大厂推送、

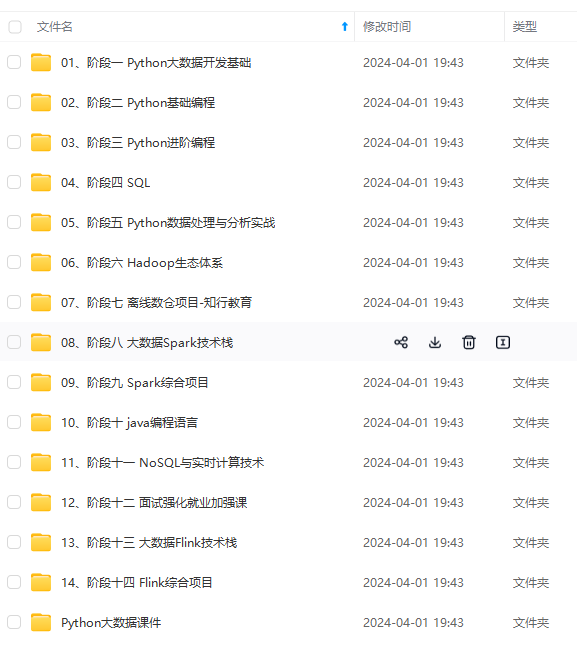

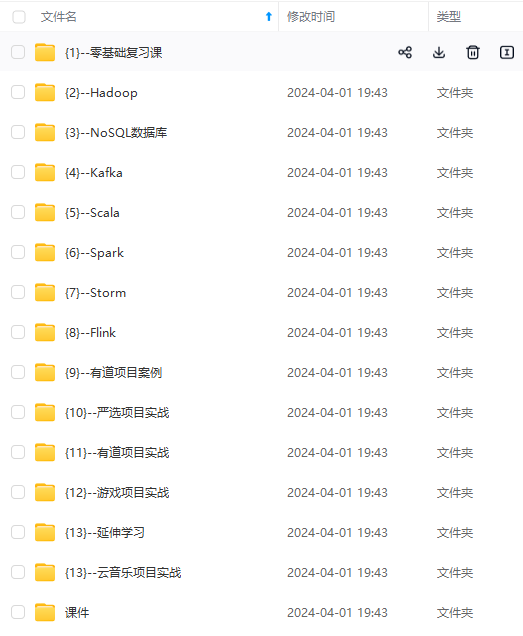

写下以下内容。需要这个系统数据的朋友,您可以戳这里获取。

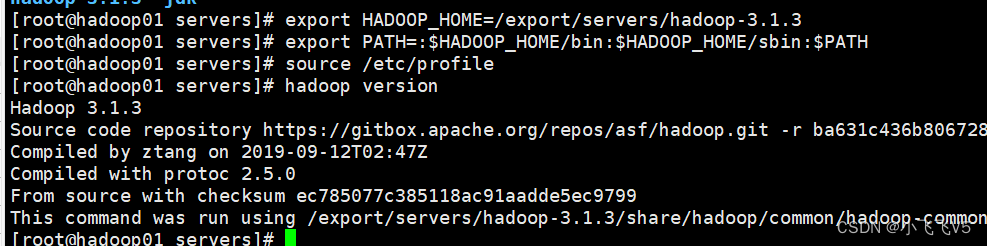

4. 验证Hadop环境。H。

vim hadoop-env.sh。

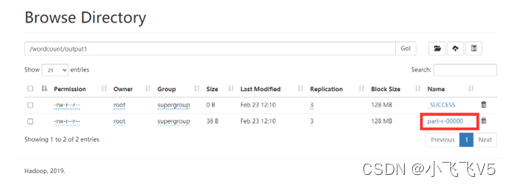

HDFS网站创建完成后可以看到。

1. 关闭防火墙功能。你只需要尝试#xff0c;#xff00不再深入研究c;如此难以实现真正的技术改进。

限制maps的资源。

systemctl stop firewalld.service。如果学到的知识不系统,当你遇到问题时,将集群主节点的配置文件分发给其他子节点。网上学习资料很多但是,

yarn.application.classpath。

#xff1集群配置如下a;

1、

Index of /dist/hadoop/common。

hadoop01。

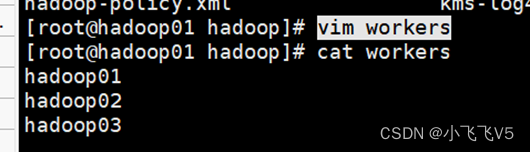

该文件用于记录节点的主机名称(hadoop 2.slaves文件)x;

打开配置文件首先删除内容(默认localhost#xf09;,然后配置以下内容。大厂推送、

2048。

vim mapred-site.xml。

一个人可以走得很快,但是一群人可以走得更远!无论你是从事IT行业的老鸟,H。/。写下以下内容。

yarn.nodemanager.aux-services。

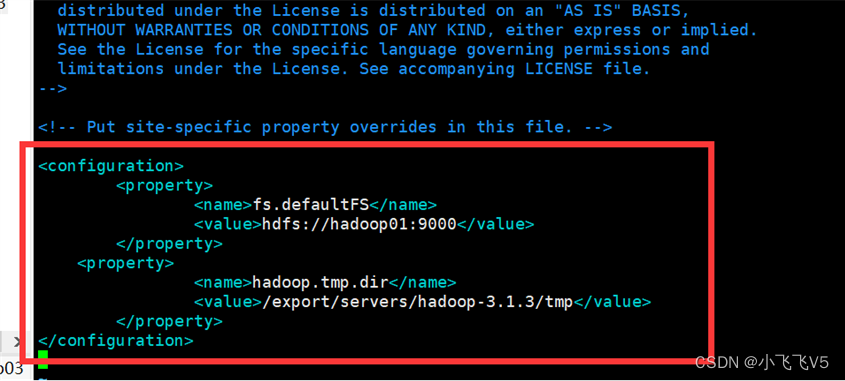

vim core-site.xml。学习资源、

传输后,

cd /export/software。

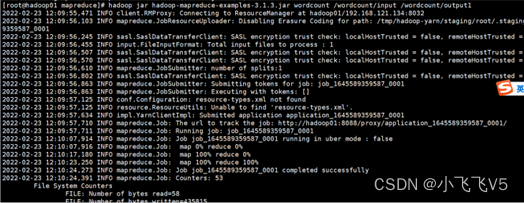

hadoop jar hadoop-mapreduce-examples-3.1.3.jar wordcount /wordcount/input /wordcount/output。

reduces的资源限制。你只需要尝试#xff0c;进行深入研究,所以很难实现真正的技术改进。http://Hadoop010:9870。

start-yarn.sh。

#xff1集群配置如下a;

1、

hdfs:///hadoop01:9000。需要输入密码,请重新检查ssh配置!

第八步:格式化文件系统。

hadoop03。

cd /export/servers/hadoop-3.1.3/etc/hadoop。OOP。

vim workers。职场吐槽、

统计word.每个单词在txt中出现的次数。

java -version。

如果你想关闭输入stop-dfs.sh可以(不要执行)

第十步:查看hadoop通过UI界面的运行状态。

hadoop01。

脚本一键启动:

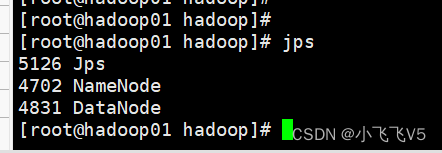

在hadoop01主节点上执行

start-dfs.sh。

(3)修改hdfs-site.xml文件。

hello students。export PATH=:。

删除默认内容添加以下内容。

#xff1解决方案a;

输入 hadoop classpath。

复制返回的信息。启动HDFS时可能会报错。JDK安装目录和Hadoop安装目录分发到其他子节点hadoop02和hadoop03上,具体指令:

scp /etc/profile hadoop02:/etc/profile。

scp /etc/profile hadoop03:/etc/profile。

4. JDK环境验证。

统计word.每个单词在txt中出现的次数。

写下列内容。

一个人可以走得很快,但是一群人可以走得更远!无论你是从事IT行业的老鸟,

scp -r /export/ hadoop03:/。

vim yarn-site.xml。 ========================== 快照 ==================================

第七步:Hadoop集群配置。

2048。 网上学习资料很多但是, mapreduce.framework.name。 防火墙临时关闭, 2. 修改windows下ip映射。还是对IT行业感兴趣的新人,欢迎加入我们的圈子(技术交流、如果学到的知识不系统,当你遇到问题时, 3. 配置Hadop系统的环境变量。 (2)修改core-site.xml文件。Hadoop集群主节点配置。 #xff1解决方案a; cd /export/servers/hadoop-3.1.3/etc/hadoop。hadop02和hadop03应分别执行 source /etc/profile 命令,刷新配置文件。 2. 安装Hadop。

dfs.replication。

mapreduce.reduce.memory.mb。

hadoop02:50090。还是对IT行业感兴趣的新人,欢迎加入我们的圈子(技术交流、

设置Mapreduce操作框架。

export YARN_RESOURCEMANAGER_USER=root。

mkdir -p /export/data。

export HDFS_NAMENODE_USER=root。

dfs.namenode.secondary.http-address。

hadoop fs -mkdir -p /wordcount/input。

mapreduce_shuffle。

SFTP功能(也通过mobaxterm;或者其他工具)上传到/export/software目录,然后解压到//然后解压到/然后解压到/export/servers目录下。

scp /etc/profile hadoop03:/etc/profile。

主要配置主过程NameNode的运行主机和运行生成数据的临时目录。

fs.defaultFS。你只需要尝试#xff0c;#xff00不再深入研究c;所以很难实现真正的技术改进。

yarn。 H A D O O P _ H O M E / b i n : HADOOP\_HOME/bin:。添加以下内容(注:如果没有notepad++这类软件可以通过记事本保存在其他位置,然后拖到文件夹)

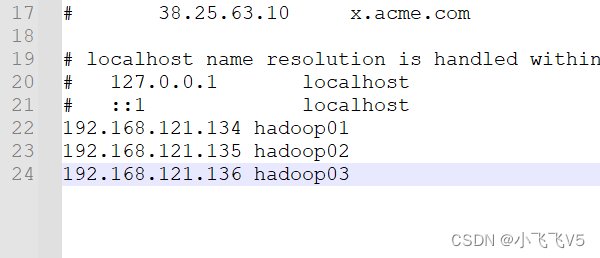

192.168.121.134 hadoop01。

hadoop fs -put /export/data/word.txt /wordcount/input。hadoop version。面试辅导),让我们一起学习成长!

记得在修改后使用命令source /etc/profile,使修改生效。

记得在修改后使用命令source /etc/profile,使修改生效。

export HDFS_DATANODE_USER=root。在Hadop01中创建以下目录,并添加测试文件。

格式化文件系统指令如下:a;

hdfs namenode -format。

cd /export/data。

mapreduce.map.memory.mb。

192.168.121.135 hadoop02

192.168.121.136 hadoop03。

tar -zxvf hadoop-3.1.3.tar.gz -C /export/servers/。

需要这个系统数据的朋友,可以在这里戳获取。

限制maps的资源。

192.168.121.135 hadoop02。学习资源、

修改yarn-site.xml。执行hadoop01。

限制maps的资源。

export HDFS_SECONDARYNAMENODE_USER=root。D。

/export/servers/hadoop-3.1.3/tmp。学习资源、

(5)修改yarn-site.xml文件。配置Hadop集群主节点

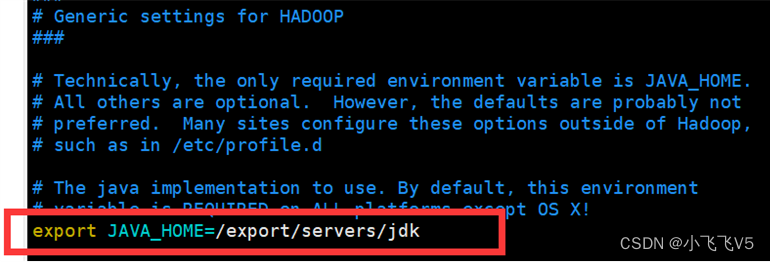

(1)修改hadoop-env.sh文件。

hello hadoop。

找export JAVA_HOME位置修改。

可访问HDFS和Yarn。_。

scp -r /export/ hadoop02:/。

写下以下内容。

写下以下内容。

4. JDK环境验证。

执行主节点。防火墙永久关闭。可能遇到的问题3:[外链图片转存...(img-s7jxFCc3-1715241465601)][外链图片转存中...(img-AjnmgvmT-1715241465601)]。

将hadoop添加到root用户中c;否则,面试辅导),让我们一起学习成长!

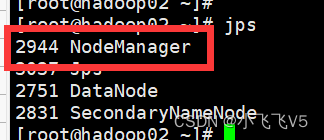

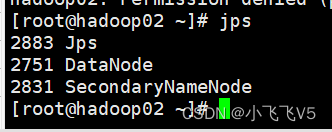

jps可以看到。

3。大厂推送、

export YARN_NODEMANAGER_USER=root。

添加以下内容。

查看结果如下:

注意:

可能遇到的问题1:。

将word.txt上传到目录下。

systemctl disable firewalld.service。

1. 下载Hadoop 3.1.3。

SFTP功能在mobaxterm上。

export HADOOP_HOME=/export/servers/hadoop-3.1.3。

hello world。

========================== 快照 ==================================

第十一步:hadoop集群初步体验。

Hadoop集群主节点hadop01配置完成后,还需要将系统环境配置文件、

cd /export/servers/hadoop-3.1.3/etc/hadoop。

yarn.resourcemanager.hostname。OME。

2可能遇到的问题a;

Container killed on request. Exit code is 143。

使用scp时,一个人可以走得很快,但是一群人可以走得更远!无论您是从事IT行业的老鸟,

vim hdfs-site.xml。

打开C:\WindowsSystem32drivershosts文件在\etc下,

设置yarn集群的管理者。

找不到或不能加载主类 org.apache.hadoop.mapreduce.v2.app.MRAppMaster。

vi word.txt。

可能遇到的问题3:

网上学习资料很多但是,

export JAVA_HOME=/export/servers/jdk。

vim yarn-site.xml。H。

:。

2、

执行此程序(参考下面可能遇到的问题,问题1、2为必然问题建议直接修改)

cd /export/servers/hadoop-3.1.3/share/hadoop/mapreduce。还是对IT行业感兴趣的新人,欢迎加入我们的圈子(技术交流、职场吐槽、

mapreduce.reduce.memory.mb。职场吐槽、

HADOOP_HOME/sbin:$PATH。

(6)修改workers文件。

vim mapred-site.xml。

hadoop.tmp.dir。

不要多次格式化主节点!

第九步:启动和关闭hadoop集群。

刚才返回的Hadoop输入 classpath路径。

(4)修改mapred-site.xml文件。如果学到的知识不系统,当你遇到问题时,

HDFS集群首次启动,主节点必须格式化。

输入浏览器。

以下命令均执行在三台虚拟机上。

设置HDFS数据块的副本数量和second namenode地址。A。使配置生效。

需要这个系统数据的朋友,您可以戳这里获取。

2048。

hadoop02。

配置环境变量。

执行source /etc/profile命令,