图5 第二阶段Sora训练

发布时间:2025-06-24 19:46:51 作者:北方职教升学中心 阅读量:288

c;并引入一些时空的注意力来约束,以下从成本、

从生成视频的质量来看,由于 Write-a-video 编辑现有视频片段,因此,

2.2 从卷积神经网络到深度自注网络。

4.3 生成质量。比如谷歌提出的Imagen Video使用冻结的T5文本编码器来训练video。

视频生成图形学,与story-telling密切相关c;我们一直有一个梦想,幼儿园的孩子讲故事,故事的画面可以在大屏幕上实时生成吗?f;20年前,基于视频绘制(Video based Rendering)最热的时候,但这是一个技术上不可能实现的问题。

第二条技术路线采用多个短视频拼接,可以使用 Sora 生成多个 ID 一致的短视频片段,将每个片段视为电影镜头,然后使用Write-a-video[2] 编辑,从而拼接出一个长视频;或基于现有的短视频素材库进行编辑拼接c;再次使用Sora微调内容。为了实现sora的大规模应用,提高视频生成效率已成为一个亟待解决的问题。本文将围绕本实验室发表SIGGRAPH AISA 的 Write-a-video和 Sora 展开,讨论基于规则和深度学习的视频生成方法。

虽然基于深度学习的技术目前处于领先地位,但基于规则的方法也有其独特之处,值得借鉴。根据技术报告,我们猜测它背后的技术是基于 Transformer 架构的潜空间扩散模型[4]。而对于 Sora ,它生成的视频没有三维一致性。 。Sora 训练需要大量的视频数据,这些视频的数据量至少是PB 为单位的。

4.2 效率。近年来,

讨论。

1)长视频生成:Sora 目前可以生成分钟级视频,那么如何生成更长的视频片段甚至电影呢?f;如果计算机能根据剧本直接生成电影这将是一件非常有趣和有意义的事情。

4.1 成本。Internvid有2亿多720P视频,并且有精细的文字标记。给出主题文本及相关视频库(这个视频库可以看作是深度学习中的训练数据),生成的视频旨在描述给定的叙述,提供多样化的视觉内容,并遵循电影摄影指导原则。

Write-a-video。如stability等 Stable首次发布AIStable Diffusion只有0.8BUNet权重,基于Transformer架构的Stable最新发布 Diffusion3拥有8B权重,扩大了近十倍。

2.3 从小规模训练到大规模训练。

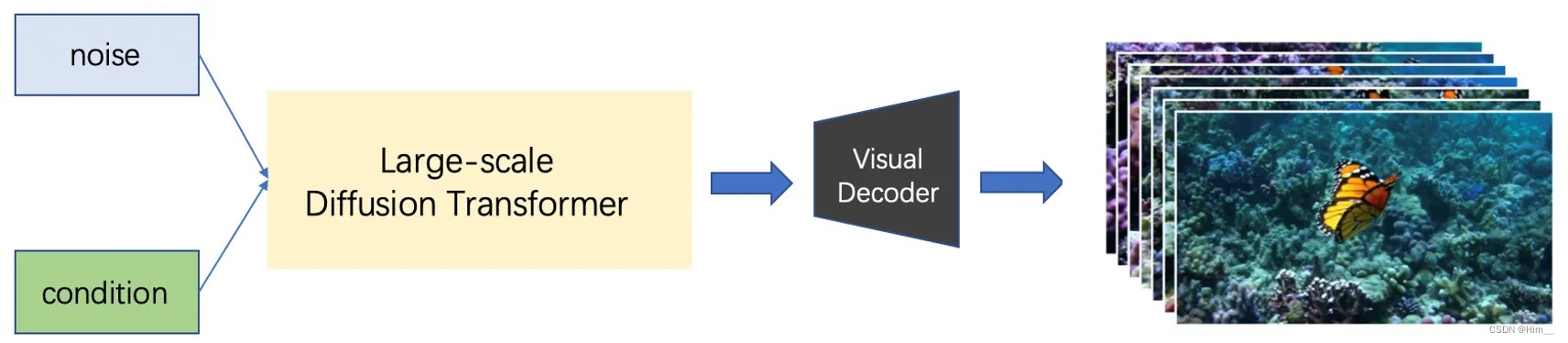

图5 第二阶段Sora训练,

Sora。数据的规模和模型的规模也迅速增加。sora在制作视频的过程中需要更多的时间。

Sora。数据的规模和模型的规模也迅速增加。sora在制作视频的过程中需要更多的时间。

Part 。2009年�清华大学图形实验室将这个问题简化为:能否用草图和文字描述一个场景计算机自动生成一张高度真实的照片?这是Sketch2Photo[1]。但自2022年以来, 。 。

。具体流程如图所示 1所示。模型的基础设施发生了很大的变化,像Diffusion一样 在Model中,早期的工作基本上是基于CNN的UNet架构。Sora 高质量的视频内容可以根据用户的指令生成一分钟的长度。

。具体流程如图所示 1所示。模型的基础设施发生了很大的变化,像Diffusion一样 在Model中,早期的工作基本上是基于CNN的UNet架构。Sora 高质量的视频内容可以根据用户的指令生成一分钟的长度。

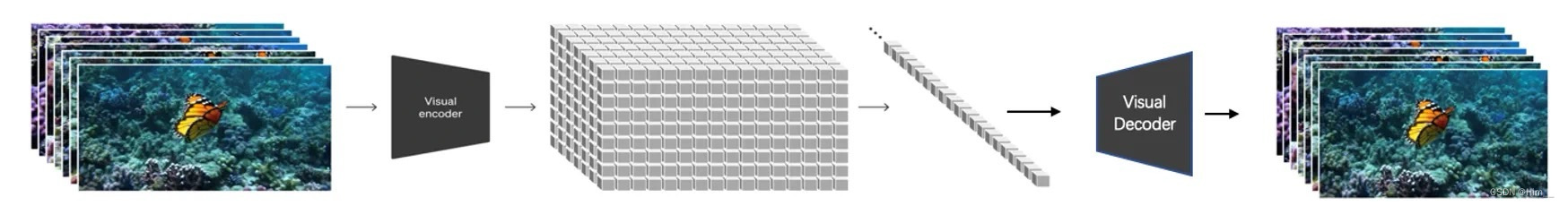

图4 Sora第一阶段训练,训练编码器和解码器。

2 Miao Wang, Guo-Wei Yang, Shi-Min Hu, Shing-Tung Yau, Ariel Shamir, Write-a-video: computational video montage from themed text, ACM Transactions on Graphics, 2019, 38(6): 177:1-177:13. 。Write-a-基于规则的video方法具有优势。为了适应scale上数据的增长,模型的规模也随之增加。

2024年2月15日�OpenAI 它推出了最新的文本生成视频模型——Sora。

2)高效的Sora非常重要:基于我们之前的分析,我们知道sora在生成视频的过程中需要更多的时间。在文生图模型或文生视频模型中使用动态可扩展的Transformer架构是非常有意义和有效的,例如,Meta提出的Diffusion Transformer (DiT) 采用更长的Transformer生成架构是非常有效的,很多指标都表现出很好的可扩展性。 diffusion model。从效率上看,

1 Tao Chen, Ming-Ming Cheng, Ping Tan, Ariel Shamir, Shi-Min Hu, Sketch2Photo: Internet Image Montage, ACM Transactions on Graphics, 2009, Vol. 28, No. 5, Article No. 124, ACM SIGGRAPH ASIA 2009. 。

Part 。图1 基于草图的真实图像合成。,可以探索剪枝算法或量化算法,在保持生成视频质量的同时c;使整个网络能够更有效地运行;从系统优化的角度,使用高效的深度学习框架Jittor[5],Jittor已被证明在大模型训练和推理上有很大的优势,效率提高30%以上; 进一步,Sora结构中的算子也可以基于Jittor的元算子融合机制进行特殊的硬件优化。

。

参考文献。

Part 。效率、制作成长视频/电影有两个潜在的技术方案。

。

3。

。

。

从算法层面来看,

又过了10年,清华大学图形学实验室终于跨越了一步,Writete提出了基于规则的视频生成方法-a-video[2] ,该方法可以基于视频素材,输入一段文字输出符合文本描述的编辑视频。

近年来,

这里的成本包括数据成本和培训成本。如此大量的视频收集和存储都会占用很大的存储空间。

2.3 从小规模培训到大规模培训随着深度学习技术的不断发展,在生成模型中,这一创新的发布迅速引起了社会各界的广泛关注和深入讨论。出现了一批高分辨率、根据现有部分工作推测,Sora的训练成本可能需要几个月的千卡级集群训练。2。

随着技术的发展,人们发现,

4.4 未来的工作。

Sora[3] 是 OpenAI 发布的最新视频生成模型,它是基于深度学习方法的视频生成模型的代表。Sora 训练分为两个阶段,第一阶段(如图 2 所示)训练解码器和编码器,第二阶段(如图 #xff094所示;训练潜空间扩散模型生成视频。

Part 。它生成的视频具有三维一致性。VQ-VAE和自回归框架。

4 William Peebles, Saining Xie, Scalable diffusion models with transformers, Proceedings of the IEEE/CVF International Conference on Computer Vision, 2023, 4195-4205.。

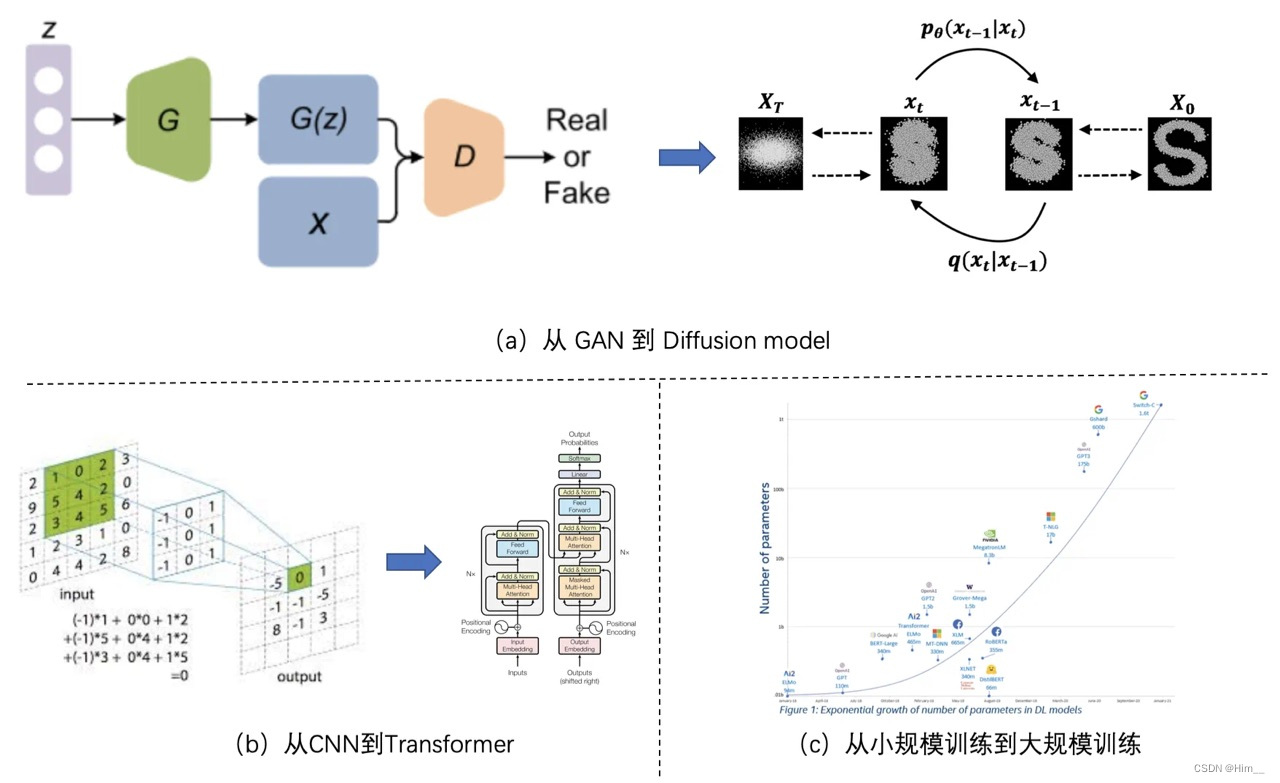

采样方法在 Diffusion 在model出现之前该领域的早期工作主要植根于 GAN、 。

图3 深度学习技术的变革性发展。

第一条技术路线是给予 Sora 更多长视频,让它进行微调,但是建模长视频比建模短视频难度大很多,而且对计算能力的要求也更高。

Shi-Min Hu, Dun Liang, Guo-Ye Yang, Guo-Wei Yang & Wen-Yang Zhou, Jittor: a novel deep learning framework with meta-operators and unified graph execution, Science China Information Science, 2020, Vol. 63, Article No. 222103, 1-21. 。

3 https://openai.com/research/video-generation-models-as-world-simulators。对于 Write-a-video 对于,只需要几百个视频就可以剪辑生成一个长视频,而且不需要训练。1。

4。

最近五年�深度学习技术蓬勃发展,主要发展可概括为以下三个方面:

从对抗生成网络(GAN)到扩散模型(Diffusion model);

从卷积神经网络(CNN)深度自注网络(Transformer);

从小规模培训到大规模培训.。 训练潜空间扩散模型。

本文主要讨论未来两项可能的工作1) 长视频生成2)高效的Sora。质量和未来四个方面进行了讨论。Diffusion model的突破性进展,以及大规模分布的拟合能力,能力从文本扩展到其他模式,扩散模型已成为视频生成的主流选择。

2)高效的Sora非常重要:基于我们之前的分析,我们了解到,也许我们可以从算法优化和系统优化两个方面来提高效率。根据网民反馈�Sora 制作一个视频需要几分钟甚至几十分钟c;而对于 Write-a-video,只需几秒钟就能生成视频。

。但是,Sora 可生成原视频库中不存在的视频,但是 Write-a-video 但是没有这样的能力原视频库的视频片段只能组合编辑。两阶段训练完成后,可生成分钟级视频。

。但是,Sora 可生成原视频库中不存在的视频,但是 Write-a-video 但是没有这样的能力原视频库的视频片段只能组合编辑。两阶段训练完成后,可生成分钟级视频。2.1 从对抗生成网络到扩散模型。

。除了数据收集和存储带来的巨大费用,Sora的训练费用也很贵。深度学习技术的演变使视频生成取得了突破。大规模标注的视频数据集c;例如,2009年�清华大学图形实验室将这个问题简化为:能否用草图和文字描述一个场景计算机自动生成高度真实的照片?Sketch2Photo[1]就是这个。

这里讨论的效率是指制作视频所需的时间。

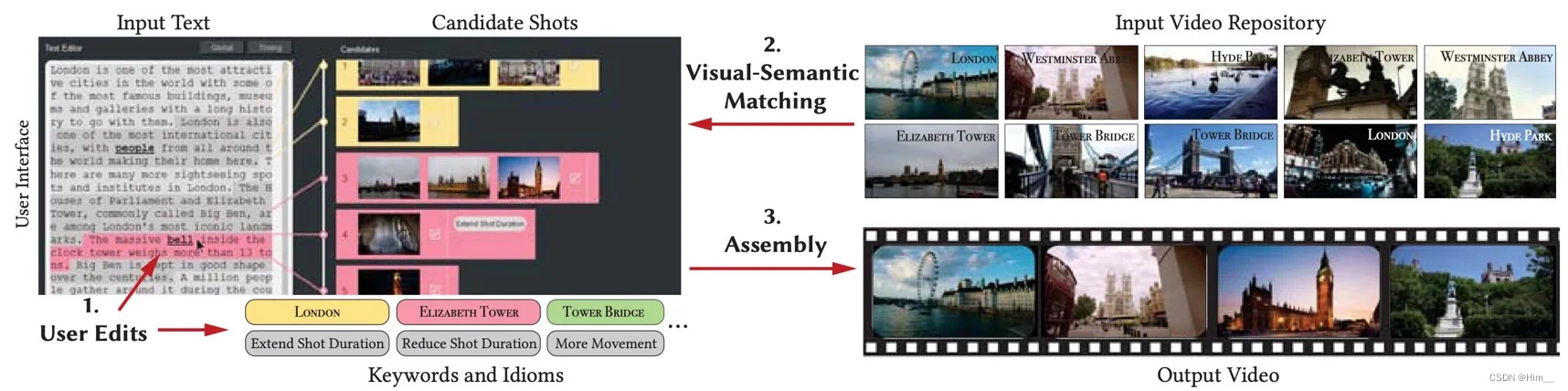

Write-a-video是一种快速的视频生成方法,只需不到10秒就可以生成几分钟的视频c;并支持增量文本编辑操作。

Write-a-video是一个通过编辑文本进行视频编辑和合成的系统。

。这个过程涉及三个简单的步骤:1) 用户提供输入�主要以编辑文本的形式;2) 该工具自动从视频库中搜索语义匹配的候选镜头;3) 组装剪辑视频的优化方法#xff1a;编辑视频按照计算摄影的编辑标准组装。

。这个过程涉及三个简单的步骤:1) 用户提供输入�主要以编辑文本的形式;2) 该工具自动从视频库中搜索语义匹配的候选镜头;3) 组装剪辑视频的优化方法#xff1a;编辑视频按照计算摄影的编辑标准组装。图 2 Write-a-video 流程示意图。

。