跑百亿大模型的笔记本?在 AMD 这里没问题

在冲向 AI PC 在轨道上,每个芯片和设备企业都害怕落后。

目前苹果生态在这场比赛中大幅领先,上周爱范儿 Mac Studio 在评估过程中,成功地在本地部署和运行 DeepSeek Q4 量化版 671B 和 70B 版本,而且 token 吞吐性能好,表现出来 M3 Ultra 芯片和高达 512GB 统一内存的力量。

而在 x86 阵营方面,目前最具竞争力的阵营「车队」AMD,试图加速超车。

在 3 月 18 日举办的 AMD AI PC 在创新峰会上,公司高级副总裁、计算图形总经理 Jack Huynh 展示了在 AMD 架构笔记本电脑运行 DeepSeek 大模型的能力。

根据现场展示,一个配备了一个 AMD 锐龙 AI Max 395 处理器笔记本电脑运行顺利 DeepSeek-通义千问融合 7B 大模型。Token 秒速不公开,但根据现场肉眼观测结果,结合我们过去在不同型号上测试的经验,现场速度至少应该达到 15 tok/s 以上。

需要注意的是,根据现场情况, demo 区域显示,这一部署和运行结果依赖于 AMD StrixHalo LLM 软件,一个 AMD 大模型运行环境的开发。根据我们的理解,背后的逻辑很简单,AMD 内部优化支持的大型模型,显著减少单位 token 通过锐龙激活参数成本,然后支持能力 AI 软件安装在用户本地设备上。

而锐龙 AI Max 处理器家族本身也支持更高的显存分配能力。我们在现场看到,AI Max 支持最高 96GB 显存分配使处理器集显得到高端独立显卡的性能,可用于 AI 游戏中也可以使用训练和推理计算。

优化后,无论参数有多大,都不用担心。在 demo 在区域示例中,我们可以看到华硕上述同一芯片 ROG 幻 X 2025 在笔记本电脑上,最高可以运行, Meta 开发的 Llama 3.1 70B 大语言模型。

虽然参数很大,但过去对硬件的要求也很高,但远远超过了过去行业对移动计算设备本地推理能力的认知上限——笔记本电脑现在也可以顺利、轻松地运行数百亿参数的大型模型。

AMD 这样做的目的是确保基于大模型的企业级应用和科研能力得到普及 x86 阵营的笔记本,甚至配备了更轻的移动计算设备。目前,AMD AI PC 环境支持 DeepSeek 1.5B、7B 大模型等主流型号。

如果笔记本不够,AMD 它还为真正的重型用户提供了运行能力 DeepSeek R1 全参数大模型服务器方案领先英伟达一步(后者可能会在明天凌晨更新) AI 计算集群模块化产品)。

现场展示了两种不同的方案,一种是 AMD 基于自主方案 vllm 框架,采用 8 x W7900/78000 显卡可以完全离线本地部署 DeepSeek 为企业内部研发和知识产权保驾护航的671B。

其二是 AMD 与群联电子合作 aiDAPTIV 方案的一般逻辑是让显卡通过 NAND 闪存扩展内存,从而打破单卡显存瓶颈。通过现有 AMD 显卡也可以以单机的形式实现 DeepSeek 671B 全参数级训练能力。

当然,大多数人只是纯粹的 AI 用户,而不是开发者。所以 AMD 峰会现场也和 OEM 合作伙伴展示了各种主流形式的消费水平 AI 应用。

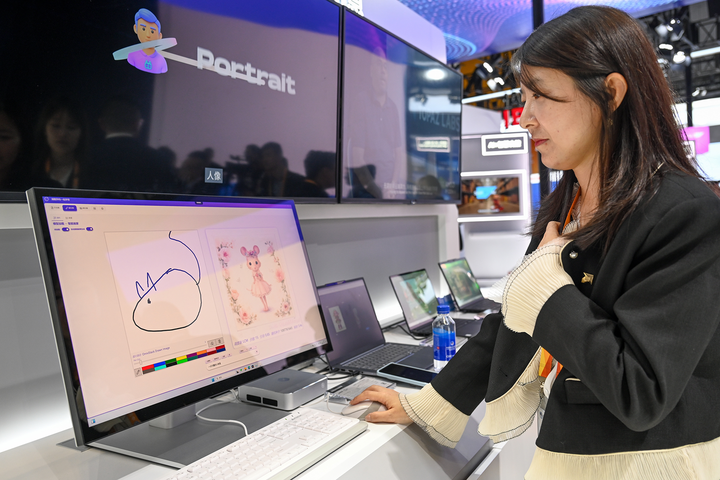

有趣的是现场 demo 其中一个是基于清醒异构开发的 AMD Ryzen AI 平台的大模型图片生成工具「绘梦师」。它支持文生图、图生图、边画边生图等生成模式,无需网络即可在本地运行。

另一个例子是联想展示的个人智能体「小天」作为 PC 端的 AI 入口背后的大模型可以根据个人数据进行培训和优化,具有任务分解和规划、自然交互、长期记忆、工具呼叫等能力。

最近一年,AI 技术发展太快,能力上限不断提高,大型模型的选择也日益增多。但由于设备的本地计算能力,PC 该行业也面临着巨大的挑战。

考虑到目前最大的朋友面临着非技术困难,AMD 作为 x86 阵营的另一家底层计算技术龙头制造商认为,他必须承担责任,迎接挑战,领导变革,让 AI 能真正通过 AI PC 进入千家万户,千行百业。

在峰会上,AMD 给了 OEM 合作伙伴展示机会的机会很大。微软、联想、华硕、宏碁、惠普等生态合作伙伴都带来了基于最新的生态合作伙伴 AMD 锐龙 AI 处理器家族 PC 新品。

AI PC 选择品牌和型号的宽度,AI PC 对于产品本身的大模型操作能力,以及不同消费场景的应用丰富度, PC 品牌和芯片制造商在这里 AI 时代保持这个阵营的市场份额尤为重要。